�܂�����

��1�́@���v�����f�[�^�ƌ덷

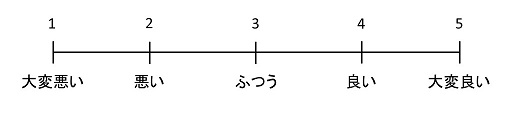

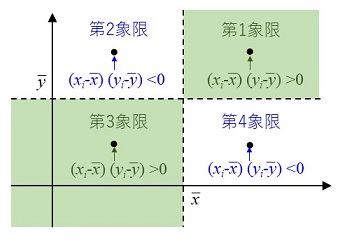

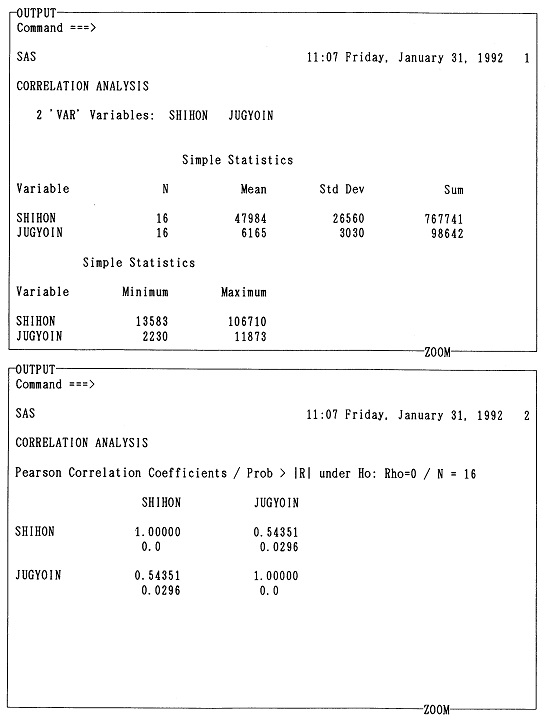

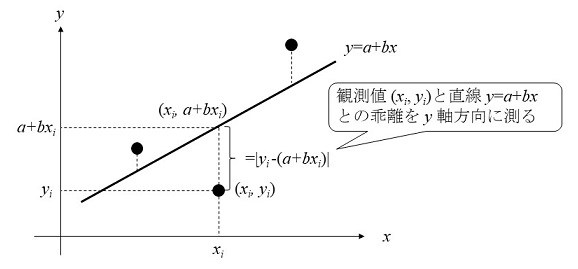

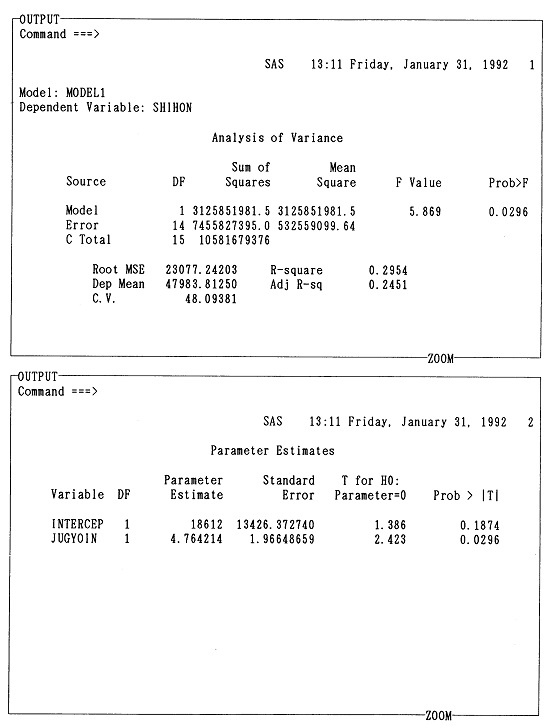

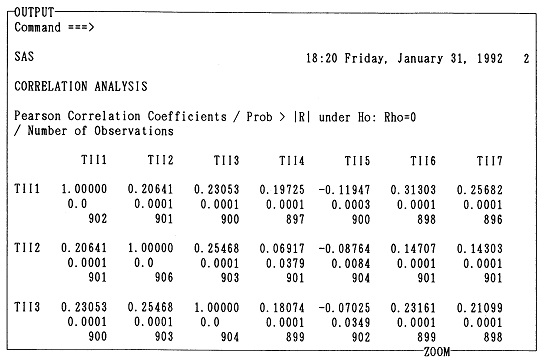

��2�́@SAS����: �P���W�v

��3�́@�f�[�^�̋L�q�ƕ���

��4�́@���ւƉ�A

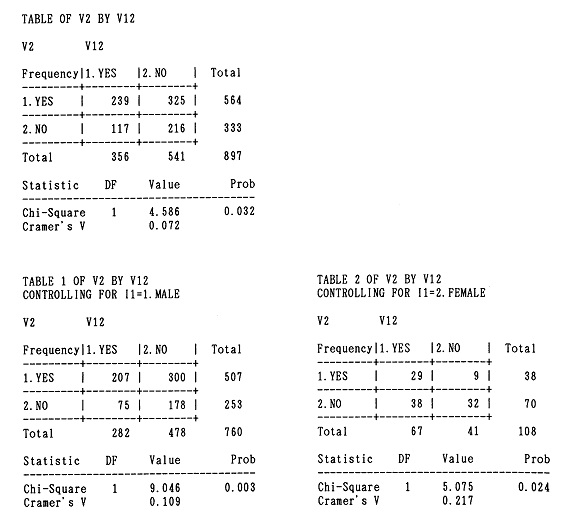

��5�́@�N���X�\

��6�́@�����̎菇�Ǝ���: �u�g�D�������̂��߂̏]�ƈ��ӎ������v�}�j���A��

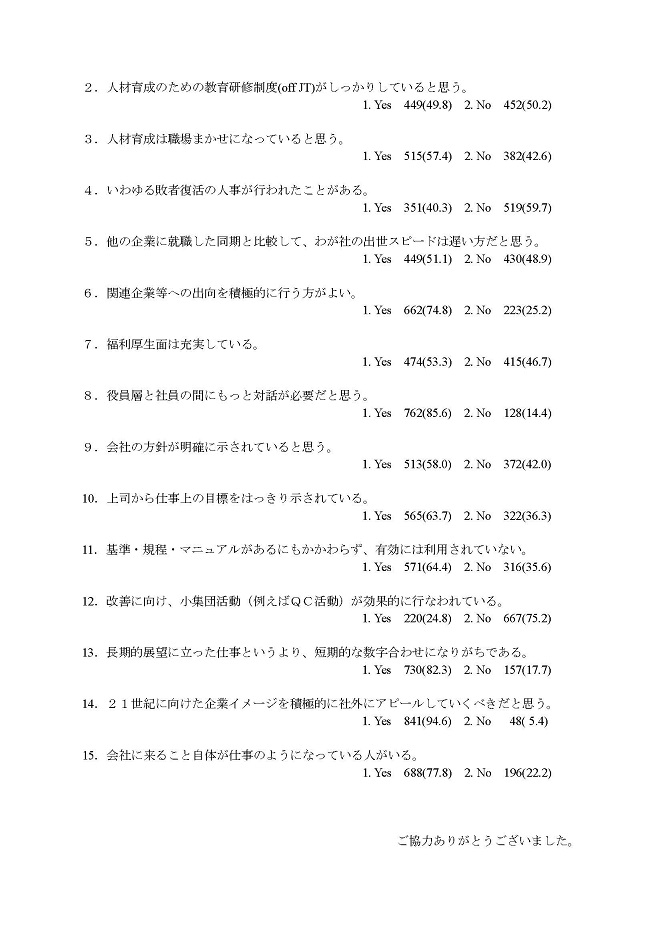

�t�́@CMS����

�Q�l����

�@��w�ɓ���Ɓu���v�w�v�Ȃ�Ȗڂ�����B���������Ă���B���Ȃ�̐l�����C���炢�͂��Ă݂邱�ƂɂȂ�͂����B���������������B�Ƃ��낪�A�����̐l�͎����ɂ͊W�̂Ȃ��ȖڂƑ��X�Ɍ��߂Ă��܂��B�����l���̒��ŁA���̎������ƁA���v�w�������Ŋw�ԋ@��͂��������Ă��Ȃ��̂ɁB

�@������8�N�قǑO�A�������v�w�����̂܂���������Ă������̂��b�B����ƊE�c�̂��璲���̈˗�������A���̉������œ��v���������������Ƃ��������B�������ʂ��܂Ƃ܂�A�����ŏI�Ƃ��������A�������̐搶�͕��ׂŃ_�E���B���ǁA����l�ŕ�����H�ڂɂȂ����B�N���C�A���g�ł������Ƃ̒��������N���X�����A�˂�ψ���ŁA1���Ԕ��قǂł������낤���A�njR�����������I���A�u�������ӌ��E�����ⓙ�������܂��H�v�ƕ����ƁA�^�Ђ̒��������������ނ�Ɏ�������Ď��₵���B�u�搶�����悭���ɂ���w���ցx���ĉ��ł����H �d�������������ł悭�������t�Ȃ�ł����ǁA���܂ł���������ł͈̂��搶����ŁA����ȏ����I�Ȃ��Ƃ͋C��ꂵ�ĕ����Ȃ��������̂Łc�c�B�����͎Ⴂ�搶�Ȃ̂ŁA�ǂ��@��Ɓc�c�B�v

�@�v�킸���ł���B����܂ł�1���Ԕ��͉��������̂��낤�B�����ӋC����Řb���Ă����̂́A���v���Ԃ́u���ցv�W�������̂ł���(�u���ցv�ɂ��Ă͖{����4�����Q�Ƃ̂���)�B���݂����v�w�������Ă��邪�A����͐���E�ԉ��̎p�B���̎��Ԃ͂�����u�o�c�w�ҁv�Ȃ̂ŁA���Ƃ̊Ǘ��E����ɘb������@��͑����B���̂Ƃ����������������A10�l���炢�̊�Ɛl��ɁA���v�w�̘b�𑊊ւȂ瑊�ւƂ����T�O�����ɍi���āA�������m���߂Ȃ���P���Ԃ����ؒ��J�ɐ������Ă�����ƁA�قƂ�ǂ̐l�͂���Ɗ��������ɂ��Ȃ����Ȃ��疞�����ċA���Ă����B����͂���ŋ��t�����ɐs����b�Ȃ̂����c�c�B

�s���P����1: �����I�Ȃ��ƂɂȂ�Ȃ�قǁA�̂��Ȃ��Ă���ł͕����ɂ����Ȃ���̂ł���B���܂�����Ȃ�A�Ȃ��̂��ƁB���ʂ̐_�o�̎���́A�ł��邾�������߂ɁB�t

�@�������������A�p���������v���o������B12�N�O�A�܂���w�@�ɓ����ĊԂ��Ȃ�������̂��ƁA�w�������ɌĂꂽ�B�u�\�Z���c���Ă���̂ŁA��ƑΏۂɌo�c�ɂ��ẴA���P�[�g��������낤�Ǝv���B�N�ɂ܂����邩��D���ɂ���Ă݂Ȃ����B�v���͊�їE��Œ������s���A�Ƃ肠�����P���W�v�����͏I�����B���āA��͉�������낤?

�@���͓��v�w�̐搶�̌������ɑ��k�ɋ삯���B�u�����ł����B����ł͊�{�I�ȂƂ���ŁA����Ȗ{�ł��ǂ�ł݂���ǂ��ł����B�v��3���قnj��o���̂��铝�v�w�̃e�L�X�g���e�[�u���̏�ɕ��ׂ�ꂽ�B��������ǂ��Ƃ̂���e�L�X�g���B�l���Ă݂�ƁA���Ƃ��������Ƃ���܂łɓǂ��v�w�̃e�L�X�g�͌w�ɗ]��ł͂Ȃ����B�������A�����A��w�@�̉��K�ŁA�₽�����Ȑ������v�w�̉p���̐�发�܂œǂ܂���Ă����B�ɂ�������炸�c�c�B

�s���P����2: ���v�w�́A���ۂɎ����Ŏg���Ȃ���A�����Ă����ɂ��Ȃ�Ȃ��B�t

�@���͋C����蒼���āA�����A���ɃR���s���[�^�E�\�t�g�⒲���̓��v�����ŗ��h�ɐ�������҂��o���Ă����F�l���l�ɗ��ݍ���ŁA�R���s���[�^�̓��v�p�b�P�[�W�̎g�����̎�قǂ�������A���v�p�b�P�[�W�̃}�j���A�����蓖�莟��ɓǂ݂�����A��������k���āA���v�w�̐�发��e�L�X�g��ǂݒ������肵�n�߂��B���ɂ��Ďv���A�����ŋ�J���ďW�߂��f�[�^��ڂ̑O�ɂ��āA�悤�₭���p�I�ȃc�[���Ƃ��Ắu���v�w�v���g���K�v�ɖڊo�߂��̂ł��������A���������������w�͂̂������Ȃ��A���ǁA���̒����f�[�^�̉^���́c�c�B

�s���P����3: �ǎ��ȃf�[�^�͐��ł������������������邪�A���̈����f�[�^�́A�ǂ�Ȃɍ��x�ȓ��v��@����g���ė������Ă��A�ƂĂ�������������̂ł͂Ȃ��B�t

�@���v�w�̃e�L�X�g��ǂނƁA�f�[�^�͊��ɗ^�����Ă��邩�A���邢�̓^�_�ł��낪���Ă��邩�̂悤�Ȉ�ۂ���B�������A�ǂ�ȕ���ł���A���ۂ̌����ł́A�ǎ��̃f�[�^���W�߂邱�ƂɘJ�͂̂��Ȃ�̕�������₳���B�f�ނ�O�ɂ��ĉ����ǎ��Ȃ̂������ɂ߂邽�߂ɂ́A�f�[�^���W�̒i�K�Ŋ��ɁA���v�w�����̊ϓ_���痝�����Ă����Ȃ��Ă͂Ȃ�Ȃ������̂ł���B

�@���������̑O�̘b�ł���B���̊ԂɁA���v�w������͈�ς����B�R���s���[�^�Ɠ��v�p�b�P�[�W�̕��y�B�p�[�\�i���E�R���s���[�^�̋��ٓI�����\���B���[�v���E�\�t�g�̐i���ɂƂ��Ȃ��t�@�C���ҏW�\�͂̌���B���܂�A���v�w���g�������v�����́A�قƂ�ǘJ�͂�v���Ȃ��l��ƂɂȂ��Ă���B�������N��I�ɍs���Ă���100�ϐ��~1,000�l���x�̏]�ƈ��ӎ������ł́A���Ȃ蕪�����W�v�\�ł���l�ŏT����2�`3�����g���Ί�������B��̑O�ɂ͂P�`�Q�J���͂������Ă����̂ɁB���v�w�͂��͂�ꕔ�̌����҂̓����I�Ɛ蕨�ł͂Ȃ��B�����Ȃ�Ƃ��m�I�Ȏd��������l�ɂƂ��ẮA�����œ���I�Ɏg����c�[���ɂȂ����̂ł���B�܂�Ń��[�v���̂悤�ɁB

�@����ȓ��v�w�̐V���オ�����J���悤�Ƃ��Ă������ɁA�ꑫ��Ɍo�������Ă����������A�M�d�ł͂��������A������b�̃^�l�ƂȂ��Ă��܂����G�s�\�[�h�����I�����킯�����A�{���͂���ȋ��P�����āA�ʏ�̓��v�w�e�L�X�g�Ƃ͂܂������قȂ�R���Z�v�g�Ɋ�Â��ď�����Ă���B

�@�{���́w�o�c���v����x�Ƒ肵�Ă��邪�A���m�ɂ́u�o�c�w�҂������Ŏg���Ă��铝�v�w�Ɠ��v�p�b�P�[�W�ɂ��ď��������发�v�Ƃ����ׂ��ł��낤�B�����鋳�{���I�ȓ��发�ł͂Ȃ��B���v�w�⒲����@�A����ɃR���s���[�^�ⓝ�v�p�b�P�[�W�̎g�����܂ŁA�c�[���Ƃ��ăp�b�P�[�W�����Ă��܂����Ƃ������z���琶�܂�Ă������v�w���[�U�[�̂��߂̓��发�ł���B�{���ł͍ŏ����瓝�v�w����Ə������͗Z�����Ă��܂��Ă���B���グ������A�f�ނ��A�����g����|���Ă���o�c�w����̒����Ƃ��̃f�[�^����I�ꂽ���̂ł���B

�@���Ȃ��Ƃ����ɂƂ��ẮA10�N�O�̓��v�����ƌ��݂̓��v�����Ƃł́A�����Ă���Ӗ����[�݂��S���قȂ�ʂ̂��̂ł���B�]���́A�����Č��݂ł��命���̐l���M���Ă��铝�v�����ł́A��ςȎ��ԂƘJ�͂𒍂�����ŁA���v�w��R���s���[�^�̐��ƁE�o���҂��������`�[���Œ����A�W�v���s���A�W�v���ʂ���̂Ƃ��������܂Ƃ߂���B�قƂ�ǂ̒����͂�����������ŁA�������A�W�{�덷�̕]���͑����s���Ă��Ă��A�����̃v���Z�X���̂��甭�������W�{�덷�̊Ǘ��͂قƂ�Ljӎ�����Ă��Ȃ��B���v���͂Ƃ͖�����ŁA�قƂ�nj덷��ǂ�ł����悤�Ȃ��̂ł���B

�@�Ƃ��낪�A�����ɂ����ẮA���͂ⓝ�v�I�ȏW�v�����́A�����v���Z�X�S�̂̐܂�Ԃ��u�_�v�ɂ����߂��Ȃ��B�W�v�������̂́A��l�ŁA�����Z���Ԃ̂����ɍs�����Ƃ��o����B�W�v�̓S�[���Ȃ̂ł͂Ȃ��A������Ƃ������ጤ�����s�����߂̒T��j�Ƃ��Ă̖������ʂ������ƂɂȂ�B�������A�R���s���[�^�E�e�N�m���W�[�̐i���́A�S���������\�ɂ��A�x���ꑁ����o�c�w����Łu�W�{�����v�u�W�{�덷�v�Ƃ��������t������ɂ��邾�낤�B�����ł́A��W�{�덷�̊Ǘ�����������ƍs����ׂ��Ȃ̂ł���B

�@���v�����Ƃ͎����ɓ������邽�߂̎�@�ɂق��Ȃ�Ȃ��B���͂��͂�W�v�\�Ŗ��������ɖ��߂���悤�Ȃ��Ƃ͂Ȃ��A���v�����̑O��A���Ɍ�ɍs��ꂽ�q�A�����O�����⎖�ጤ���ɂ���ē���ꂽ�m���Ɉ��Ă���B���������v������1�����̂��̂ł͂Ȃ��A���N�J��Ԃ��J��Ԃ��s����ׂ����i�̂��̂ł���B�����̌���͕K���ǎ����s����ׂ��ł��邵�A���N������V�N�Ȏ��������́A���X�ƐV�������_�≼����A���I�ɐ��ݏo���Ă����B�����ɂ́A�����Ƙ_���̗��ݍ����̒��ŁA�����E���͂����鑤�̃I���W�i���e�B�[����ɋ��߂��Ă���̂ł���B�M�����̍������ጤ�������悤�Ƃ���Ȃ�A���܂ⓝ�v�����͋��͂Ȏ�@�Ȃ̂ł���B

�@���̂��Ƃ͓����ɁA�g�D�J���A���{�I�ɂ����A�g�D�������̐V�����n�����J�����̂ł���B�g�D�̍ĊJ���̂��߂ɂ́A���邢�͐^�̖��_��I�m�ɔc���E�w�E���邽�߂ɂ́A�Г��I�ɂ����v�����̗��t�����K�v�ɂȂ�B�Г��ł̐��|�_��r����ɂ��A��͂蓝�v�����̖��炩�ɂ��鎖�����K�v�Ȃ̂ł���B���̈Ӗ�������A�{���Œ����̎���Ƃ��Ď��グ���u�g�D�������̂��߂̏]�ƈ��ӎ������v�̃m�E�n�E�́u���v�I�g�D�������v�̉\���������Ƃ����Ӗ��ŁA��Ƃ̒S���҂ɂƂ��ėL�v�Ȃ��̂ƂȂ낤�B����́A��w�̌����҂��o�c�g�D�̓��v�������s���ۂɂ��A�K����q���g�ɂȂ�͂��ł���B

�@�{���́A��w�̊w���y�ё�w�@�ɂ�����u�`�m�[�g�����Ƃɂ��č쐬����Ă���B���̍u�`�m�[�g�́A���Ƃ��Ƃ�1988�N�x�Ɋw�K�@��w��w�@�o�c�w�����Ȃɂ����Ĕ��u�t�Ƃ��āu���v�����_�v��S���������Ƃ����������ƂȂ��ď����n�߂�ꂽ���̂ł���B�����ɁA�����������Ă������k��w�o�ϊw���o�c�w�ȂŁA�u�o�c�w�v�[�~�i�[���̊w���w���Ώۂ̑��Ƙ_���w���ɂ�3�N�قǎ�������Ȃ���g�����B���̌�A1991�N�x����A���̏�����������w���{�w���Љ�Ȋw�Ȃɕς���āA�u���v�w�v�u�Љ���@�v��S�����邱�ƂɂȂ����̂ŁA���̍u�`�m�[�g�̉���������ɑ�����ꂽ�̂ł���B���̊ԁA(��)���{���Y���{���̌o�c�A�J�f�~�[�ŁA��Ƃ̎����S���ґ���ɍu�`����ۂɂ��A���̍u�`�m�[�g�̈ꕔ���g�p����Ă����B

�@�{���́A���̐��藧�����炵�āA���ɑ����̕��X�̌�w���A�䏕�͂Ɏx�����Ă���B�܂����̏������铌����w���{�w���Љ�Ȋw�ȓ��v�w�����̑�X�̐搶������͗l�X�Ȍ`�ł����b�ɂȂ����B���ɁA��w�@���ォ���w�������������A�{���̎��M�����߂Ă��������������]�搶�ƁA���莞�ォ���w�������������Ă���ю���搶(���݁A�����w�@��w����)�ɂ́A���̏�����肵�ĐS������\���グ�����B���搶�Ƃ̏o����Ȃ���A�������̂悤�ȃe�L�X�g�����M���邱�Ƃ͂��肦�Ȃ������ł��낤�B

�@�܂��{���̂��ƂɂȂ����u�`�m�[�g���쐬���邫������������Ă����������A�����̊w�K�@��w�����A���݂͒}�g��w�����͍̉����F�搶�B�{���̒��Œ����̎���Ƃ��Ď��グ�Ă���u�g�D�������̂��߂̏]�ƈ��ӎ������v�̎��{�ɁA1986�N�ȗ��A���N�e�g�ɂȂ��ċ��͂��Ă���������(��)���{���Y���{���̐V���v���BSAS�Ɋւ���ŐV�������������Ă�����������SAS�C���X�e�B�e���[�g�W���p���̒|�����b����B�����āA�Y��Ă͂Ȃ�Ȃ��̂́A���k��w�ݐE���ɁA����SAS���[�U�[�Ƃ��ēƂ藧������̂𑽕��ʂ���T�|�[�g���Ă��ꂽ���k��w�������Z���^�[�̃X�^�b�t�̕��X�B�{���̎��M���I�n�g������܂��Ă���������������w�o�ʼn�̏��r�����F���B�����̕��X�ɂ́A���̏�Ŋ��ӂ̈ӂ�\�����Ă������������B

1992�N9��

�����L�v

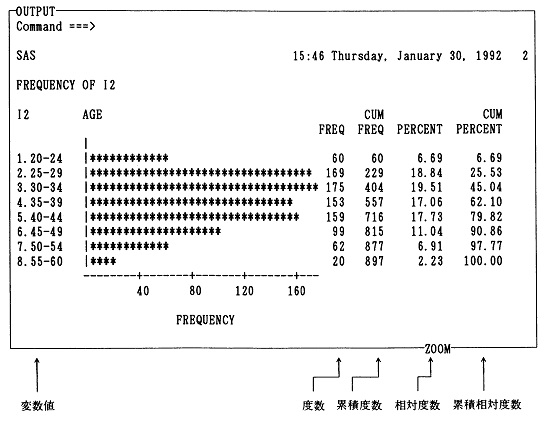

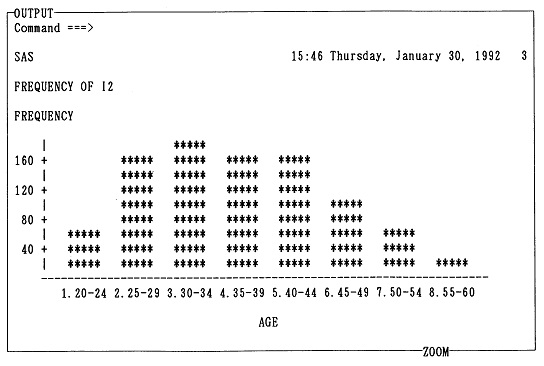

�@�{���ł́A���v�p�b�P�[�W�Ƃ���SAS(�T�X�Ɠǂ�)�����グ�Ă���BSAS�͂��܂��\�I�ȓ��v�p�b�P�[�W�ł���A�����̑�w�A��Ƃ̑�^�ėp�v�Z�@(��������C���t���[��(mainframe)�ƌĂ�)�Ɋ��ɓ�������Ă���B�܂��p�[�\�i���E�R���s���[�^�p�͂��Ƃ��Ɨ����ŁA���[�v���E�\�t�g���̗����ݒ�i�����������^���j�ł����ɁA�T�C�g�_������Ԃ��ƂŁA1�䓖��̒P�ʉ��i��啝�Ɉ��������邱�Ƃ��ł���B���������āA�{���̑z�肷��ǎ҂ɂƂ��ẮASAS���g�p����@��͏\���ɂ���Ɣ��f�����B

�@SAS�Ƃ́A���Ƃ���Statistical Analysis System (���v���̓V�X�e��)�̗��̂��������A���݂ł́A�f�[�^�Ǘ��@�\���̏d�v���������ASAS�������Ȗ��̂ƂȂ��Ă���B���̌��`�́A1966�N�ɕč��m�[�X�E�J�����C�i(North Carolina)�B����w�ŊJ�����J�n����A1976�N�ɂ́ASAS Institute Inc.���ݗ�����A�Ȍ�ASAS�̈ێ��A�J���A�̔��A���瓙���s���悤�ɂȂ����B�ȒP�Ɍ����ASAS�Ƃ̓f�[�^�E�Z�b�g�ƌĂ��t�@�C���ɑ��āA���v�����E���Z�������͂��߂Ƃ���e��̉��H�������s���p�b�P�[�W�E�v���O�����ł���B�e��̓��v�����p�Ƀv���O���������ꂼ��FORTRAN��BASIC�Ȃǂ̌�����g���Ď����ō쐬�A�J���A�ێ����邱�Ƃ́A��ʂɂ͔��ɑ�ςȍ�Ƃł���B���̓_SAS�́A���Ɋ�������Ă��铝�v�p�v���O�����̏W���́A�V�X�e���ł���A���p�҂��K�v�ȃv���O�������w�肷��ƁA�������@�\�I�Ɍ��ѕt���āA���v���������Ă����킯�ł���B

�@SAS�͂��Ƃ���IBM�̃��C���t���[����œ������v���͗p�\�t�g�E�F�A�Ƃ��Ēa�����A���̌�����C���t���[���p�ɐi���𐋂��Ă������A�ŐV�łł����6��(�����[�X6)�ł́A���C���t���[���p�����p�[�\�i���E�R���s���[�^�p�̕��������o����Ă���B�{���ł́A���̍ŐV�ŁASAS��6�ł̎g�����ƃv���O���~���O�ɂ��āA�p�[�\�i���E�R���s���[�^��SAS�A������PC��SAS�𒆐S�ɁAIBM���C���t���[���̑�\�I�I�y���[�e�B���O�E�V�X�e��(operating system ������ OS) CMS�ɑΉ�����CMS��SAS�ɂ��Ă��A����_�Ȃǂɂ����y���Ȃ��畹���Đ������Ă����BPC��SAS��CMS��SAS�̗����𗼓������I�Ɏ��グ��͖̂{�������߂Ă��Ǝv���B����́A�ŐV�łł���SAS��6�łł́A���C���t���[���p���p�[�\�i���E�R���s���[�^�p���Ƃ���C����ŏ�����A�g�p���@�͊�{�I�ɓ����ł���Ƃ������Ƃɉ����āA���㎄���܂߂đ����̐l�X���A�f�[�^�E�T�C�Y��R�X�g�A���p�\���ȂǗl�X�ȗv�������Ă��āASAS�̃v���b�g�t�H�[���Ƃ��Ẵp�[�\�i���E�R���s���[�^�ƃ��C���t���[�����g�������Ă������ƂɂȂ�ƍl��������ł���B�܂����݂ł��ꕔ���C���t���[���Ŏg�p����Ă���CMS��SAS�����[�X5.18�ɂ��ẮA��{�I�g�p���@���T�����Ă������B

�@���Ȃ݂ɁA���͂��Ƃ���IBM�̃��C���t���[���ł�CMS��SAS���[�U�[�ł��邪�A�{���������ɓ����āA�����Ƃ����オ��ȃV�X�e���\���F

�@�������AMS-DOS�����[�X5.00��EMS��UMB���g���Ă��A�܂����������\���Ɋm�ۂł��Ȃ��B�����ŁA���{��t�����g�E�G���h�E�v���Z�b�T�[(FEP)��DOSSHELL�AMOUSE���A�������ɏ풓���Ă��̕���������H���Ă��܂����̂ɂ��ẮAAUTOEXEC.BAT��CONFIG.SYS�̃t�@�C�����炠�炩���ߍ폜���Ďg�p���Ă���BMS-DOS��SAS�����Ƃ��́A���̃������e�ʂ��ő�̐�������̂悤���B

�@�܂�SAS�̃V�X�e���́ABASE SAS��7.8MB�ASAS/STAT��6.3MB�ƍ��v�����14.1MB���̃f�B�X�N���g��(�p�[�\�i���E�R���s���[�^�p��SAS�����[�X6.04�̑S�v���_�N�g�ł�38.2MB�̃f�B�X�N�e�ʂ��K�v�ɂȂ�)�BMS-DOS���̂ł��A�����Ēu����3MB�ȏ�f�B�X�N���g���B�{���Ŏg�p����SAS�v���O�����̗�ł́A164�ϐ��~907����1.2MB�̉i�vSAS�f�[�^�E�Z�b�g�ƌĂ��MS-DOS�t�@�C�����Œ�f�B�X�N�ɏ풓���邱�ƂɂȂ�̂ŁA��Ɨp�t�@�C���̂��Ƃ��l����ƁA�����̏�ł́A�Œ�f�B�X�N20MB��SAS���u���v�p�b�P�[�W�v�Ƃ��ĉғ��\�Ȃ��肬��̃T�C�Y�ł���B���ꂪ���ۂɉғ����邱�Ƃ�����m�F�ł����̂ŁA�p�[�\�i���E�R���s���[�^�p��SAS�̓������l���Ă���ǎ҂́A�n�[�h�E�F�A�I���̍ۂ̎Q�l�ɂ��Ăق����B

�@�{���̎��M�ɂ������đz�肵�Ă���ǎ҂́A���v�w��R���s���[�^���U���Ȃ��w���A�Љ�l�ł���B�����f�ނ��o�c�w���삩��I��Ă���̂ŁA���Ɍo�c�w����̊w���w���E��w�@���A���邢�͊�Ƃ̐l���E����E�\�͊J���Ȃǂ̒S���҂ɂ́A�����������Ă��炦��Ǝv���B

�@�{���́A�����Ƃ��āu���x�v�u����v�ȓ��v�w���_�̗�����ڎw�����̂ł͂Ȃ��B���v�w�A�����A�f�[�^��͂̍l�����A���g�ݎp����̓����邱�Ƃ�ڎw���B���v�w�A�R���s���[�^�̒m���͑O��ɂ����A�����̊�b�ɂ��Ă͓I���i���āA���J�ɐ�������B

�@�{���̖ړI�́A�ǎ҂����璲���f�[�^���W�߁A���瓝�v�w��R���s���[�^�A���v�p�b�P�[�W����g���āA�����f�[�^�͂ł���悤�ɂ��邱�Ƃł���B�ŏI�I�ɂ́A���Ƙ_���E�C�m�_�����x���̘_���A���̍쐬�Ɂu�g����v���v�w�A���v�����@��ڎw���Ă���A���ɁA�Q����ǂ̍����A�R���s���[�^���g���������f�[�^�̓��v�����ɏd�_���u����Ă���B

�@�{���͎��Ȃ�̐V�������v�w����̃R���Z�v�g�Ɋ�Â��ď�����Ă���B��w�Ŏ��Ƃ̃e�L�X�g�Ƃ��Ďg�p����Ƃ��ɂ́A���̂悤�Ȏg�������ł���B

�@�{���͑S�̂Ƃ��Ē��������v���Z�X���\������悤�ɏ�����Ă��邪�B���̈���Ŋe�͂͋��ނƂ��Ă��Ȃ�Ɨ������������Ă���B�e�͂���Ⓑ�߂Ȃ̂͂��̂��߂ŁASAS�̕����������A�K������1���S����ǂ܂Ȃ��Ă��A�K�v�ȕ����������d�_�I�Ɏg�p���邱�Ƃ��ł���B�Ⴆ�A�{������ƂȂǂł��Z���Ԃ̌��C�p�e�L�X�g�Ƃ��Ďg�p����ꍇ�ɂ́A�u���v�E�����T�_�v�Ȃ����1�������J�ɋ�����悢�B�����̕��͌��ʂɐڂ���l�ɑ��ẮA���ϒl�̗��p�Ɋւ��Ă���3�������������Ă��悢�B���ւ𒆐S����4�������A���邢�̓N���X�\�̓ǂݕ��Ɋւ�����5�������������Ă��悢�BSAS�u�K��ł���A��2�����������ނɎg�����Ƃ��ł���B

�@�{���ɂ́A���ۂ̓��v�������܂邲�ƌf�ڂ���Ă���B��6���͂��Ƃ��Ɠ��v�����}�j���A�����Ӑ}���ď�����Ă���̂ŁA�菇�ɂ��������āA�����Ȃ�̊��Œ������s�����Ƃ��ł���B

�@���v�w�́A���Ƃ��Ƒ����̕��삩��̏����Ȏx�����A�ߋ�2���I�ȏ���������č������A��̑�������ɂȂ����w��ł���B���݂̓��v�w�̗���̒��ɂ́A���R�Ȋw�ɑ����闬����Љ�Ȋw�ɑ����闬������邪�A�l�Ԃ̐����̂�����ʂƂ�����Ȋw�����v�w�Ɗւ���Ă����Ƃ����Ă��������낤�B����������A���ۂ̖@�����ɑ���l�Ԃ̂����Ȃ��T���S�����v�w�ݏo���Ă����̂ł���A���v�w�͉Ȋw�̕��@(the grammar of science)�ł���ƌĂ��R���ł�����B

�@�u���v�w�v�Ƃ����p�ꎩ�̂́A17���I�̃h�C�c�̍����w�ɑk��Ƃ�����B�����w�Ƃ́A���ƌ��������̑��̂̋L�q�Ɋւ���w��ł���A����L�q�w�Ƃł��ĂԂׂ����̂ł������B�����A���v�w���w��Statistik (�p��ł�statistics)�́A����Staat (�p��ł�state)�̏���j�I�ɋL�q���邱�Ƃ��Ӗ����Ă���Ƃ�����B�p���statistics�ɂ́A���̂悤�ɁA�W�c��������o���ꂽ���ʓI���Ƃ��Ă̓��v�������w�����v�������́u���v�f�[�^�v�̈Ӗ��ƁA������A���v�f�[�^�������A���͂��āA�W�c�ɂ��Ă̗L�Ӌ`�ȏ��邱�Ƃ���v�ȉۑ�Ƃ���w��ł���u���v�w�v�̓�̈Ӗ�������B��̈قȂ�T�O�ɓ����P��"statistics"���p�����Ă���̂͂��������w���j�I����ɂ����̂ł���B

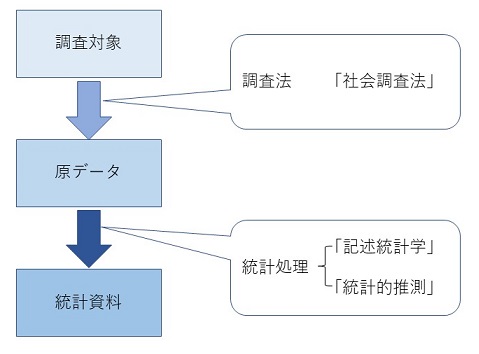

�@���v�w�Ƃ͉Ȋw����S�̌����ł���A�Љ�Ȋw�̕���ɂ����ẮA�Љ�A�o�ρA�o�c���ۂ��܂߂āA�����̌��ۂ��ǂ�Ȃӂ���(how)�ɂȂ��Ă��邩�ׂ�w��ł���B���̃v���Z�X�͂܂�����(survey)����n�܂�B���̏͂ł́A���v�w����ђ����̍l�������T�ς��A����ɂ��ƂÂ��ăf�[�^�̎��W���@��ړx�A�����Ē����ɂƂ��Ȃ��덷�ɂ��čl���Ă݂邱�Ƃɂ��悤�B

�@��������ђ������ʂւ̐ڂ����Ɋւ��ẮA���������ӂ�v����_������̂ŁA���̂��Ƃ���b���n�߂邱�Ƃɂ��悤�B

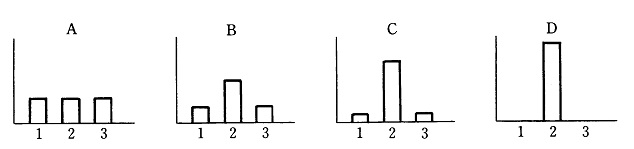

�@�܂��ŏ��ɁA�������ʂ͎��Ԃ��̂��̂�\���Ă���̂ł͂Ȃ��Ƃ������Ƃɂ͒��ӂ���K�v������B�����ɂ����ẮA�Ɋe�҂̐^�̈ӌ����\����Ă��邩�ǂ����͂킩��Ȃ����A����̎d���ɂ���Ă͂��܂��܂ȓ��v�������o�Ă��邱�ƂɂȂ�B�܂�A�������ʂ͂��̂܂܂ʼn��炩�̎��Ԃ�\�������̂ł͂Ȃ��B�������A�������ʂ́u���鎿��ɑ��āA����l���炠����Ԃ��Ă���v�Ƃ����A�܂��Ɂu�����v�̏W�c�I�Ȑςݏd�˂ł���B���v�I�ȏ������{���ꂽ�������ʂ́A�W�c�����邽�߂̈�̎w�W(index)�Ȃ̂ł���B

�@���̎w�W�����Ԃ��̂��̂Ǝ��̂͌��ł���B���̎���(���w�W)�������Ӗ����邩�́A�ΏۂƂȂ��Ă���Љ�邢�͊�Ƃ̓����Ɠ˂����킹�邱�Ƃɂ���Ă͂��߂Ă킩���Ă�����̂ł���B�Ⴆ�A���}�x�����͑I���̍ۂ̐��}�̓��[���Ƃ͈�v���Ȃ����A���}�x�����̐��ڂ͐�����̍s�������邽�߂̈�̎w�W�ƂȂ��Ă���B�����āA���}�x�����̐��ڂ𑼂̗l�X�ȗv���Ƒg�ݍ��킹�čl���邱�ƂŁA���}�̓��[����肤�d�v�Ȏ肪����ɂ��Ȃ�̂ł���B�܂�A���v�������ꂽ�������ʂ͈�̎����ł���A���̎����������Ԃ�T��肪����Ȃ̂ł���B

�@���ɁA�������邢�͓��v�ł͈��ʊW�͕�����Ȃ��Ƃ������Ƃɂ����ӂ���K�v������B����2�ϐ�x��y�Ƃ̊ԂɈ��ʊW�����݂���Ƃ������Ƃ������邽�߂ɂ́A����3�̏�������������Ă���K�v������B

�@����3�̏����������Ƃ͉\�ł��낤���B���̂����ꌩ�������2�͎��͒B���\�ł���B1�����̒����ł����Ă����╶���H�v���邱�ƂŁA�Ⴆ�A�ϐ�x�ɂ��Ă͌����_�ł̒l�A�ϐ�y�ɂ��Ă�1�����O�̒l���v���o���ĉ��Ă��炤�Ƃ����悤�ɂ���A�ϐ��ԂɎ��ԓI�������ۂ����Ƃ͂ł���B�ϐ����̂̎��ԓI�����ƁA�f�[�^���W�ɍۂ��Ă̎��ԓI�����Ƃ͕ʂ��̂Ȃ̂ł���B���́A1��3�ŁA���̈��ʕϐ��̉e������������ɂ�x��y�Ƃ̊Ԃɑ��ւ����݂��邱�Ƃ������Ȃ��Ă͂Ȃ�Ȃ�(���ւɂ��Ă���4���Ō�q)�B�������A���ݓI�ɂ́A���̂悤�ȕϐ��͖����ɑ��݂��Ă���̂ł����āA�ǂ̕ϐ������f���ɓ���邩�̑I���͗��_�I�l�@�ɂ������Ă���̂ł���B���������āA����1��3��2�����������Ƃ͖{���I�ɕs�\�ł���B2�ϐ�x��y�Ƃ̊ԂɈ��ʊW�����݂��邱�Ƃv�I�ɗ����邱�Ƃ͂ł��Ȃ��B

�@�l���Ă݂�A�����[���쐬����i�K�ŁA�ӎ����Ă���A���Ă��Ȃ��Ɋւ�炸�A���ɕϐ��̑I�����s���Ă��܂��Ă���̂ł���A�Öق̂����ɉ��炩�̈��ʊW��O��ɂ��Ă��܂��Ă��邱�ƂɂȂ�B�����f�[�^���W�ɍۂ��āA���S�I�ȕϐ��𗎂Ƃ��Ă��܂�����A���S�I�ȊT�O��Ó������������@�ő��肵�Ă��܂����肵�Ă���A���v�I�ɂ͐��������͂����ۂɂ͌�������ʂ����Ƃɂ��Ȃ�B

�@����ɁA���ւ͕������̂Ȃ��Ώ̐��̂��鐫���ł��邩��A���Ƃ����ւ�����Ƃ킩���Ă��A���͎҂����炩�̗��_�Ɋ�Â����A�������͎����̓��ōl���邩���ď�ݒ肵�Ȃ�����A�ϐ��Ԃ̈��ʂ̕��������߂邱�Ƃ͂ł��Ȃ�(�Ⴆ����5�͑�6�����Q�Ƃ̂���)�B���̈Ӗ��ł́A�ǂ�ȓ��v�I���@�����ɂ̈��ʊW���������Ƃ͂ł��Ȃ����A�����������ʊW�����݂��邱�Ƃ��������Ă͂���Ȃ��̂ł���B���ǁA�������邢�͓��v�ł͈��ʊW�͂킩��Ȃ��B

�@����ł́A�����͂ǂ��������ړI�ōs����̂ł��낤���B�܂���������̂��A���O�̒m���̐��x�����コ���邱�Ƃł���B���̑�\�́A�ʏ�̌����_���Ȃǂɂ݂���悤�ɗ��_�Ɋ�Â��������̍\�z�Ƃ��̌��ł���B���������ꂾ���ɂ͌���Ȃ��B�����P�ɒ��������A���{���A���̌��ʂƂ��ē���ꂽ���v�������g���Ƃ��������ł��A����͎���̒m���A�펯�A����x��������Ă��邱�Ƃ��Ӗ����Ă���B�Ȃ��ɂ́A���ʂ̈ӊO�������҂��Ē������s���l�����邪�A��������Ē������l���邱�Ƃ́A�����̖{����������Ă���Ƃ����Ă悢���낤�B�����͉����Ƃ܂ł͂����Ȃ��Ă��A���Ƃ��Öق̂����ɂł���������ʊW�ɂ��Ă̎��O�̒m���𗘗p���Đv�������̂ł���A���O�̒m�����s�\���ł���A�q�A�����O�����╶���Ȃǂ�ʂ��āA������x�̒m���̊l�����}����ׂ��ł���B���̂悤�ɂ��āA�����̐v���O����ɍs���Ă���A�������ʂɈӊO���������邱�Ƃ͂قƂ�ǂȂ��B

�@�������ӊO�Ȓ������ʂ�������悤�Ȃ��Ƃ�����A�������@���Ɍ�肪�Ȃ��������A���邢�͎������Ƃ�ł��Ȃ��l���Ⴂ�����Ă��Ȃ����������܂��^���Ă݂�K�v������B�o���I�ɂ́A�u�ӊO�ȁv�������ʂ́u���������ȁv�����v���琶�܂�邱�Ƃ������B�u�펯���悤�Ȓ������ʁv�͊�{�I�ɂ͂��蓾�Ȃ��ƐS���āA�������邢�͒������ʂɐڂ���ׂ��ł��낤�B�ǂ������ł́A����O�̂��Ƃ�����O�Ɍ��ʂƂȂ��ďo����̂ł���A���������邱�Ƃɂ��A����܂Ŕ��R�Ƃ���炵���X��������Ɗ����Ă������Ƃ��A��萸�m�ɓ��v�����ƂȂ��Ēm�蓾��悤�ɂȂ���̂ł���B

�@�����̂�����̖ړI�́A���̎��̒����̂��߂̃q���g�A�q�����L�邱�Ƃł���B�펯���悤�Ȓ������ʂ͊�{�I�ɂ��蓾�Ȃ��ƐS���āA�O����Ȓ����v���s�����ɂ�������炸�A�ӊO�ȁA���邢�́A����܂ŋC�Â���Ă��Ȃ������V���������E�W�����邱�Ƃ�����B�����鎖�������ł���B���̎��ɂ́A������x�������s���Ă݂Ȃ��Ă͂Ȃ�Ȃ��B�܂�A�J��Ԃ��������o�傷��Ƃ����̂��A�����̖{���̎p�ł���B�����āA���̎�����W��_���I�ɂǂ̂悤�ɐ����ł��邩����ɍl���Ă����p������ł���B

�@���ɏq�ׂ��ʂ�A���v�w�Ƃ͉Ȋw����S�̌����ł���A�Љ�Ȋw�̕���ɂ����ẮA�Љ�A�o�ρA�o�c���ۂ��܂߂āA�����̌��ۂ��ǂ�Ȃӂ��ɂȂ��Ă���̂��ׂ�w��ł���B���v�����Ŏ������L�q���邱�Ƃ�ڎw���Ă͂��邪�A�_���ݏo�����Ƃ͂ł��Ȃ��B�_���͏�ɐl�Ԃ̓��̒����琶�ݏo�������̂ł���B�����āA���̘_����펯�Ƃ��Ēm���Ă��邱�Ƃ̐��x�����コ���邱�Ƃ��A���v�����̎�ړI�Ȃ̂ł���B

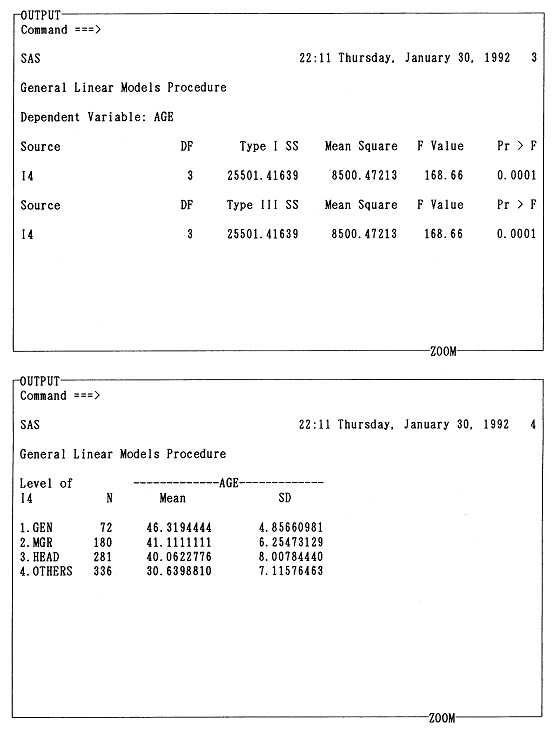

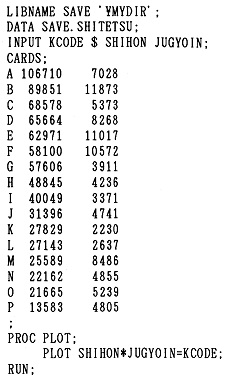

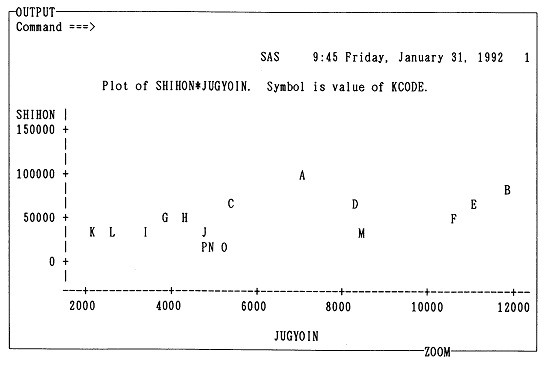

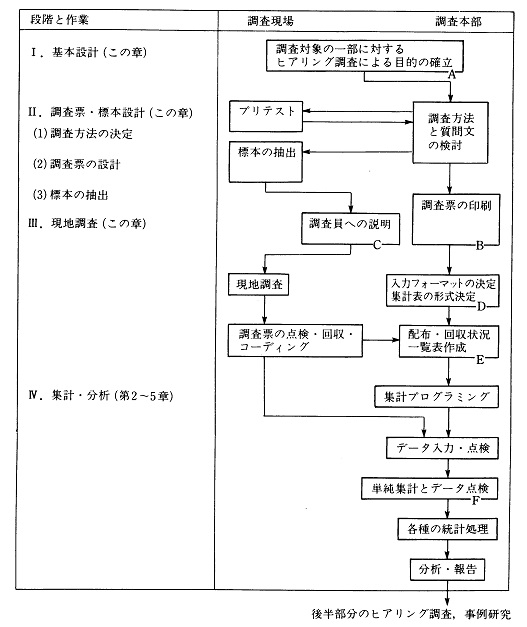

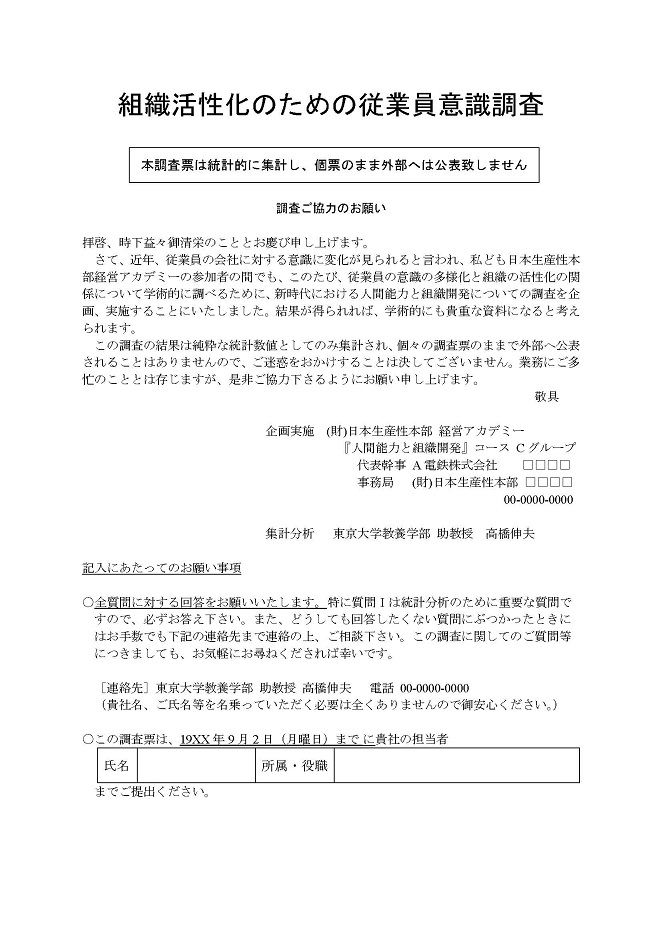

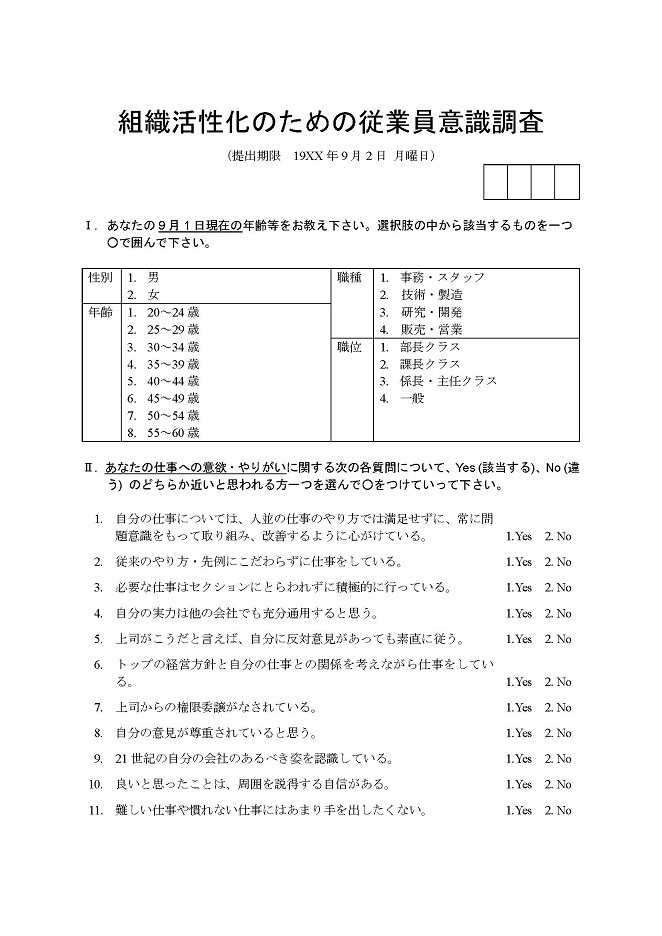

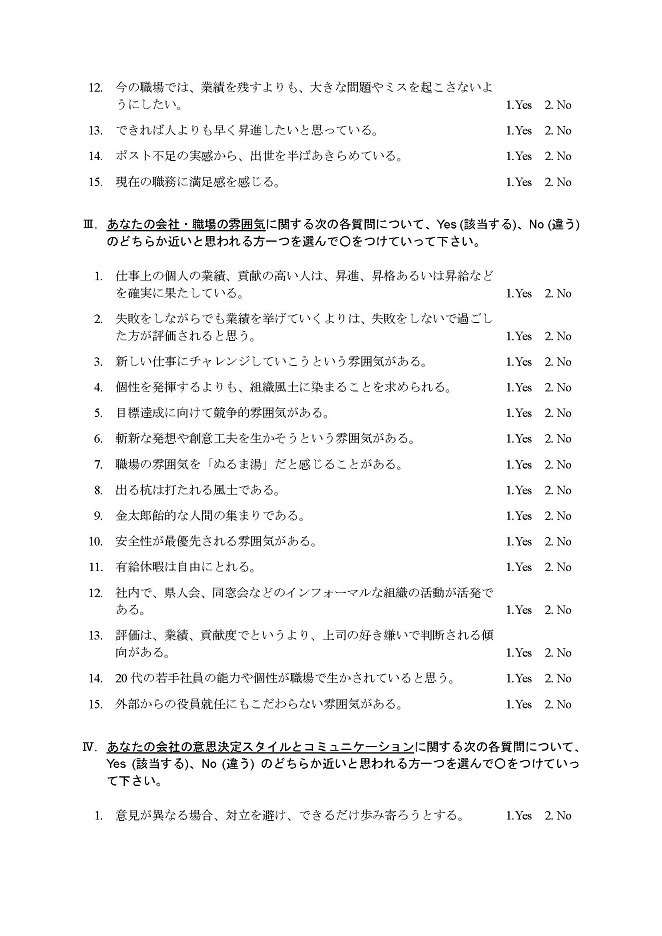

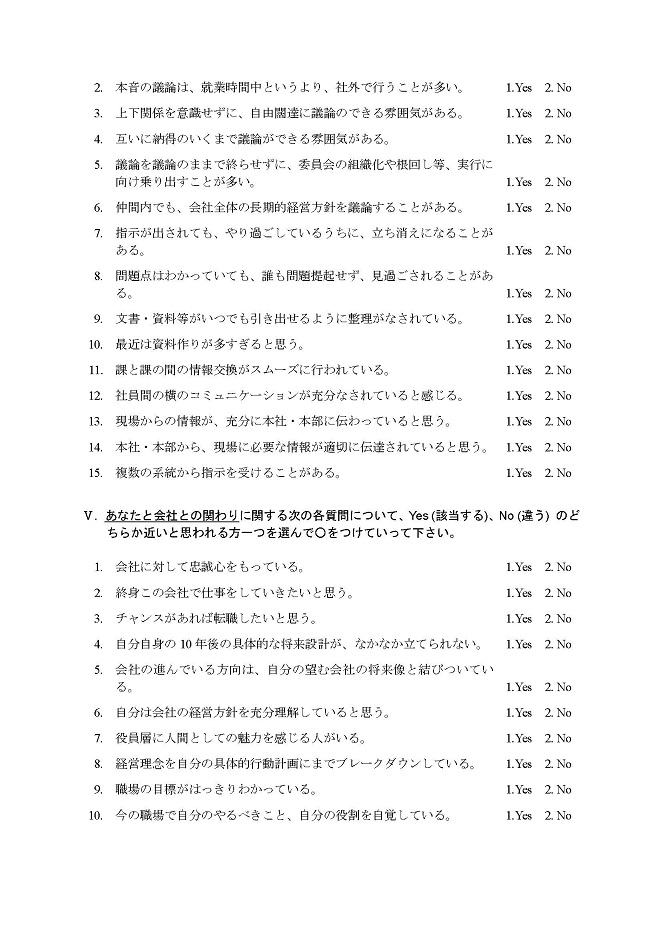

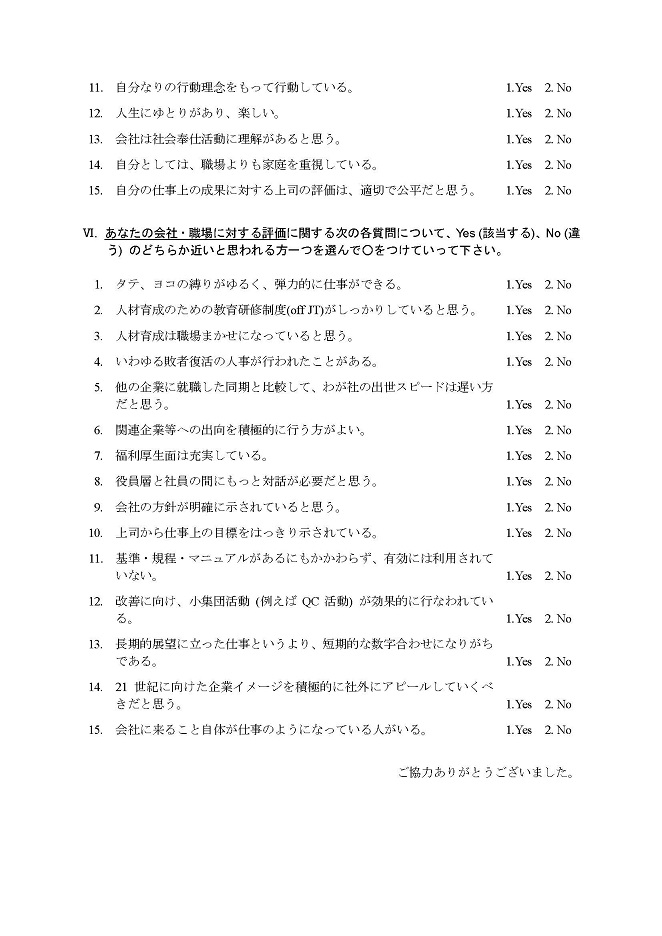

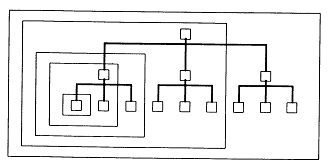

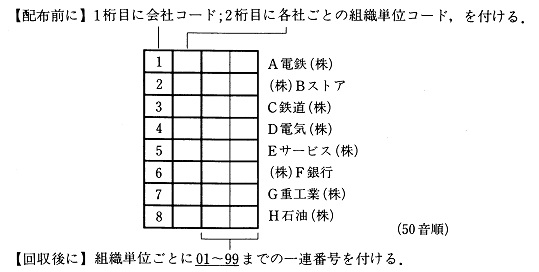

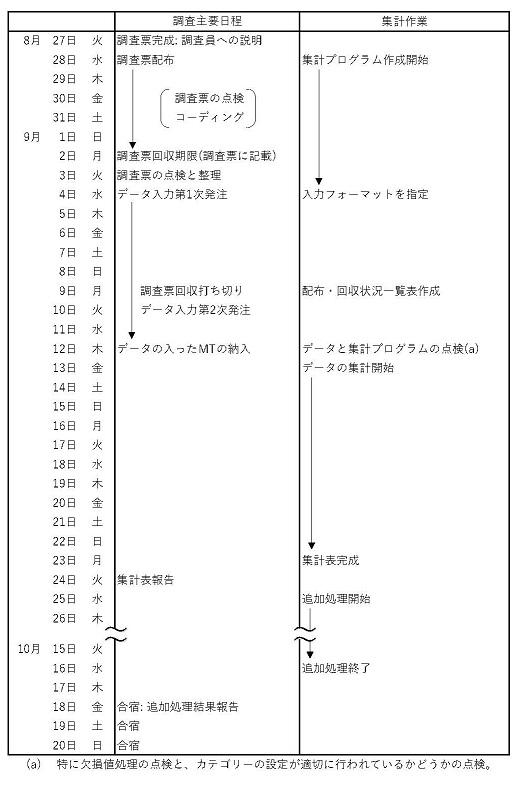

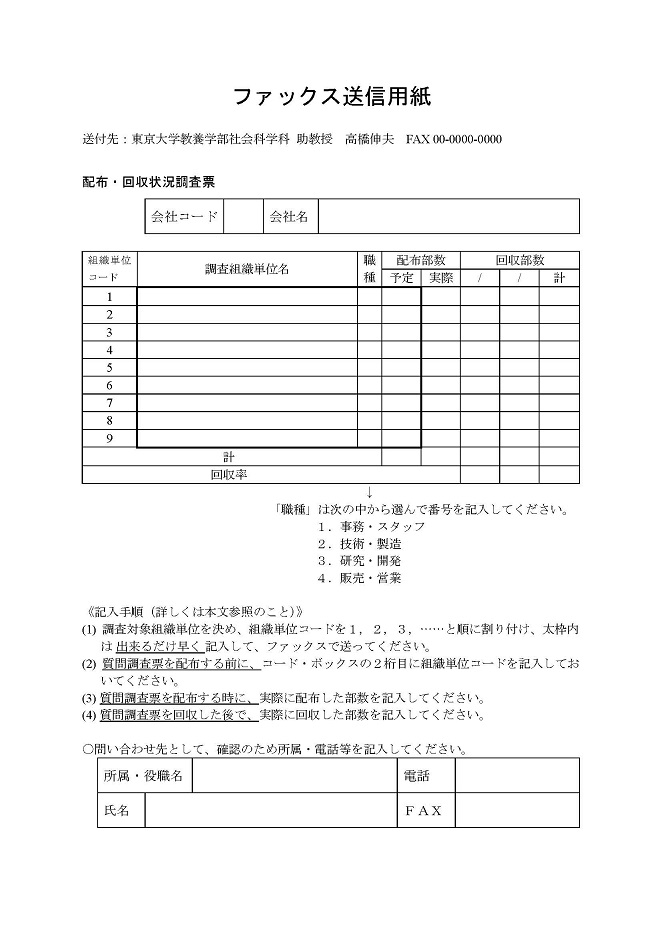

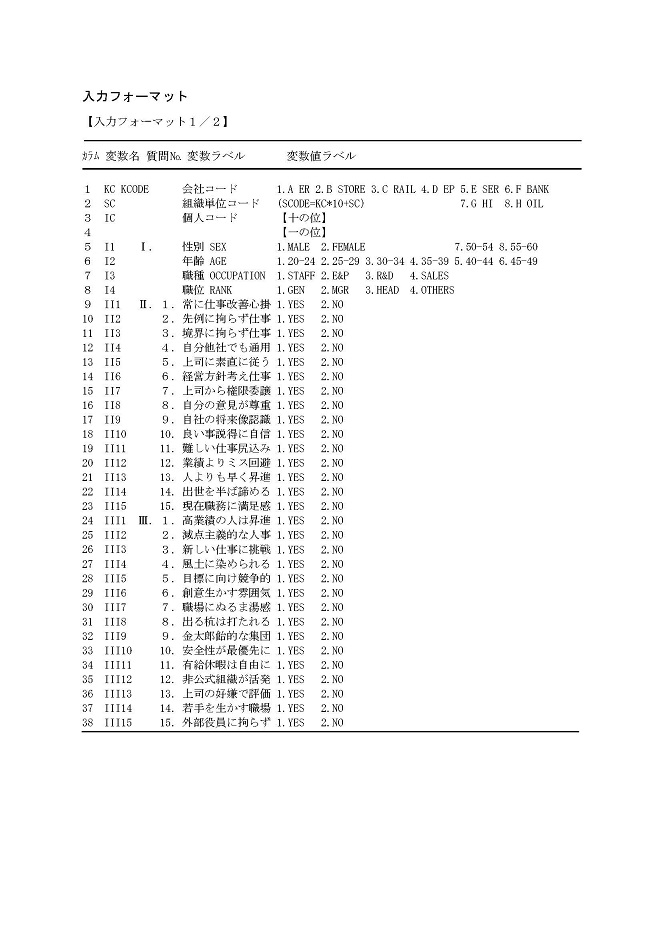

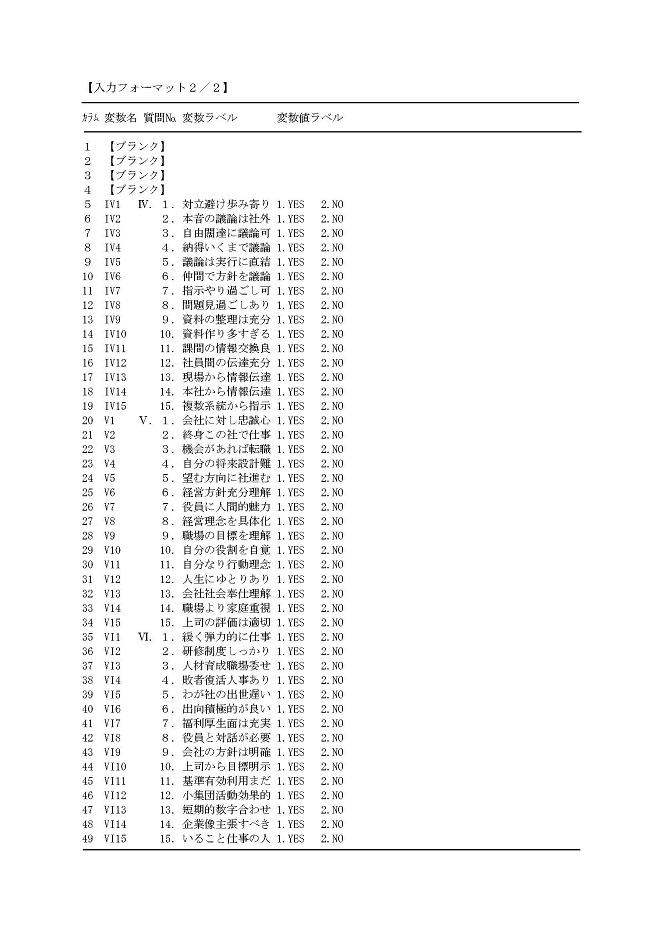

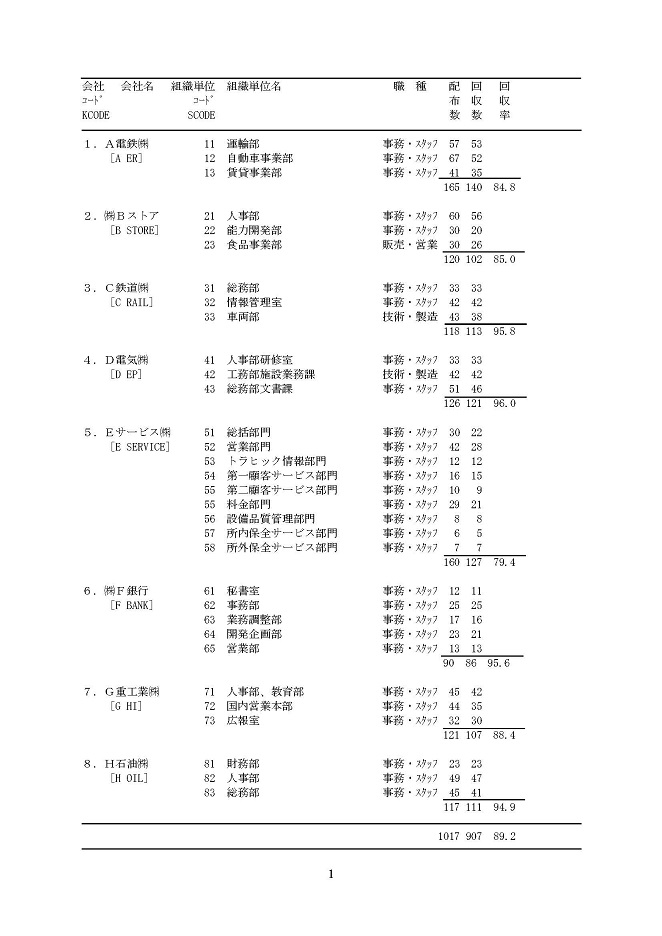

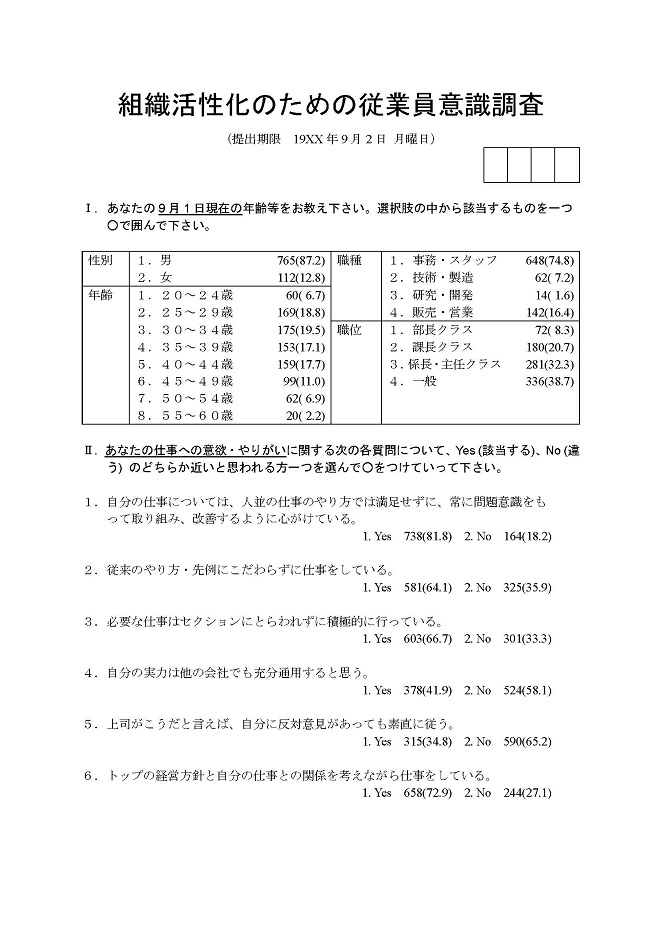

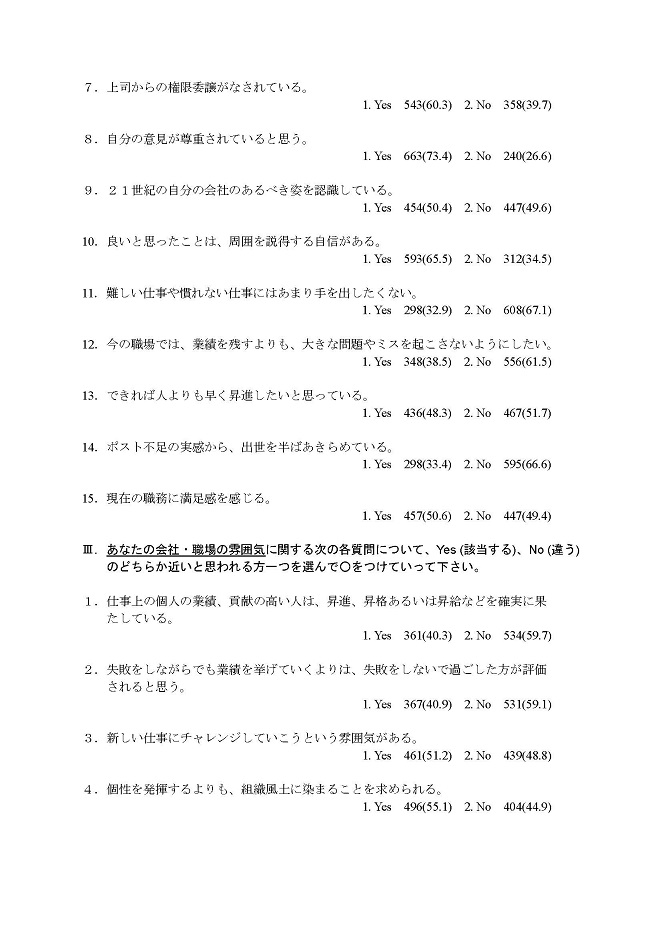

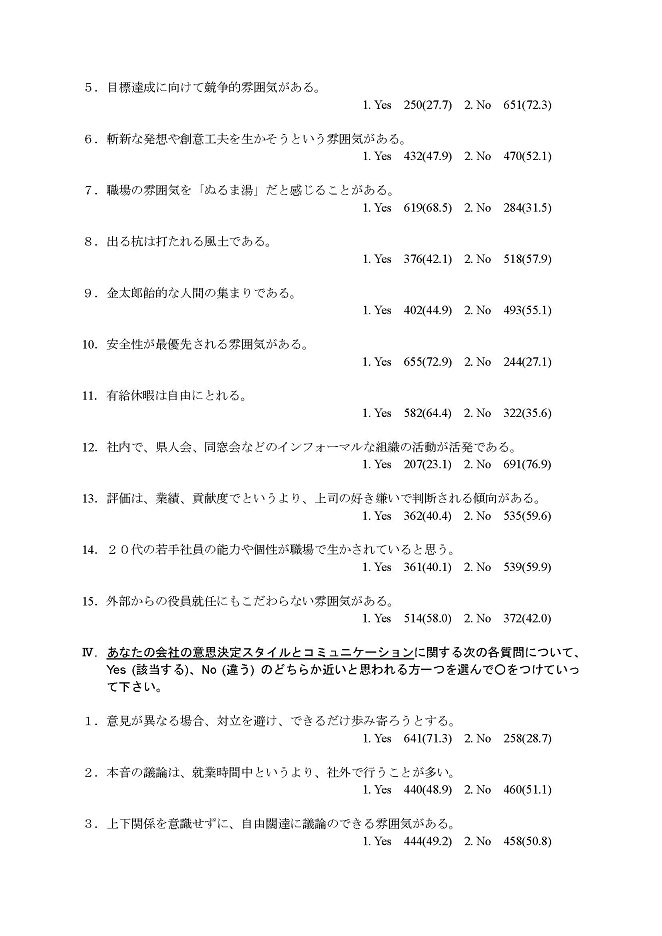

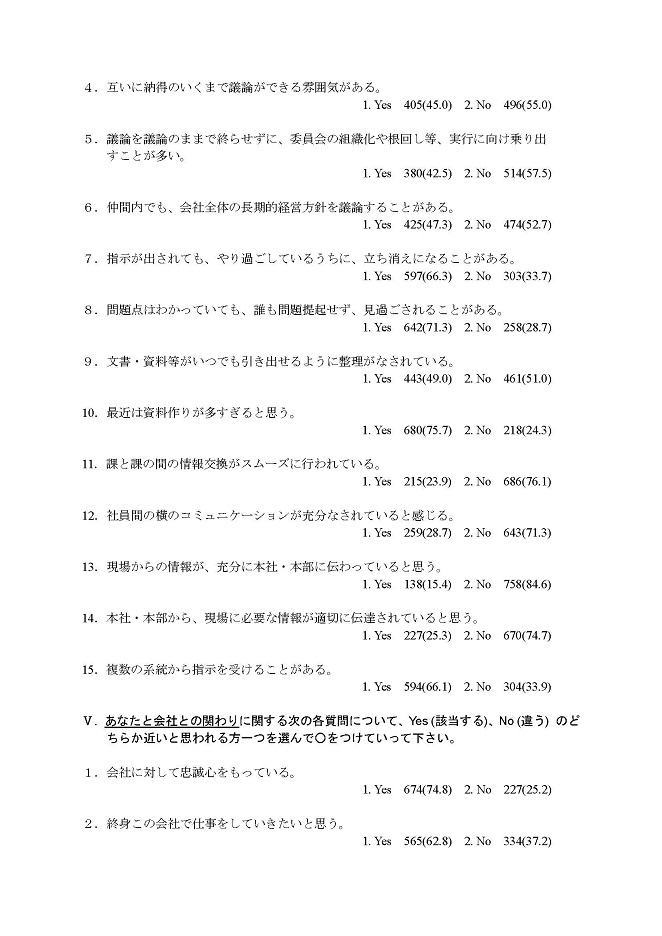

�@�{���ł́A�����������v�����̎��ۂ̎p���ł��邾����̓I�����m�ɃC���[�W���Ă��炤���߂ɁA��2���ȍ~�ɓo�ꂷ�铝�v�����A���͂ɗp����f�[�^����͂��߁ASAS�v���O�����̗�Ȃǂ��A���ׂĈ�т��āu�g�D�������̂��߂̏]�ƈ��ӎ������v��f�ނƂ��āA�ˋ�ł͂Ȃ����ۂ̂��̂�p���Ă���B���̒����̏ڍׂɊւ��ẮA��6���œ��v�����̗�Ƃ��āA���̒����菇�ƕ��@���A���ۂɗp����ꂽ�ڍׂȎ����ƂƂ��Ɏ��グ����B��6���͂��Ƃ��Ɠ��v�����}�j���A�����Ӑ}���ď�����Ă���̂ŁA�����̂���ǎ҂́A��2���ɐi�ޑO�ɓǂ�ł����ƁA���v�����̊��o�����߂邾�낤�B�u�g�D�������̂��߂̏]�ƈ��ӎ������v�́A1986�N�ȗ����N6���`���N1����8�J���������āA(��)���{���Y���{���o�c�A�J�f�~�[�u�l�Ԕ\�͂Ƒg�D�J���v�R�[�X��ɂ��āA�M�҂ɂ���ČJ��Ԃ��J��Ԃ����E���{����Ă������̂ł���B1991�N�܂łɁA�ׂ̂Ŗ�50�ЁA��5,000�l�ׂĂ����B��Q�͈ȍ~�ł́A���̂�������N�x�̒����f�[�^���f�[�^��Ƃ��Ĉ������Ƃɂ����B

�@���̒����ł́A��ƊԂł̉��f�I�Ȍ����O���[�v�����A���̃����o�[��Ƃ̊Ԃœ����ɓ���̏]�ƈ��ӎ��������s���A��ƊԁE�E��Ԃ̔�r�W�v���s���B���Ђ̎����m�b����Ȃ���A�������ʂ̊�ƊԔ�r�ɂ���āA���Ђ̕�������_��T��A���ጤ�����s���Ƃ����v���Z�X���J��Ԃ����ƂŁA�����O���[�v�𒆐S�Ƃ��đg�D�̊������Ɋւ����蔭����}��̂ł���B���́u�g�D�������̂��߂̏]�ƈ��ӎ������v�ł́A�]�ƈ��̈ӎ��������s�Ȃ����Ƃ��_�@�Ƃ��Ė�蔭���v���Z�X��i�߂Ă������ƂɂȂ��Ă���B

�@�������Ė��N�J��Ԃ��J��Ԃ��s�Ȃ��邱�̒�����ʂ��������m�E�n�E�̒~�ςŁA�o�c�g�D��ΏۂƂ������v�����͐������ꂽ���̂ɂȂ����A�q�A�����O�����Ɠ��v�I�Ȕ�r�����̌J��Ԃ��T�C�N�����A�g�D�J��(organization development)�A���邢�͓��{�I�ɂ����Αg�D������(organizational activation)�ɂ����鐔�ʓI��@�Ƃ��Ă��Ȃ�̌��ʂ������Ă��邱�Ƃ��o���I�ɖ��炩�ɂȂ��Ă����B���ɒ������ʂ̓��v������O�ɂ��Ă̎���I�ȃq�A�����O�����͂��Ȃ���ʓI�ŁA�I�m�Ɋj�S�I�Ȏ����ɂ��ĕ����o�����Ƃ��\�ɂ��Ă����B����́A���ʓI�ȃq�A�����O�����̂��߂ɓ��v���������Ă���Ƃ����Ă������قǂł���B

�@���v�I�ɏ������ꂽ���ʂ́A�����Δ팱��ƂɂƂ��Ă͈ӊO�Ȑ����ł���炵�����A�O�������O�҂Ƃ��Ċώ@���Ă��錤���҂ɂƂ��ẮA�Ȃ��ӊO�Ɗ�����̂������ɋꂵ�ނ��Ƃ��قƂ�ǂł���B��O�ғI�ɂ́A���v�����͎��O�̃q�A�����O�����̓��e��f���ɔ��f�����A�o���I�A�펯�I�ɂ����Ƃ��Ȃ��̂��肾����ł���B�����āA�����A���̌���������s���鎖��I�ȃq�A�����O�����ɂ���āA1��Ƃ̓����̐l�Ԃ��������́u�ӊO���v�̍a�͂ǂ�ǂ߂��Ă������ƂɂȂ�B���̈Ӗ��ł́A1��ƂƂ��������ĕ��I�Ȑ��E�ɂ����ʗp���Ȃ��O��A�펯���A���v�����̂������������������ɂ��āA�����ɂ���Ċ��p�𔗂��邱�ƂɂȂ�̂ł���B����͂��̏͂̒��ł��ꂩ�爵����������Ɠ����_���ł���B�u�����̏펯���悻�̏펯�v�Ƃ����������A���v�f�[�^�ɂ���Ċ��p����邱�Ƃ��Ӗ����Ă���B�����������Y��Ƃ̃����o�[�����ʂ��Ă����Ă���O��A�펯�̋q�ϓI�ȓ���Ƌᖡ�E�������g�D�������ɂƂ��Ă͏d�v�Ȃ̂ł���B

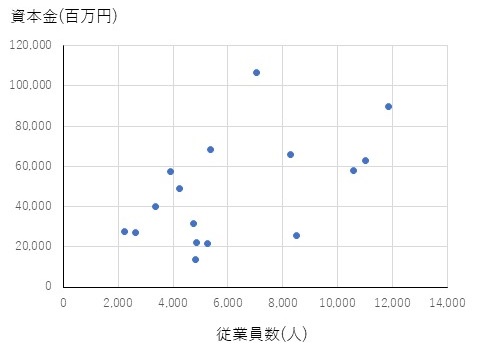

�@����ł́A���������v���Z�X�ɂ����āA���v�w���ǂ̂悤�Ȗ������ʂ����Ă���̂����A�����ΏہA���f�[�^�Ƃ̊W���l���Ȃ���A���������v���Z�X�̌o�߂ɂ��������āA�����Ώۂƒ����̎�ށA���f�[�^�Ɠ��v�����̏��ԂɌ��Ă������Ƃɂ��悤�B

�@���������v���Z�X�͂܂��ϑ�(observation)����n�܂�B����͎��R�Ȋw�ł��Љ�Ȋw�ł������ŁA���R�Ȋw�̕���ł́A����͈�ʂɎ���(experiment)�Ƃ��A����Ɋւ��铝�v���_�Ƃ��Ắu�����v��@�v������B�����A�Љ�Ȋw�̕���ł́A����͒���(survey)�Ƃ��A���̓��v���_�́u�Љ���@�v�ł���B

�@�Љ�Ȋw����ł̒����ɂ����ẮA�Ⴆ�A�l�A���сA�E��A��ЂȂǂ������̒P�ʂƂȂ�B�����āA�����̑ΏۂƂȂ肤�邷�ׂĂ̒P�ʂ��W�߂����̂̂��Ƃ��W�c(population)�Ƃ�ԁB��W�c�Ƃ́A�����Ώۂ̏W�܂�ł����āA�����ɂ���āA����ɂ��ĉ��炩�̌��_���������Ƃ��Ă�����̂ł���B

�@�����̑ΏۂƂȂ�P�ʂ̂��Ƃ͗v�f(element)�Ƃ��Ă��B��������������������A��W�c�Ƃ͂܂��ɏW���ł���A����̗v�f�����̒��Ɋ܂܂��邩�ǂ����ɂ��Ă̖��m�ȋK��(���[��)���Ȃ��Ă͂Ȃ�Ȃ��B���̃��[���ɂ́A�ʏ�́A�P�ʂ��̂��́A���ԁA�ꏊ�ȂǂɊւ���L�q���܂܂�Ă���B��W�c�͒����҂���Ɨ��ɑ��݂��Ă�����̂ł͂Ȃ��āA�����҂���̓I�����m�ɐݒ肷�ׂ����̂ł���B

�@�������@�ɂ��ẮA���v�w�̒��ł͊��ɏq�ׂ��悤�Ɂu�Љ���@�v����舵���ׂ��ۑ�ł��邪�A�����ł����܂��ɐ������Ă������B����ɒ����Ƃ����Ă��A����ɂ͂��܂��܂Ȏ�ނ�����A�����Ώۂł����W�c�̑傫�����W�c�̐��ɂ���ĈقȂ�����ނ̒������s����B�܂��ŏ��ɁA��W�c�̑傫���ɂ���Ď��̓�̒������@���I�������B

�@�S�������ƕW�{�����̂ǂ����I�����ׂ����́A��W�c�̑傫���A�����ɕK�v�ȘJ�́A�R�X�g�ɂ���Č���B�Ⴆ�A�S�������̑�\��Ƃ��ẮA��������(�l��census)������B���������́A���߂�ꂽ�N��10��1�����݂̓��{�̑S�l����Ώۂɂ��čs����S�������ł����āA1920�N(�吳9�N)�Ȍ�T�N���Ƃɒ���I�ɍs���Ă���B(�������A�푈�̉e���̂��߂ɁA1945�N(���a20�N)�̒����͎��{���ꂸ�A1947�N(���a22�N)�ɗՎ����������{���ꂽ�B) ��ʂɁA���������ɑ�\�������{�S����ΏۂƂ���S�������́A���z�̔�p�Ƒ�ʂ̐l���ƒ������Ԃ�v����B���������āA���������ȊO�ɂ́A���Ə����v�����A�_�ыƃZ���T�X�A�H�Ɠ��v�A���Ɠ��v�ȂǁA�S�������̐��͌����Ă���B���ۂɁA����ꂪ�u���{�́����ɂ��Ă̒����v�Ƃ��Ă悭���ɂ���̂́A���̂قƂ�ǂ��W�{�����ł���B�W�{�����ɂ��ẮA��ł��̏͂̒��ł��ڂ�����������B

�@�����Ƃ��A���̂悤�ɒ����Ƃ����Ώ]���͂قƂ�ǕW�{�������Ӗ����Ă����̂ł��邪�A�ߔN�̒������R���s���[�^�E�e�N�m���W�[�̐i���́A��̊�Ƃ̏]�ƈ��ׂ���x�ł́A�S���������\���\�ɂ��Ă��܂����B�p�[�\�i���E�R���s���[�^�ł���A����l�K�͂̒������قƂ�ǖ��Ȃ��W�v�A���͂ł���B���Ɍo�c����ɂ����ẮA�W�{����������ɂȂ���������炸����Ă��邾�낤�B

�@���ɁA���������W�c�̐��ƒ������_�ɂ���āA�����͕\1.1�̂悤�ɁA���f�I�����A��r�����A�p�l�������A�J��Ԃ�������4��ނɕ��ނ����B���̂�����{�ɂȂ�̂́A��̕�W�c�ɑ���1�����̒����ł��鉡�f�I�����ł���B���̒������@�́A���̉��f�I������F�X�Ƒg�ݍ��킹�����̂ł���B

�\1.1�@�������@�̎��

| �������_ | ��W�c | |

|---|---|---|

| �����W�c | ������W�c | |

| �ꎞ�_ | ���f�I���� | ��r���� |

| �������_ | �p�l������ | �J��Ԃ����� |

�@�������_���قȂ�A��W�c���K�肷�鑼�̃��[���������ł��A�����ɂ͕�W�c�̗v�f�͈قȂ�̂ŁA���̂悤�ȏꍇ���A�����ɂ͌J��Ԃ������ɂȂ�B��������ʂɁA�������_���قȂ邾���ŁA��W�c���K�肷�鑼�̃��[���������Ȃ�A���̂悤�Ȓ������瓾��ꂽ�f�[�^�́A���n��f�[�^(time-series data)�Ƃ���B���n��f�[�^�ɂ���āA���Ԃ̌o�߂ɂ��ω���َ��_�Ԃ̊W��m�邱�Ƃ��ł���B�p�l���������A�p�l�����Œ肷��ԁA��W�c�̗v�f�͕ϓ����Ȃ��Ɖ��肵�āA���n��f�[�^�邽�߂ɍs������̂ł���B

�@������ɂ���A�������ʂ╪�͌��ʂ𐳂����������邽�߂ɂ́A���̒������ǂ̂悤�ɂ��čs�Ȃ�ꂽ�ǂ�Ȏ�ނ̒����ł��邩��m��Ȃ��Ă͂Ȃ�Ȃ��B��������ƁA�������ʂ̓��v������������l�����������ł��邪�A���v�����͒������@�Ə�Ƀy�A�ŕ]�������ׂ����̂Ȃ̂ł���B(�����K���1.1)

�@�����̌��ʂ́A���f�[�^�A�������͒P�Ƀf�[�^�Ƃ��A���v�I�L�q�̑f�ނƂȂ�B�f�[�^�Ƃ́A�W�{�����Ȃ�ΕW�{�A�S�������Ȃ�Ε�W�c�ɑ�����e�v�f�Ɋւ���ϑ��l�̂܂Ƃ܂���w���Ă���B�ŋ߂̂悤�ɁA�R���s���[�^���g�����W�v�A���v���͂����S�ɂȂ��Ă���ƁA�f�[�^�̏�����̕X���l����A�ϑ��l�̓J�i��A���t�@�x�b�g�Ȃǂ̕����ł͂Ȃ��āA���l�ŕ\����Ă��邱�Ƃ��]�܂����B

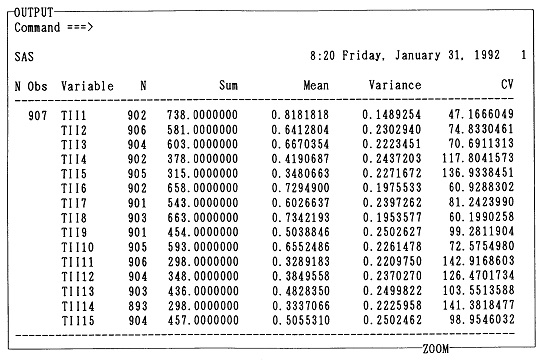

�@�Ƃ���ŁA�ϑ��l�����l�ƂȂ��Ă���A�`���I�ɂ͂����̊Ԃ̉��Z���\�ɂȂ�B�������A���ӂ��K�v�Ȃ̂́A�ϑ��l���ǂ�Ȏړx(scale)�ɂ���đ��肳�ꂽ�̂��ɂ���āA�ǂ̂悤�Ȑ����̉��Z���s�����Ƃ��ł��邩�����܂��Ă���Ƃ������Ƃł���B����̓R���s���[�^�ɔ��f�ł��邱�Ƃł͂Ȃ��āA�l�Ԃ̑��ł�����ƃR���s���[�^�Ɏw�����Ă����ׂ����Ƃł���B�悭�p������ړx�̕��ނƂ��ẮA����4������B

�@���`�ړx�A�����ړx�ɂ��ƂÂ��f�[�^�̂��Ƃ����I(�萫�I)�f�[�^(qualitative data)�Ƃ����A�Ԋu�ړx�A�䗦�ړx�ɂ��ƂÂ��f�[�^�̂��Ƃ�ʓI(��ʓI)�f�[�^(quantitative data)�Ƃ����B��̃��X�g��1����4�ւƂȂ�ɂ��������āA�ړx�Ƃ��Ă͏�ʂɂȂ��Ă����B�܂�A��ʂ̎ړx�ɂ��ƂÂ��ϑ��l�ɂ́A���ʂ̎ړx�ɂ��ƂÂ��ϑ��l�̈Ӗ��A����т���ɉ\�ȉ��Z����܂���Ă���B�ϑ��l�̉��Z�\���́A

�����������Z�\���ɂ��Ă͏\���ɒ��ӂ�˂Ȃ�Ȃ��B

�@�����ɂ���ē���ꂽ���f�[�^�ɑ��ē��v�������{�������̂����v�����ł���B����́A�悭�������ʂƂ�����B���̂Ƃ��A�^����ꂽ���f�[�^�ׁA���̋K�������瓝�v�I�@��������L�q���v�w(descriptive statistics)�����邱�ƂɂȂ�B�܂�A�}�\�ɂ���ăf�[�^�����A���ρA���U�Ȃǂ̓����l�ɂ���ăf�[�^��v��Ƃ����悤�ɁA�f�[�^���E�v�āA��W�c��W�{�̏W�c�Ƃ��Ă̓������L�q����̂ł���B�������A�f�[�^�𐔒l�I�ɗv��ꍇ�ɂ́A(2)�ŏq�ׂ��悤�ɁA�f�[�^�����肳�ꂽ�ړx�����ɂȂ�B�f�[�^�̉��Z�\���ɂ��ẮA�f�[�^�������n�߂�O�ɁA�K���l���Ă����K�v������B

�@�Ƃ���ŁA���v�w�̖����̓f�[�^�̐����E�v���ł͂Ȃ��B�S�������̂悤�ɁA��W�c���\�����邷�ׂĂ̗v�f�ׂ钲���̏ꍇ�ɂ́A�L�q���v�w�����ŏ\���ł���A����ɂ���ē����錋�ʂɁA����ȏ�Ȃɂ��t��������ׂ����Ƃ͂Ȃ��B�Ƃ��낪�A���p�ɂɍs����W�{�����̂悤�ɁA��W�c����K���ȕW�{�𒊏o���āA���̕W�{�ɂ��ē���ꂽ�m���ɂ��ƂÂ��āA��W�c�ɂ��Ă̐��_���s���ꍇ�A�Ȃ��S���ׂ��ɂ��̈ꕔ�̕W�{�����邾���ŁA��W�c�S�̂ɂ��Ă̐��_���\�ɂȂ�̂��Ƃ����^�₪�킢�Ă���B�����Ő������v�w���d�v�Ȗ������ʂ������ƂɂȂ�B

�@���́A��W�c�̕����ł���W�{���A����ג��o�ɂ���đI��Ă���A�m���Ƃ����_�����u��ʂ��āA��������S�̂�m�邱�Ƃ͉\�Ȃ̂ł���B���̂Ƃ��A��W�c�S�̂ł͂Ȃ��āA���̈ꕔ���ώ@���āA���̌��ʂɂ��ƂÂ��āA�S�̖̂@�����̔������邱�Ƃv�I����(statistical inference)�Ƃ�ԁB���v�I�����ɂ́A��������(hypothesis testing)�Ɛ���(estimation)�Ƃ�����̒�������B�������A�W�{�������瓱���o���ꂽ���_�́A��������W�{�𒊏o������W�c�ɂ��Ă̂ݑÓ����邱�ƂɂȂ�B�����āA�m���_����ѓ��v�w���_�ɂ���āA�W�{���o�ɂƂ��Ȃ��덷���q�ϓI�ɕ]�����邱�Ƃ��\�ɂȂ�̂ł���B

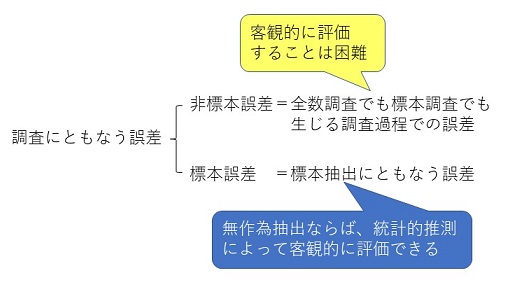

�@���̂悤�ɁA�����ɂ����ẮA�����ɂƂ��Ȃ��Ĕ�������덷��}���A���邢�͂��̑傫����]�����邱�Ƃ��d�v�ɂȂ�B���́A�����ɂƂ��Ȃ��덷�͕W�{���o�ɂƂ��Ȃ����̂���ł͂Ȃ��A���Ƃ��W�{���o���s�킸�ɁA�S���������s�����ꍇ�ł�����������덷�����݂���B�����ŁA���߂ł́A�������������ɂƂ��Ȃ��덷�ɂ��Ă܂Ƃ߂Ă������B

�}1.1�@�Љ�Ȋw�ɂ����铝�v�w�̖���

�@�����ɂƂ��Ȃ��덷�ɂ́A�}1.2�Ɏ����悤�ɕW�{�덷�Ɣ�W�{�덷��2��ނ�����B���̂����A��W�{�덷(non-sampling error)�́A�S�������ł��W�{�����ł������钲���ߒ��ł̌덷�ł���A����ɂ��ċq�ϓI�ɕ]�����邱�Ƃ͓���B���v�w���_�ł͕W�{�덷�ɂ��ẮA���Ȃ�ڍׂȋᖡ���s���邪�A��W�{�덷�ɂ��ẮA�Ȃ�����̊�������B�������A�����ɍs�Ȃ���ʏ�̒����ł́A��W�{�덷�̑��݂Ƃ��̑傫���́A���Ȃ�[���Ȗ��ƂȂ��Ă���B

�}1.2�@�����ɂƂ��Ȃ��덷

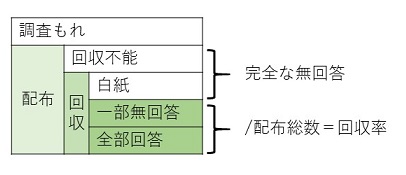

�@��W�{�덷�Ƃ��Ă�

�@��W�{�덷�̂����A1. ���̌덷�A2. �̕�ɂ��ẮA�ǂ̂悤�Ȓ������@���Ƃ�̂��ɂ���āA���̂����悻�̑傫���������Ă���B���⒲���[���g�����������@�Ƃ��ẮA�傫�������āA�\1.2�̂悤�ȕ��@���l������B

�\1.2�@�������@�̕���

| �L���� | ���u | �z�z | ��� | |

|---|---|---|---|---|

| �ʐڒ����@(interview survey) | ���L�� | �~ | ������ | ������ |

| �ʑO�L���@ | ���L�� | �~ | ������ | ������ |

| �z�z����@(���u(�ҵ�)�@) | ���L�� | �� | ������ | ������ |

| �X������@ | ���L�� | �� | �X�� | ������ |

| �X���@(mail survey) | ���L�� | �� | �X�� | �X�� |

�@�\1.2�̒��ɂ��鑼�L��(�܂��͑��v���Ƃ�����)�Ƃ́A�������������[�ɂ��������Ď��₵�A����ɑ��钲���Ώۂ̉����������[�ɋL����������ł���B����ɑ��āA���L��(�܂��͎��v���Ƃ�����)�Ƃ́A�����Ώۂ������Œ����[�̎����ǂ݂Ȃ���A�����ʼn��[�ɋL����������ł���B

�@�����̒������@�̔�r�͕\1.3�̂悤�ɂȂ�B��W�{�덷�Ƃ̊W�ł́A������A�̕�ɒ��ӂ��Ȃ���A�������@��I������K�v������B

�\1.3�@�������@�̔�r

| �ʐڒ����@ | �ʑO�L���@ | �z�z����@ | �X������@ | �X���@ | |

|---|---|---|---|---|---|

| ������p |

|

|

| ||

| �����[�̔z�z����ɗv���鎞�� |

|

|

| ||

| �����[�̉���� |

|

|

| ||

| �����Ώۖ{�l�̊m�F |

|

| |||

| ����̈Ӗ��̗���x |

|

| |||

| �̕� |

|

| |||

�@�ʏ�A�X���@�̉�����͂���߂ĒႭ�A�\3�̒��̐�����������ɒႭ�A10%���������̂��Ƃ������B�X���@�ʼn�����������Ƃ��ɂ́A�ނ���A�W�{���o�̎d���⒲���̎d�����^���Ă݂������悢�Ƃ�����قǂł���B������ɂ���A��ʂɂ́A�X���@�Ŏ��W���ꂽ�f�[�^�͒������̂��߁A���ꂩ��(3)�ŏq�ׂ閳�ɂƂ��Ȃ���W�{�덷���傫�����A���v�I�����͂��ĂɂȂ�Ȃ��̂ŗv���ӂł���B

�@���̕\3�̒��ŁA�ʐڒ����@�A�ʑO�L���@�Ɍ�����̕�́A��ɉ҂̓��������̍ۂɕۂ���Ă��Ȃ����Ƃɂ����̂ł���B���Ȃ��Ƃ��̍ۂɂ́A�҂͒�������ڂ̑O�ɂ��Ă���A�������̑��ł��N�����Ă���̂���F�����Ă��邩��ł���B���������āA�Ⴆ�Ή̕��1�ɂ��ẮA����������w�ł��邩�A�j�q�w���ł��邩�A���q�w���ł��邩�ɂ���āA���h��p������������̌X�����قȂ��Ă��邱�Ƃ��\���ɍl������B

�@�܂������������ɂ��Ȃ��Ă��A�������̈ӌ��ɂ���Ă��e�����邩���m��Ȃ��B�u���������̔�r�����v(���R 1984, p.66)�ɂ��ƁA�u��Ղ�M���邩�H�v�Ƃ�������ɑ��āA�\1.4�̂悤�ɒ������̈ӌ��̉e����������Ƃ�����B

�\1.4�@�������̈ӌ��Ɖ�

| �������̈ӌ� | �� | ||

|---|---|---|---|

| ��Ղ�M���� | ��Ղ�M���Ȃ� | �v | |

| ��Ղ�M���� | 25% | 75% | �@119 (100%)�@ |

| ��Ղ�M���Ȃ� | 12% | 88% | �@255 (100%)�@ |

�@�{���Ŏ��グ�Ă���u�g�D�������̂��߂̏]�ƈ��ӎ������v�̏ꍇ�ɂ́A�z�z����@�ɂ���āA1�T�Ԉȓ��̒Z���ԂɁA�ł��邾������(90���O��)�̉������500�l�ȏ�����邱�Ƃ�ڕW�Ƃ��čs����B���������z�z����@���\�Ȃ̂́A��Ƒ��̃j�[�Y�ɂ�����x���v�������e�ɂ��邱�ƂŁA�z�z����ɍۂ��Ă̋��͂�������Ƃ����l���I�ȑ��ʂ����ł͂Ȃ��A����������鑤�̏]�ƈ��̍�������͂Ƃ������ʂ��������Ȃ�(�\1.3�́u�̕�v�̗����Q�Ƃ̂���)�B�u�g�D�������̂��߂̏]�ƈ��ӎ������v�ł́A��r�I�傫�Ȋ�Ƃő呲���S�̃z���C�g�J���[���ΏۂƂ��Ă��邱�ƂŁA����̈Ӗ��̗���x��������x�ۏ���Ă���̂ł���B

�@�����ŁA��W�{�덷�̂����傫�ȕ������߂�u1. ���̌덷�v�ɂ��āA���̑傫�����ǂ̒��x�̂��̂ɂȂ�̂����l���Ă݂悤�B���̌덷�́A����������������Ⴂ���ƂɂƂ��Ȃ����̌덷�E����w���Ă���B�ʏ�A�}1.3�Ɏ������悤�ɁA�����ł́A��W�c�̃��X�g�̕s���A�ҕs�݂̂��߂̒E���A���ۂȂǂɂ�钲������������āA�����[���z�z�����B���̔z�z���ꂽ�����[�̒��̖��������ł������ł����B���̂����A���S�Ȗ��́A�z�z���ꂽ�����[�̂�������s�\���������́A����͂������������������̂Ƃɕ�������B���������z�z���ꂽ���̂̊��S���ł����������[���������c��̕����A�܂������ꂩ�ꕔ�܂��͑S������Ă��钲���[���́A�S�z�z���ɐ�߂銄����������ƌĂԁB

�}1.3�@��������Ɖ����

�@��ʂɁA���̌덷���d��ɂȂ�̂�

�@�����������̌덷���ǂ̒��x�̑傫���ɂȂ���̂Ȃ̂��A���ܗ�Ƃ��āAYes-No�`���̎�����l���Ă݂悤�B�������ʂ�(���Ȃ킿�ҌQ��) 60%��Yes�������Ƃ��A���ꂾ������Ɖߔ�����Yes�Ɠ������ƌ��������ł���B�������A�{���ɂ������낤���B���̒��x��Yes�䗦�ł́A���͖��ҌQ�ł�Yes��40%�ŁAYes�䗦��No�䗦�Ƃ��t�]���Ă����c�c�Ƃ����悤�ȃP�[�X���悭����̂ł���B����̃e�[�}�̒����ɑ��ẮA���̃e�[�}�ɍm��I�Ȑl�͉ɋ��͓I�����A�ے�I�ȁA���邢�͌������������Ă���l�́A���߂�ǂ���������A���ۂ����肷��Ƃ����X��������̂ŁA�ނ��낱�̒��x�̗��Q��Yes�䗦�̍��͂������ʂɑ��݂���ƍl���Ă����������悢�B

�@���ɗL������50%�Ƃ���ƁA�S�����Ώۂ�Yes�䗦�́A���҂̂��傤�ǒ��Ԃ�50%���������ƂɂȂ�B�܂�A

�@�@�@0.6�~0.5�{0.4�~0.5��0.5

�ƂȂ�B�������L������20%�Ȃ�A

�@�@�@0.6�~0.2�{0.4�~0.8��0.44

�ƂȂ��Ă��܂��A�Ȃ�Ǝ��ۂ̑S�����Ώۂł�Yes�䗦�͉ߔ���������A44%�������Ȃ��������ƂɂȂ�̂ł���B�ҌQ�����������Ƃ��̌�������Yes�䗦�Ƃ͌��_���t�]����B���͉ߔ�����No�������̂ł���B

�@����ł́A���������l��������������ʉ����āA���̂悤��Yes-No�`���̎���̖��̌덷���ǂ̒��x�̑傫���ɂȂ�̂����l���Ă݂邱�Ƃɂ��悤�B

�S�����Ώۂ�Yes�䗦

�@�@��(�ҌQ��Yes�Ґ��{���ҌQ��Yes�Ґ�)/�z�z����

�@�@��(�Ґ��~�ҌQ��Yes�Ґ�)/(�z�z�����~�Ґ�)�{(���Ґ��~���ҌQ��Yes�Ґ�)/(�z�z�����~���Ґ�)

�@�@���L�����~�ҌQ��Yes�䗦�{(1-�L����)�~���ҌQ��Yes�䗦

�@�@���ҌQ��Yes�䗦�{(1-�L����)�~(���ҌQ��Yes�䗦�|�ҌQ��Yes�䗦)�@�@�@ (1.1)

�����ŁA(1.1)���̉����������u���̌덷�v�Ƃ������ƂɂȂ�B���̖��̌덷�����ۂɌv�Z���Ă݂�ƁA�\1.5�̂悤�ɂȂ�B

�\1.5�@���̌덷(�Ԋ|�������͖��̌덷��5%�ȉ�)

| �L�� �� ��(%) | �b���ҌQ��Yes�䗦(%)�|�ҌQ��Yes�䗦(%)�b | ||||||||||

|---|---|---|---|---|---|---|---|---|---|---|---|

| 0 | 10 | 20 | 30 | 40 | 50 | 60 | 70 | 80 | 90 | 100 | |

| 100 | 0 | 0 | 0 | 0 | 0 | 0 | 0 | 0 | 0 | 0 | 0 |

| 90 | 0 | 1 | 2 | 3 | 4 | 5 | 6 | 7 | 8 | 9 | 10 |

| 80 | 0 | 2 | 4 | 6 | 8 | 10 | 12 | 14 | 16 | 18 | 20 |

| 70 | 0 | 3 | 6 | 9 | 12 | 15 | 18 | 21 | 24 | 27 | 30 |

| 60 | 0 | 4 | 8 | 12 | 16 | 20 | 24 | 28 | 32 | 36 | 40 |

| 50 | 0 | 5 | 10 | 15 | 20 | 25 | 30 | 35 | 40 | 45 | 50 |

| 40 | 0 | 6 | 12 | 18 | 24 | 30 | 36 | 42 | 48 | 54 | 60 |

| 30 | 0 | 7 | 14 | 21 | 28 | 35 | 42 | 49 | 56 | 63 | 70 |

| 20 | 0 | 8 | 16 | 24 | 32 | 40 | 48 | 56 | 64 | 72 | 80 |

| 10 | 0 | 9 | 18 | 27 | 36 | 45 | 54 | 63 | 72 | 81 | 90 |

| 0 | 0 | 10 | 20 | 30 | 40 | 50 | 60 | 70 | 80 | 90 | 100 |

�@�����ł����قǂ̂悤�ɁA���Ƃ��A�ҌQ�ł�Yes��60%�ʼnߔ�����Yes�ƌ����Ă��Ă��A���́A���ҌQ�ł�Yes��40%�������ꍇ���l���Ă݂悤�B���̂Ƃ��A���Q��Yes�䗦�̍���20%�ɂȂ�A�\1.5�̖��̗������Ƃ킩��悤�ɁA�L������50%�����̂Ƃ��ɂ́A���̌덷��10%����̂ŁA�S�����Ώ�(�W�{)��Yes�͎��͏����h�������Ƃ����t�]���ۂ��N�����Ă��܂��B

�@��ŁA��7���ŏq�ׂ�悤�ɁA�W�{���o�ɂƂ��Ȃ��W�{�덷�̖ڕW���x��5%���x�ɗ}�������ƍl���Ă���Ƃ��ɂ́A��W�{�덷�����߂ē����x��5%���炢�ɂ͗}���Ă����Ȃ��ƈӖ����Ȃ��B�����Ă��̂Ƃ��ɂ́A�����[�̉����(���L����)��80%�ȏ��ڕW�ɂ���K�v�����邱�ƂɂȂ�B����ɕ\1.5����A�����[�̗L������90%�ȏ゠��A�܂��t�]���ۂ̐S�z�͂Ȃ����Ƃ��킩��B

�@��W�{�덷�ɑ��āA�W�{�덷(sampling error)�͕W�{���o�ɔ����덷�ł���A�W�{�̒��o���@(sampling method)�ɂ���ẮA�q�ϓI�Ɏ�舵�����Ƃ��ł���B��̓I�ɂ́A���ɏq�ׂ�悤�ȗL�ӑI�o�@��p�����ꍇ�͍���ł��邪�A����ג��o�@��p���ĕW�{���o���s�����ꍇ�ɂ́A�m���_����ѓ��v�w���_�ɂ���ċq�ϓI�ɕ]�����邱�Ƃ��ł���B���ꂪ���v�I�����̗��_�ł���B�܂�A���v�I�����́A�ǂ̂悤�ȕW�{�ɑ��Ă��g����킯�ł͂Ȃ��B���̂��Ƃ����������ڂ������Ă݂悤�B

(a)�L�ӑI�o�@(purposive selection)

�@����́A�����҂��K���ɕW�{��I�ԕ��@�ł���B��Ƃ���������̊�Ƃ�����悤�ȕ��@(�@���@)��A���j�^�[���W���Ă��̈ӌ����悤�ȕ��@(����@)���L�ӑI�o�@�Ɋ܂܂��B�������A�����Ƃ��̌n�I�ȕ��@�́A���蓖�Ė@(quota method)�ƌĂ����̂ł����āA

(b)����ג��o�@(random sampling)

�@����́A�N�W�����̌����ŕW�{�ƂȂ�v�f�������_����(����ׂ�)�I�яo�����@�ł���B�����ɂ́A��W�c�̗v�f���X�g�ŁA�e�v�f�ɒʂ��ԍ������A���̒ʂ��ԍ����A�����\���������Ē��o���Ă����B���邢�́A���������0����9�܂ł̐�����2�ʂ����܂�Ă��鐳20�ʑ̂́u���������v��U���āA�o���ڂ����Ƃɂ��Ē��o���Ă����B������ȕ։��������̂ɁA�n�����o�@���邢�͓��Ԋu���o�@�ƌĂ����@������B�����ȈӖ��ł͖���ג��o�@�ł͂Ȃ����A��W�c�̑傫��n��W�{�̑傫��r�Ŋ�����n/r�ȉ��̍ő�̐���I�𒊏o�Ԋu�Ƃ��āA����I�ȉ��̖���ׂɑI���o�X�^�[�g�ԍ�����A���Ƃ͓��ԊuI�Ŕԍ����Ȃ��Ȃ�܂őI�ԕ��@�ł���B������ɂ���A����ׂɊm���I�ɒ��o������@��p����ƁA��W�c���\������S�v�f�ɂ��āA���ꂼ�ꂪ�W�{�Ƃ��Ē��o�����m�������ɂȂ�̂ŁA�W�{�̐��������W�c�̐������q�ϓI�ɕ]�����邱�Ƃ��ł���悤�ɂȂ�B���݂̓��v�w�̐���A����̗��_�͂��̖���ג��o�@��O��Ƃ��Ă���B

�@���������āA�����ł́A�L�ӑI�o�@�́u�Ȋw�I�ȁv�����ł͖{�����̑O�̗\���I�����ŗ��p������x�ɂ��ׂ��ł���Ƃ���Ă���B������

�@�������A�L�ӑI�o�@���̗p�����ꍇ�A���邢�͗L�ӑI�o�@�ɂ���ē���ꂽ�f�[�^������ꍇ�ɂ́A�\1.6�ɂ܂Ƃ߂�ꂽ�����ɒ��ӂ��Ȃ��Ă͂Ȃ�Ȃ��B���Ȃ킿�A�L�ӑI�o�@�ł́A����ג��o�@�Ƃ͈قȂ�A�f�[�^�͕�������A���������x�͍����Ă����Ăɂ͂Ȃ�Ȃ��Ƃ������Ƃ�F������K�v������B�����āA�L�ӑI�o�@�œ���ꂽ�f�[�^�ɂ��ẮA���v�I�����͖��͂��Ƃ������Ƃł���B���Ȃ킿�A����ג��o�@�ɂ���Ē��o���ꂽ�W�{�ɂ̂݁A���v�I�������\�Ȃ̂ł���B����ɑ��āA����ג��o�@�ł́A���������邱�Ƃ��ł��邵�A���x�͕W�{�̑傫����傫�����邱�Ƃō��߂���B�������A���x�̕]�����q�ϓI�ɍs�����Ƃ��ł���̂ł���B

�\1.6�@�W�{�����W�c�̓����𐄘_����ꍇ�̗L�ӑI�o�@�Ɩ���ג��o�@�̔�r

| �L�ӑI�o�@ | ����ג��o�@ | |

|---|---|---|

| �� | ����ł��Ȃ� | ����ł��� |

| ���x | �ӎ��I�ɗ��̂�������v�f��I��ŕW�{�ɂ��邱�Ƃō��߂��� | �W�{��傫�����邱�Ƃō��߂��� |

| ���x�̕]�� | ���� | �m���_�E���v�w�ʼn\ |

�@����ł́A����ג��o�̏ꍇ�ɂ́A�ǂ̂悤�ɂ��Ă��̂悤�Ȉ�A�̓��v�I�������\�Ȃ̂ł��낤���B���̂��Ƃ����ꂩ���5�߁`��7�߂ɂ����āA�m���A��������A����̏��Ɍ��Ă������Ƃɂ��悤�B�������A����ג��o�@�́A�W�{�덷�ɑ��ẮA���ɗL���Ȓ��o���@�ł��邪�A��W�{�덷�ɑ��ẮA�Ȃ��ۏ�����̂ł͂Ȃ��B���̂��Ƃ͏\���ɔF�����Ă����K�v������B

�@����ȍ~�A�m���̘b�����X�������A����͓�̖ړI�̂��߂ɕK�v�Ȃ��̂ł���B��́A�ʏ�A���v�������s�����ۂɂ悭�p������u�L�Ӑ����v�܂��́u�L�ӊm���v�̊T�O�𐳂����������Ă��炤���߂ł���B������́A�W�{�̑傫���̂��Ӗ��𗝉����Ă��炤���߂ł���B����́A��������悷��ۂɁA�K�ɕW�{�̑傫�������߂邽�߂ɏd�v�ɂȂ��Ă��邾���ł͂Ȃ��A���ɍs���Ă��܂��������̕W�{�덷��]������ۂɂ���{�I�ȏ��ƂȂ邩��ł���B�������A�S��������O��ɂ���ꍇ�ɂ́A����ȍ~�̐߂͕K�v���Ȃ��Ȃ�B

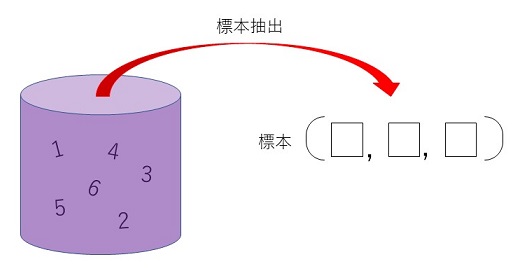

�@���܁A�傫��n�̕�W�c����W�{�Ƃ���r�̗v�f������o(sampling without replacement)�Ŗ���ׂɒ��o���邱�Ƃ��l���悤�B�܂�Ar�̂��̂����o���Ƃ��ɁA1���Ƃɂ����������ɖ߂����ɁA������r�����o�����Ƃ��l����B���̕W�{���o�ɂ���ē����錋��(outcome)�A���Ȃ킿�W�{�̂��Ƃł��邪�A����͕W�{�_�ƌĂ��B������\�ȕW�{�_�̏W���͕W�{���(sample space)�ƌĂ�āA���ŕ\���B

�@��) ���ܕ�W�c�Ƃ��āA�u���p���v�w�v�𗚏C����w���̏W�����l���Ă݂悤�B�w���͗��C�ԍ��ŕ\�������̂Ƃ���B�u���p���v�w�v�𗚏C����w����6�l������(n��6)�Ƃ���ƁA��W�c�͏W���o1,2,3,4,5,6�p�ŕ\�����Ƃ��ł���B���̕�W�c����A�}1.4�̂悤�ɁA�W�{�Ƃ���3�l�̊w���𒊏o����ꍇ���l���Ă݂悤(r��3)�B���̏ꍇ�A�W�{�͕�W�c���璊�o���ꂽ3�l�̊w���̑g�A���Ƃ���(1,2,3), (2,3,6)�̂悤�ɕ\�����B

�}1.4�@�傫��6�̕�W�c����傫��3�̕W�{�̒��o

�@���̂Ƃ��A�W�{�_�������o���ƁA�W�{��ԃ��́A���̂悤��20�̕W�{�_����Ȃ�W���ɂȂ�B

| ����{(1,2,3), (1,2,4), (1,2,5), (1,2,6), |

| (1,3,4), (1,3,5), (1,3,6), |

| (1,4,5), (1,4,6), |

| (1,5,6), |

| (2,3,4), (2,3,5), (2,3,6), |

| (2,4,5), (2,4,6), |

| (2,5,6), |

| (3,4,5), (3,4,6), |

| (3,5,6), |

| (4,5,6)} |

�@���������āA�W�{�ƂȂ�w���̑g�����Ƃ��ẮA20�ʂ肪�l������B�܂�傫��6�̕�W�c����傫��3�̕W�{�𒊏o����Ƃ��̕W�{�_�̌���20�Ƃ����킯�ł���B���̏ꍇ�A�W�{��ԃ��̗v�f�����ׂĂ������������o���Ȃ��Ă��A�W�{�_�̌��́A��W�c��6�̗v�f����W�{�Ƃ���3�̗v�f���Ƃ��Ă���g�����̐��Ȃ̂ŁA���̂悤�ɂ��v�Z�ł���B

�@�@�@6C3��(6�5�4)/(3�2�1)��20

���̌v�Z���@�ɂ��ĊT�����Ă������B�܂��ŏ��ɁA��ʂɁA����(permutation)�Ƃ�n�̂��̂���r�Ƃ���1��ɕ��ׂ����̂̂��Ƃł���An�̂��̂���r�Ƃ鏇��̐��́A���̂悤�ɗ^������

�@�@�@nPr��n(n�|1)(n�|2)���(n�|(r�|1))��n!/(n�|r)!

�����ŁAn!��n(n�|1)(n�|2)���3�2�1 �ł���A�����n�̊K��(factorial)�Ƃ�ԁB0!��1 �Ƃ������Ƃ����Ă������B�܂�A��̐擪�ɉ�������̂���n�ʂ�l�����A�擪��1�����߂�A���̐擪����2�Ԗڂɂ́A�擪�ɒ�߂�ꂽ2���������c���n�|1�̒�����ǂꂩ����I��邱�ƂɂȂ�̂�n�|1�ʂ�c�c�����ė�̍Ō��1�͎c���Ă���n�|(r�|1)�̒�����I���̂ŁAn�|(r�|1)�ʂ�A���������ׂĊ|�����킹��Ƃ��̂悤�Ȏ��ɂȂ�̂ł���B

�@����ɁA�g�������l���邱�Ƃ��ł���B���܁A�Ƃ��Ă���r���ǂ̂悤�ȏ����ɕ���ł��Ă��A�g�����Ƃ��Ă͓������̂ƍl������̂ŁArPr��r!�̏���͈�̑g�����Ƃ��Đ�������ׂ����̂Ƃ������ƂɂȂ�B���������āAn�̂��̂���r�Ƃ�g����(combination)�̐���

�@�@�@nCr��nPr/r!��n!/{r!(n�|r)!}

�ƂȂ�B

�@����(event)�Ƃ́A�W�{��ԃ��̕����W���̂��Ƃł���A�Ȃ�炩�̈Ӗ��ŊS��������錋�ʂ̏W���ł���B�����قǂ�6�l�̊w������Ȃ��W�c����3�l�̊w���𒊏o�����ł́A���Ƃ��A���̂悤�Ȏ��ۂ��l���邱�Ƃ��ł���B

�@�@�@A��{(1,2,6), (1,3,5), (2,3,4)}

�@�@�@B��{(1,3,5)}

����A�͊w���̗��C�ԍ��̘a�����傤��9�ɂȂ鎖�ۂ�\���Ă���A����B�͊�̗��C�ԍ��̊w���݂̂ł���Ƃ������ۂ�\���Ă���B

�@�W�{���o(����ʓI�ɂ́u���s�v)���s���ƁA�K���W�{��ԃ��̒��̂�����̕W�{�_�ւ��������邱�ƂɂȂ�B���̎��������W�{�_�ւ�����A�ɑ�����Ƃ��A���̎���A�����N�����Ƃ����B�Ⴆ�A6�l�̊w������3�l��W�{���o����ƁA�w��1�A�w��3�A�w��5�����o�����ƁA3�l�̗��C�ԍ��̘a��9�ɂȂ�A����A�����N�������ƂɂȂ�B���͎���B�������ɐ��N���Ă���B

�@���ܕW�{������ג��o�����ꍇ���l���悤�B�Ⴆ�A���������U���āA�o���ڂ̗��C�ԍ��̊w����W�{�Ƃ��Ē��o����̂ł���B���̂Ƃ��A�W�{���o�̌��ʂ͒��o�ߒ��̋��R���ɉe������邱�ƂɂȂ�B���v�I�ōl������B��̋��R�I�����́A�W�{�̕�W�c����̃����_���Ȓ��o�����ł���B���̂Ƃ��u����A�̐��N���邱�Ƃ̊m���炵���v�܂�A�m�����͂��߂čl���邱�Ƃ��ł���B��ʂɁA���N����m�����l�����鎖�ۂ��m������(probability event)�Ƃ����BPr(A)�ŁA����A�̐��N����m����\�����Ƃɂ��悤�B

�@����ł́A�W�{������ג��o�����ꍇ�ɁA�ǂ̂悤�Ɋm��Pr(A)��t�^���邱�Ƃ��ł���̂ł��낤���B����n�̕W�{�_����Ȃ�W�{��ԃ����l����B����ג��o�ɂ���ĕW�{�𒊏o�������An�̕W�{�_�̂ǂ�����A���N���邱�ƂɊւ��Ắu�����x�Ɋm���炵��(equally likely)�v�B���������āA���̂Ƃ��A����A�̐��N����m��Pr(A)�́A����A�ɑ�����W�{�_�̌�k��m(A)�ŕ\���ƁA

�@�@�@Pr(A)��m(A)/m(��)��k/n

�ƒ�`�ł���B�����قǂ̗�ł́A

�@�@�@m(��)��20

�@�@�@m(A)��m({(1,2,6), (1,3,5), (2,3,4)})��3

�@�@�@m(B)��m({(1,3,5)})��1

�Ȃ̂ŁAPr(A)��3/20�APr(B)��1/20 �ƂȂ�B�������āA���̖���ג��o�̂Ƃ��ɒ�`�����m���́A�W�{�_�̌��A�܂�A�N������̏ꍇ�̐��̐����グ�ɋA����킯�ł���B

�@�m���ϐ�(random variable)�Ƃ͕W�{��ԃ��̏�Œ�`���ꂽ�����l���Ƃ��X(��)�C�ց��� �̂��Ƃł���B�W�{���o�̌��ʂƂ��ĕW�{�_�ւ���܂�ƁA�����lx��X(��)����܂�B�t�ɁA{��: X(��)��x}�ƏW�����`����ƁA����͕W�{��Ԃ̕����W���ƂȂ�B�������͊m�����ۂƂȂ�̂ŁA�m�� Pr({��: X(��)��x}) ��^���邱�Ƃ��ł���B��ʂɁA���� Pr({��: X(��)��x}) ���ւ��ȗ����āAPr(X��x)�Ə����B�܂�A�m���ϐ��́A���ꂪ�Ƃ�e�l�ɑ��āA���ꂼ��m�����^�����Ă���ϐ��Ȃ̂ł���B���Ȃ݂ɁA�m���ϐ���X�̂悤�Ƀ��[�}���̑啶���ŕ\���B

�@��̑���) �����قǂ̗�Ɠ��l�ɁA�u���p���v�w�v�𗚏C����w���̏W���o1,2,3,4,5,6�p���W�c�Ƃ���B���̂����A���C�ԍ�1,2,3�̊w���́u��b���v�w�v�̎����ɍ��i���A�P�ʂ��擾���Ă��邪�A����3�l�̊w���́u��b���v�w�v�̒P�ʂ��擾���Ă��Ȃ��B�����ł��܁A3�l�̊w����W�{�Ƃ��Ē��o���邱�Ƃ��l���A�m���ϐ�X�ł��̕W�{���́u��b���v�w�v�̒P�ʎ擾�Ґ���\�����̂Ƃ���B�W�{�̑傫����3������A�m���ϐ�X(��)��0,1,2,3�̂����ꂩ�̒l���Ƃ邱�ƂɂȂ�B

�@�@�@{��: X(��)��3}��{(1,2,3)}

�@�@�@{��: X(��)��2}��{(1,2,4), (1,2,5), (1,2,6), (1,3,4), (1,3,5), (1,3,6), (2,3,4), (2,3,5), (2,3,6)}

�@�@�@{��: X(��)��1}��{(1,4,5), (1,4,6), (1,5,6), (2,4,5), (2,4,6), (2,5,6), (3,4,5), (3,4,6), (3,5,6)}

�@�@�@{��: X(��)��0}��{(4,5,6)}

����ג��o�ɂ���ĕW�{�𒊏o�������A20�̕W�{�_�̂ǂꂪ���N����̂������x�Ɋm���炵���̂�

�@�@�@Pr(X��3)��Pr({��: X(��)��3})��1/20

�@�@�@Pr(X��2)��Pr({��: X(��)��2})��9/20

�@�@�@Pr(X��1)��Pr({��: X(��)��1})��9/20

�@�@�@Pr(X��0)��Pr({��: X(��)��0})��1/20

�ł���B�Ƃ���ŁA�W�{���́u��b���v�w�v�̒P�ʎ擾�҂̊�����P�ŕ\���ƁAP��

�@�@�@P��X/3

�Œ�`����A0, 1/3, 2/3, 1 �̂����ꂩ�̒l���Ƃ�B����ƁA��̎�����

�@�@�@Pr(P��1)��Pr(X��3)��1/20

�@�@�@Pr(P��2/3)��Pr(X��2)��9/20

�@�@�@Pr(P��1/3)��Pr(X��1)��9/20

�@�@�@Pr(P��0)��Pr(X��0)��1/20

�ƂȂ�B�܂�AP���m���ϐ��ƂȂ�B����ʓI�Ȕ䗦�ɂ��Ă̊m���̌v�Z�ɂ��ẮA�t�����Q�Ƃ̂��ƁB

�@�������ɑ����悤�B�u���p���v�w�v�̎��Ƃ��n�߂�ɓ����āA���Ƃ̃��x����ݒ肷�邽�߂ɁA�u���p���v�w�v�𗚏C���Ă���6�l�̊w���̒�����A����������g���āA3�l��W�{�Ƃ��Ē��o(�����o)���A����3�l�ɂ��Ċe�X���O�Ɍ����������s�����B���̌��ʁA3�l�Ƃ��u��b���v�w�v�I�����Ɠ����ȏ�̒m���������Ă��邱�Ƃ��킩�����B�������A���ɁA�u��b���v�w�v�Ɠ����ȏ�̒m���������Ă���҂��A�u���p���v�w�v�̗��C��6�l�̂����A���傤�ǔ�����3�l�����������Ƃ��Ă��A���o�̃v���Z�X�ŁA���R�A����3�l�𒊏o���Ă��܂��A���������������ʂ������邱�Ƃ����肤��B���̏ꍇ�A����ג��o�ŕW�{���o�����̂ŁA�e�W�{�_�̂ǂ�������o�����͓̂����x�Ɋm���炵���A���̊m���́A�e�ՂɌv�Z���邱�Ƃ��ł���B���Ȃ킿

�@�@�@Pr(P��1)��Pr(X��3})��1/20��0.05

�ƂȂ�B���������āA���Ɂu��b���v�w�v�Ɠ����ȏ�̒m���������Ă���҂��A�u���p���v�w�v�̗��C��6�l�̂����A���傤�ǔ�����3�l�����������Ƃ������Ƃ��{�����Ƃ���ƁA�W�{�S�����u��b���v�w�v�I�����Ɠ����ȏ�̒m���������Ă����Ƃ����m���́A�킸��5%�����Ȃ��Ƃ������ƂɂȂ�B���̒�m���ł́A��W�c��3�l�������u��b���v�w�v�Ɠ����ȏ�̒m���������Ă����Ƃ͍l���ɂ����ł��낤�B

�@���̂��Ƃ��A��������̌��t���g���ƁA���̂悤�ɋL�q���邱�Ƃ��ł���B�܂��ŏ��ɁA

�@�Ƃ���ŁA��W�c�ł���u���p���v�w�v�̗��C�ґS�̂̂����A�u��b���v�w�v�Ɠ����ȏ�̒m���������Ă���҂̔䗦���ŕ\���ƁA�����قǂ̉����́A

�@��W�c�ł̓�0.5�������̂ɁA���R�A�W�{�ł�P��1�ɂȂ��Ă��܂����Ƃ����ꍇ�́u���R�v�̕������m���ŕ\���������̂�L�ӊm���Ƃ����B���������āA�L�ӊm�����傫���Ƃ��ɂ́A�W�{�ł�P��1�́u�悭������R�v�ƕЕt���Ă��܂��Ă��܂�Ȃ��B���̂悤�ȋ��R�́A�W�{���o�̃v���Z�X�Ŕ�����������̂ŁA���v�I�ɂ͂悭���邱�ƂŁA�Ӗ��̂Ȃ����̂ł���B�܂�A�W�{�덷�͈͓̔��Ƃ����킯�ł���B�������A��قǂ̂悤�ɁA5%�ƗL�ӊm������������A�W�{�ł�P��1�́u�߂����ɂȂ����R�v�ł���B���̂Ƃ��́A�W�{�덷�ł͕Еt����ꂸ�A���v�I�ɂ������ł��Ȃ��Ӗ��������ƂɂȂ�B���̂��Ƃ��u���v�I�ɗL�Ӂv���邢�͒P�Ɂu�L�Ӂv(significant)�Ƃ����B���̏ꍇ�ɂ́A�t�ɁA��W�c�Ń�0.5�Ƃ��������̕����^���ׂ��ł���ƌ��_�Â���̂���������̊�{�I�l�����ł���B�܂�A��0.5�ł͂Ȃ��āA��0.5�ł��낤�Ɣ��f����̂ł���B

�@�ȏ�̂��Ƃ�����ƁA���v�I�����Ƃ́A��W�c�̓����l�A���Ƃ��A�䗦�A���邢�́A��3�͈ȍ~�Ő������镽�ρA���U�A���W���Ȃǂɂ��ė��Ă��鉼���̂��Ƃł���B������������H0�́u���p����v(�����ɋA��)���߂ɐݒ肳�ꂽ���̂ł���A���̂��Ƃ���A������(null hypothesis)�Ƃ���B���̂悤�ɉ�������ł́A��W�c�̓����l�Ɋւ���A���������^�ł���Ƃ��ɁA����ɑΉ�����W�{�̒l�̐��N����m�����A�L�Ӑ���(level of significance; 5%���悭�g����)�ɖ����Ȃ��Ƃ��A����͋A���������^�łȂ��Ɣ��f����ɏ\���ȏ؋��ƍl����̂ł���B(�����K���1.2)

�@����ג��o�@���Ƃ�Ƃ��A�W�{�̑傫��(sample size)�́A�W�{�덷���ǂ̒��x�ɗ}���������Ō��߂���ׂ����̂ł���B�W�{�����̏ꍇ�A�덷�́A�t�ɐ��x�Ƃ����T�O�ōl�@�����B�W�{�����ɂ����āA���̂悤�ɂ��Ď��O�Ɍ��߂����x�̂��Ƃ�ڕW���x�ƌĂԁB

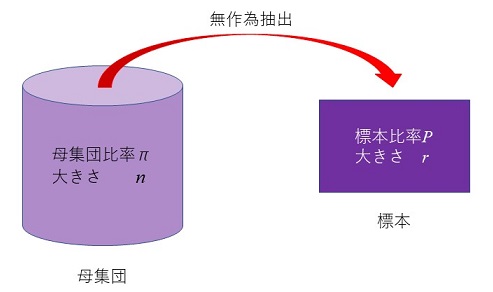

�@���ܔ䗦�̐�����l���悤�B�傫��n�̕�W�c�̂���A�Q�ł����W�c�䗦���Ƃ���B���̕�W�c���疳��ג��o�@�ɂ���āA�傫��r�̕W�{�𒊏o���A���̂���A�Q�ł���W�{�䗦��P�Ƃ��悤�B����ג��o���s���Ă���̂ŁA�W�{�䗦P�͊m���ϐ��ƂȂ�B

�}1.5�@��W�c�䗦�ƕW�{�䗦

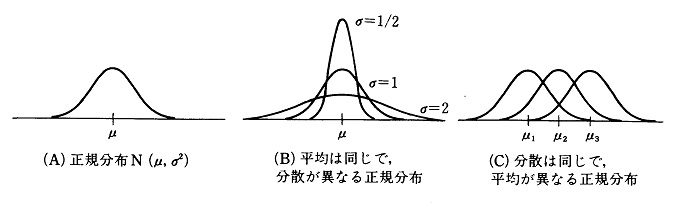

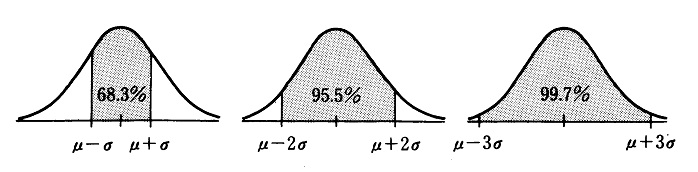

�@�W�{�̑傫��r���A�ق�50����傫���ł���Ȃ�A���S�Ɍ��藝�ɂ���āA�W�{�䗦P�͎��̊��Ғl�A���U�������K���z�ɂ��������m���ϐ��ƂȂ邱�Ƃ��m���Ă���B

�@�@�@����: E(P)����

�@�@�@���U: V(P)��{(n�|r)��(1�|��)}/{(n�|1)r}

���������āA��ʂɐ��K���z�ɏ]���A

�@�@�@Pr({�|1.96(V(P))1/2��P���{1.96(V(P))1/2})��0.95

��������̂�(��3�͑�7���Q�Ƃ̂���)�A���̎���ό`����

�@�@�@Pr({P�|1.96(V(P))1/2����P�{1.96(V(P))1/2})��0.95

�ƂȂ�B�܂�A��W�c�䗦���W�{�䗦P�}1.96(V(P))1/2�ȓ��Ɏ��܂�m����95%���Ƃ������ƂɂȂ�B����������A�M���x95���ŕ�W�c�䗦�𐄒肷�邱�Ƃ��ł���̂ł���B(���̂Ƃ��A��� [P�|1.96(V(P))1/2, P�{1.96(V(P))1/2] �͐M���W��(confidence coefficient) 95����P�̐M�����(confidence interval)�Ƃ���B)

�@���̂Ƃ��A����̌덷�̐�Βl��

�@�@�@�Á�1.96(V(P))1/2�@�@�@(1.2)

�Ƃ����ƁA�Â͐�ΐ��x(absolute precision)�Ƃ�����̂ɂȂ�B���x�̍����������邢�͐���Ƃ́A����̕���1/2�ɑ�������Â̏��������̂�����(�������A�P�Ɂu���x�v�Ƃ������ꍇ�ɂ́A�W�{���U�̋t���Œ�`�����̂Œ��ӂ���)�B���̂悤�ɁA��W�c�̓����l��������̊m���ȏ�Ŏ��܂��Ԃ����߂鐄��@�́A��Ԑ���@(interval estimation)�Ƃ���B

�@�W�{�̑傫��r���傫���Ȃ�ق�V(P)�����ăÂ͏������Ȃ�̂ŁA�K�v�ȕW�{�̑傫��s�́A�ڕW���xd�ɑ��āA�Á�d�ƂȂ�悤�ȍŏ��̕W�{�̑傫���ł���Bs�́A(1.2)����r�ɂ��ĉ�����

�@�@�@r��n/����

�@�@�@���ꁁ(��/1.96)2[(n-1)/{��(1-��)}]�{1�@�@�@(1.3)

�ŃÁ�d�Ƃ����ċ��߂�r�ȏ�̍ŏ��̐����ł���B

�@��ʂɁA��W�c�䗦�͖��m�Ȃ̂ŁA��0.5 �Ɖ��肷��B�Ȃ��Ȃ�A���̂Ƃ�(V(P))1/2�͍ő�ɂȂ�̂ŁA��0.5 �Ɖ��肵�Ă����A�덷���ő�Ɍ��ς��������ƂɂȂ邩��ł���B(1.3)���̒��̃�(1�|��)���A��0.5�̂Ƃ��ő�ƂȂ�B�ڕW���x��d��0.05 (5%)���x�ɂ��邱�Ƃ��l����ƁA�K�v�ȕW�{�̑傫��s�́A(1.3)����p����A�\1.7(a)�̂悤�ɂȂ�B�����A�ڕW���x��d��0.025 (2.5%)�ɏグ�悤�Ƃ���ƁA�\1.7(b)�̂悤�ɂȂ�B

�\1.7�@�ڕW���x�ƕW�{�̑傫��

(a)�ڕW���xd��0.05 (5%)�̂Ƃ��ɕK�v�ȕW�{�̑傫��(�ߎ��l)

| n | 50 | 100 | 1,000 | 2,000 | 5,000 | 10,000 | 20,000 | 50,000 | �� |

|---|---|---|---|---|---|---|---|---|---|

| s | 45 | 80 | 278 | 323 | 357 | 370 | 377 | 382 | 384 |

(b)�ڕW���xd��0.025 (2.5%)�̂Ƃ��ɕK�v�ȕW�{�̑傫��(�ߎ��l)

| n | 50 | 100 | 1,000 | 2,000 | 5,000 | 10,000 | 20,000 | 50,000 | �� |

|---|---|---|---|---|---|---|---|---|---|

| s | 49 | 94 | 607 | 870 | 1176 | 1332 | 1427 | 1492 | 1537 |

�@�\1.7��(a)��(b)���r����ƁA���x���グ�Ă��̕���1/2�ɂ���̂ɂ́A�W�{�̑傫�����4�{�ɂ��Ȃ���Ȃ�Ȃ����Ƃ��킩��B��ʂɁA�ڕW���xd��1/k�{�ɂ��悤�Ƃ���ƁA�K�v�ȕW�{�̑傫���͖�k2�{�ɂȂ�B�Ȃ��Ȃ�(1.3)���̕���Ƀ�2�����邩��ł���B�܂������̐��x�́A��W�c�̑召�ɂقƂ�NJW�Ȃ��A�W�{�̑傫���̕������ɂقڔ���Ⴗ��B����������50�l���x�̕�W�c�ł́A�W�{�����Ƃ����Ă��A�قƂ�ǑS���������K�v�ɂȂ����ŁA�ǂ�Ȃɕ�W�c���傫���Ă��A�ڕW���x��5%�Ȃ��400�l���x�A�ڕW���x��2.5%�ł�1600�l���x�̑傫���̕W�{�ł���A�\���ɖڕW��B������B

�@�Ƃ���ŁA�W�{�̑傫����400���x����A��ΐ��x��5%�ȉ��ɗ}������Ƃ������Ƃ́A�t�ɂ����A���Ƃ��ΕW�{�䗦��56%�ł���A��W�c�䗦��50%�ł���m����5%(��1�|�M���W��)�ȉ��Ƃ������Ƃł���B�܂�AH0: ��0.5 �Ƃ��������́A����������s���Ί��p����邱�ƂɂȂ�B��������ς���A5%���x�̔䗦�̍������v�I�ɗL�ӂɂȂ�A�Ӗ������悤�ɁA�W�{�̑傫�������߂Ă���Ă��邱�ƂɂȂ�B���̂悤�ɁA�W�{�̑傫�����\���ɑ傫���āA���x���\���Ɍ��サ�Ă���A���͂₢��������������ɋC���K�v�͂Ȃ��B�������ɁA�������W�{�̃f�[�^��^�����Ă���Ƃ��ɂ́A��������ŕ�W�c�ɂ��Ă̒m���������E�ᖡ����K�v������B�������A�\���ȑ傫���̕W�{���m�ۂ��邱�Ƃ��ł����Ȃ�A�������肪���ۏ�K�v�Ȃ��قǁA����̐��x���m�ۂł������ƂɂȂ�̂ł���B

�@����܂ł̋c�_���A���ۂɒ�����v���A�Ǘ�����Ƃ����ϓ_����܂Ƃ߂�ƁA���̂悤�ɂȂ�B�����ɂƂ��Ȃ��덷���l���A�W�{�덷(��Ό덷)�Ɣ�W�{�덷���Ƃ���5%�ȓ��ɗ}����Ƃ������Ƃ��߂����̂ł���A�W�{�̑傫���Ƃ��Ă�500���x�m�ۂ�(���������āA���S���x�̑傫���̕�W�c�łقƂ�ǑS���������K�v�ɂȂ�)�A�����80%�ȏ���߂����āA���߂ׂ̍����Ǘ������邱�Ƃ��l����ׂ��ł���B

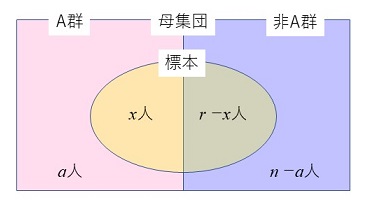

�@�䗦�ɂ��Ă̗L�ӊm���̌v�Z�́A��ʓI�ɂ͂ǂ̂悤�ɍs����̂ł��낤���B���܁An�̗v�f����Ȃ��W�c���l����B���̕�W�c�̗v�f�́AA�Q�A��A�Q��2�Q�ɕ��ނ���A�e�v�f���ǂ���̌Q�ɑ����邩�͊ȒP�ɋ�ʂł���Ƃ���B

�@���̕�W�c��������o(sampling without replacement)�ŁAr��W�{�Ƃ��Ē��o���邱�Ƃ��l���悤�B�܂�Ar�̂��̂����o���Ƃ��ɁA1���Ƃɂ����������ɖ߂����ɁA������r�����o�����Ƃ��l����B

�}1.6�@�L����W�c����̒��o

�@�m���ϐ�X�ő傫��r�̕W�{�̂����AA�Q�ɑ�����v�f�̐���\�����̂Ƃ���B�����

�@�Ƃ���ŁA�W�{�ł�A�Q�̔䗦P��x/r�́A��W�c��A�Q�̔䗦����a/n�ɓ������Ȃ肻���Ȃ��̂����A����ג��o������A���R�̂�������ŁAP��0�`1�܂ł̒l���Ƃ肤��\��������(�������A�W�{�̑傫���ɔ�ׁA��W�c���\���ɑ傫���Ƃ�)�B�������A�������܂��������A�m���ϐ��ł���W�{�䗦P�̂Ƃ肤��l���A�m�����E�F�C�g�Ƃ��ĉ��d���ς����l(��������Ғl�Ƃ���)�͕�W�c�䗦�ɓ������Ȃ�B���ہA(1.5)���ŕ\�����ꍇ�̒����z�̕���(�����Ғl)�A���U�͎��̂悤�ɂȂ�B

�@�@�@����: E(P)����p p�h(p)����

�@�@�@���U: V(P)��{(n�|r)��(1�|��)}/{(n�|1)r}

���̂悤�ɁA�W�{�䗦�̊��Ғl����W�c�䗦�ƈ�v����ꍇ�A�W�{�䗦�͕�������Ȃ�(���s��)�Ƃ�����B

�@����܂ł́An�̗v�f����Ȃ�L����W�c��������o���s�����Ƃ��l���Ă����B���܂����An�����ɑ傫���Ƃ��A�ɒ[�ɂ͖����ɑ傫���ƍl������Ƃ��͂ǂ��Ȃ�ł��낤���B(1.4)������

�@�@�@h(x)��[(n��)(n��-1)���(n��-(x-1))/x!]�~[(n(1-��))(n(1-��)-1)���(n(1-��)-(r-x-1))/(r-x)!]�~[r!/{n(n-1)���(n-(r-1))}]

�ƂȂ�A���̎��̕��ꕪ�q��nr�Ŋ����

�@�@�@h(x)��[r!/x!(r-x)!]�~[{��(��-1/n)���(��-(x-1)/n)�E(1-��)((1-��)-1/n)���((1-��)-(r-x-1)/n)}/{1�(1-1/n)���(1-(r-1)/n)}]

�ƂȂ�B���������āA�����z�� n�����̂Ƃ�

�@�@�@limn���� h(x)��rCx��x(1-��)r-x��b(x)

�ƂȂ�B���̕��zb(x)�͓��z(binomial distribution)�Ƃ���B���̕��z�̖��O�̂����́A��

�@�@�@(��+(1-��))r

��W�J�����Ƃ��A��x(1-��)r-x�̍��̌W����rCx�ɂȂ��Ă��邱�Ƃɂ��B�ȏ�̂��Ƃ���A��W�c�̑傫��n���傫���Ƃ��ɂ́A�����z����z�ŋߎ����邱�Ƃ��ł���B

�@���z�́A������W�c����̒��o�����ł͂Ȃ��A���Ƃ��L����W�c�ł����Ă��������o(sampling with replacement)�A�܂�1���o�����Ƃɂ����������ɖ߂��Ȃ���r�̕W�{�����o���Ƃ��ɂ�������B�Ȃ��Ȃ�A�ǂ���̏ꍇ�ɂ��A��W�c����1�v�f�����o�����Ƃ��ɁA���ꂪA�Q�ł���m���̓A��A�Q�ł���m����1-�ŁA����͒��o�ɂ�����炸��肾����ł���B���������āAA�Q��x�A��A�Q��r-x�ł����A���Ƃ���

�@�@�@AA(��A)A�c�c(��A)A

��������m����

�@�@�@��(1-��)�c�c(1-��)����x(1-��)r-x

�ł���B���̎�������킩��悤�ɁAA�Q�Ɣ�A�Q�̗v�f�̕��ԏ����ɂ͊W�Ȃ��A�`�Q��x�A��A�Q��r-x�ł���W�{�_�́A�����m���������ƂɂȂ�B���������āA����Ɠ����m�������W�{�_�́A�W�{��Ԃ̒��� rCx����̂ŁA���ʂƂ���

�@�@�@rCx��x(1-��)r-x��b(x)

�Ƃ������z��������킯�ł���B

1.1 �����̎�� �@��3��(1)�Ő����������ނɂ��������āA�{���œ��v�����̎���Ƃ��Ď��グ�Ă���u�g�D�������̂��߂̏]�ƈ��ӎ������v�̎�ނނ��Ă݂�B�K�v�ł���A��6�����ǂ�ł݂邱�ƁB

1.2 �������� �@��6���̗�ŁA�������������̌��ʁA�W�{3�l�̂���2�l�������u��b���v�w�v�I�����Ɠ����ȏ�̒m���������Ă��邱�Ƃ��킩�����Ȃ�A���̂Ƃ����� H0: ��0.5 �̌�����s�Ȃ��Ă݂�B

1.3 ���ꂽ�������ʂ̕]�� �@�ŋ߁A�V���ŕ��ꂽ�������ʂ��ȏ�T���A���̒������ʂɂ��āA(1)��W�c�̒�`�A(2)�S���������W�{�������A(3)�W�{�����̏ꍇ�ɂ͕W�{���o�̕��@�A(4)�������_�A(5)�������@�A(6)������ׂ�B

1.4 �����̊�� �@�u�V�l�ސ���̈ӎ���T��v�Ƃ����e�[�}�ŁA�]�ƈ��K��(���Ј��̂�) �P���l���x�̊�Ƃ̈ӎ��������������B�ǂ̂悤�Ȓ��������ׂ������𗧂Ă�B

�@��1�͂ł͓��v�w����ђ����̍l�������T�ς����̂ŁA���̏͂���͂��������u�g�D�������̂��߂̏]�ƈ��ӎ������v�ɂ���ē���ꂽ�f�[�^��f�ނɂ��āA�R���s���[�^���g���ē��v�������邱�Ƃ��n�߂悤�B���̂��߂ɁA���̏͂ł͂܂����v�p�b�P�[�WSAS�̊�{�I�Ȏg�������A�ŏ��ɂ��ׂ���{�I���v�����ł���P���W�v���ɐ������Ă������Ƃɂ���B

�@SAS�̓f�[�^�ɑ��āA���v�����E���Z�������n�߂Ƃ���e��̉��H�������s���p�b�P�[�W�E�v���O�����ł���B��������ꂪ�e��̓��v�����p�ɂ��ꂼ��̃v���O�����������ō쐬�E�J���E�ێ����悤�Ƃ���ƁA����͔��ɑ�ςȍ�ƂƂȂ�B���̓_SAS�́A���Ɋ�������Ă��铝�v�p�v���O�����̏W���́A�V�X�e���ł���A���p�҂��K�v�ȃv���O�������w�肷��ƁA�������@�\�I�Ƀf�[�^�Ɍ��ѕt���āA���v���������Ă����̂ł���B

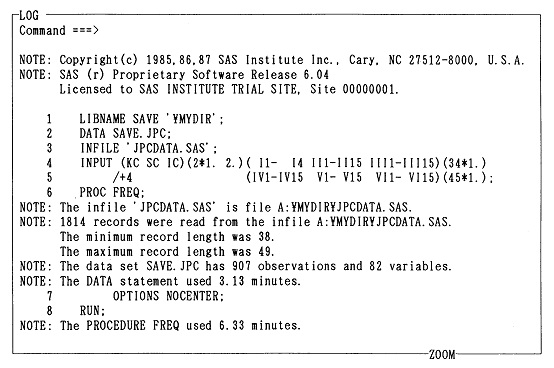

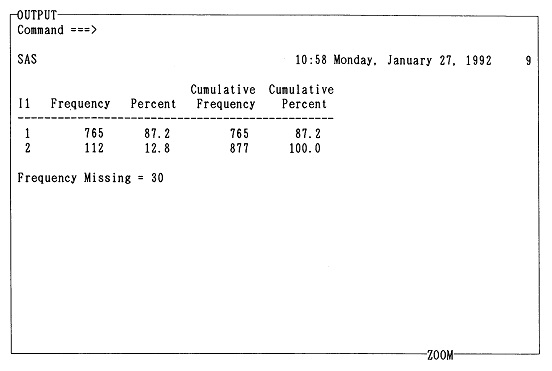

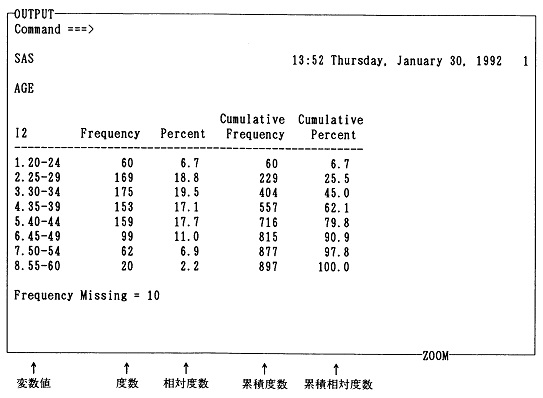

�@���̏͂ł́A�ŐV�łł���SAS��6�ł̎g�����ƃv���O���~���O��SAS��R���s���[�^��S���m��Ȃ��ǎ҂ł������ł���悤�ɉ�����邱�Ƃɂ��悤�B�������A�P�Ȃ�SAS����ł͂Ȃ��A�u�g�D�������̂��߂̏]�ƈ��ӎ������v�̃v���Z�X��1�X�e�b�v�Ƃ��āA�����ɂ���ē���ꂽ�f�[�^��P���W�v���A��̏͂ł̓��v���͂̂��߂Ƀf�[�^���f�[�^�E�x�[�X�����Ă����̂��A���̖̏͂{���̖����ł���B

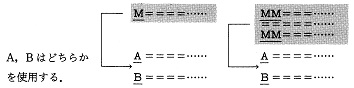

�@�{���ł̓p�[�\�i���E�R���s���[�^��SAS�A������PC��SAS�ƃ��C���t���[��(mainframe)��SAS�̗����ɂ��āA����Η��������I�ɑ���_�Ȃǂɂ����y���Ȃ���������Ă����B����́A����M�҂��܂߂đ����̐l���ASAS���g���ہA�������Ԃ�R�X�g�A���p�\�������l��������ŁA�p�[�\�i���E�R���s���[�^�ƃ��C���t���[�����g�������A�����v���O�����A�f�[�^���t���b�s�B�E�f�B�X�N1���ňڐA���A�ǂ���̋@�B�ł��g�����ƂɂȂ��Ă����ƍl���邩��ł���B�Ƃ͂������̂́A�ǂ��炩�Ƃ����APC��SAS�𒆐S�ɂ��āA���̎g�����𑀍�̏����ɂ��������Đ�������B����̓I�ɂ́AMS-DOS�𓋍ڂ����p�[�\�i���E�R���s���[�^�ɁA����SAS�̑�6��(�����[�X6.04)���C���X�g�[������Ă��邱�Ƃ�O��ɂ��āA�b��i�߂邱�Ƃɂ��悤�B

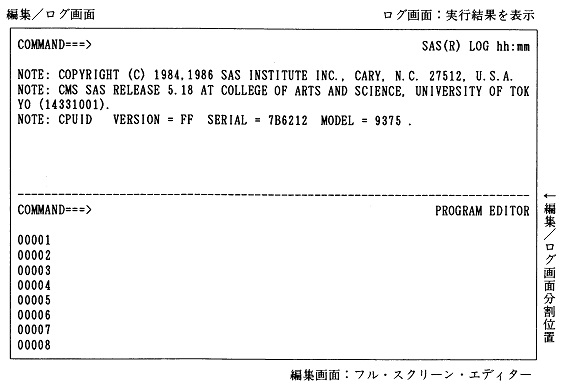

�@���C���t���[�����p�҂ɑ��ẮASAS��6�ł�IBM�y��IBM�݊��̍��Y�̃��C���t���[���ł����p�\�Ȃ̂ŁA���C���t���[����SAS�Ƃ���IBM���C���t���[���̑�\�I��OS�ł���CMS�ɑΉ����Ă���CMS��SAS (SAS�����[�X6.06)�ɂ��Ă��APC��SAS�Ƃ̑���_�Ȃǂ��w�E���Ȃ��畹���Đ������Ă����B�܂��A���݂ł��A���C���t���[���̈ꕔ�ł́ACMS��SAS�����[�X5.18�����̂܂g�p����Ă���悤�Ȃ̂ŁA�t����݂��ACMS��SAS�����[�X5.18�̊�{�I�Ȏg�p���@�ɂ��āA��6�łƂ̈Ⴂ���T�����Ă������B

�@�����Ƃ��ASAS��6�łł́A���C���t���[���p���p�[�\�i���E�R���s���[�^�p���Ƃ���C����ŏ�����A�g�p���@�͊�{�I�ɓ����ł���B�t�@�C�����̌`���Ɖ�ʂ̃E�B���h�E�̐����قȂ邱�Ƃɒ��ӂ���APC��SAS��CMS��SAS�����l�Ɏg�p���邱�Ƃ��ł���B�������ACMS��SAS�́A���̃��C���t���[���pSAS�Ɣ�r���Ă��A�n�[�h�E�F�A��\�t�g�E�F�A�ɂ��Ă̗]�v�Ȓm����z����K�v�Ƃ��Ȃ��Ƃ����_�ł́A�p�[�\�i���E�R���s���[�^���̎g���₷�����������V�X�e���ł���B�Ⴆ�A�ʏ�A���C���t���[���ł�SAS�̂悤�ȃp�b�P�[�W�E�\�t�g�ł����Ă��A���ۂɓ����悤�ɂ��邽�߂ɂ́A�n�[�h�E�F�A�̎d�l�A�\�t�g�E�F�A�̎d�l�A����ɓ��������Ƃ��Ă���v���O�����̎d�l��f�[�^�̃T�C�Y�Ȃǂ��z��������ŁA���܂��܂Ȋ��ݒ���s���K�v������B���̐ݒ���s���̂�JCL (job control language�A�u�W���u�R���v�ƌ������Ƃ�����)�ƌĂ����̂ł��邪�A���̂悤�ɁA�\�t�g�̎g�p�ɍۂ��āA���p�҂���������Y�܂���Ă���JCL�ɂ��Ă��ACMS��SAS�ł͈�؋C�ɂ���K�v�͂Ȃ��BCMS�ł́A���O�I������PROFILE�Ƃ������O�̏����ݒ�t�@�C���������I�ɋN������A���p�҂̊��ݒ肪�����I�ɍs���Ă��܂��̂ł���B

�@����ł́APC��SAS���g�p�����ŕK�v�ɂȂ�ŏ�����MS-DOS�̊�b�m���ɂ��Ă̐�������n�߂邱�Ƃɂ��悤�BIBM���C���t���[����CMS�ɂ��ẮA�t�����Q�Ƃ��Ăق����BCMS��SAS�̗��p�҂́A���̑�2�߂̑���ɁA�����t����ǂ�ł���A��3���ɐi�ނ��ƁB���C���t���[����CMS�ȊO��OS�Ŏg�p����ꍇ�ɂ́A�Z���^�[���ɖ₢���킹�āASAS���p�ɂǂ̂悤��JCL���K�v�ɂȂ�̂������炩���ߊm�F���Ăق����B

�@OS (Operating System)�Ƃ́A�ȒP�Ɍ����A�O���L�����u����o�͑��u�Ƃ������n�[�h�E�F�A�𑀍삷��\�t�g�E�F�A�̂��Ƃł���B���p�ҁA���邢�͗��p�҂����ڐG��鍂������(�Ⴆ��C����)�A�p�b�P�[�W(�Ⴆ��SAS)��OS�̎g���������Ă���A�O���L�����u����o�͑��u�Ƃ������n�[�h�E�F�A���I�ɒ��ڑ��삷��K�v�͂Ȃ��AOS�Ƃ����\�t�g�E�F�A��̘_���I���u(logical device)�̊ȒP�ȑ�������邾���ŁA���ۂ̊O���L�����u����o�͑��u�̕��G�ȑ����OS������ɂ���Ă����B

�@������X�����G�ȃR���s���[�^�E�V�X�e���̑S�̂��\�����邻�ꂼ��̊O���L�����u����o�͑��u�Ƃ������n�[�h�E�F�A���I�ɒ��ڑ��삵�悤�Ƃ���Ȃ�A�e���u�̋@�B�I�Ȏd�g�݂⌴���𗝉����A�Ȃ����ǂ̂悤�ɑ��삷��̂������Ƃ������I�ŊԈႢ���Ȃ��̂����K�����Ă����Ȃ��Ă͂Ȃ�Ȃ��B�l���������ŋC�̉����Ȃ�悤�Șb�ł���B�p�[�\�i���E�R���s���[�^�ł���AMS-DOS�̂悤��OS�Ȃ��Ńn�[�h�E�F�A���I�ɒ��ڑ��삷�邱�Ƃ͕s�\�ł���B���ꂾ��OS�͕֗��ł���A���R���s���[�^�E�V�X�e���̎g������A���p���������߂�Ƃ����_�Ō���I�ɏd�v�Ȃ��̂ł���B

�@�����ł����ł́A�p�[�\�i���E�R���s���[�^�̃n�[�h�E�F�A�ɂ��Ă͐G�ꂸ�AOS�ł���MS-DOS�ɂ��āASAS���p�̂��߂ɍŏ����K�v�Ȃ��Ƃ���ɂ��Đ������Ă������B

�@�t�@�C��(file)�܂��̓f�[�^�E�Z�b�g(data set)�Ƃ́A�����I�ɂ̓R���s���[�^�E�V�X�e���̌Œ�f�B�X�N��t���b�s�B�E�f�B�X�N�Ɋi�[���ꂽ�v���O������f�[�^�̏W���̂��Ƃł���B����̓I�ɂ́A�p�[�\�i���E�R���s���[�^��C���t���[���̒[���̃f�B�X�v���C��ʂ̏�ɓ��́A�\�����ꂽ�s�̏W�����f�B�X�N�Ɋi�[�������̂��t�@�C���ł���B�f�B�X�N�ɕۑ����ꂽ���́A���̃t�@�C���Ƃ����P�ʂŊǗ������B(�ڍׂ��t�͑�1�����Q�Ƃ��ꂽ���B)

�@�t�@�C���ɂ͂��ꂼ�ꖼ�O���t�����A���̃t�@�C���Ǝ��ʂ����BMS-DOS�̃t�@�C�����́A�Ⴆ�Ύ��̂悤�Ȍ`�����Ă���B

�@�@�@FRQ.LOG

�@�@�@JPCDATA.SAS

�t�@�C�����́A��ʓI�ɂ�

�@�@�@�t�@�C�����{��.�t�@�C�����g���q

�Ƃ����`�����Ƃ��Ă���B�t�@�C�����̖{�̂Ɗg���q�̊Ԃɂ͕K���s���I�h "." �����ނ��ƂɂȂ��Ă���BMS-DOS�̃t�@�C�����̊g���q�͕K���t���Ȃ��Ă͂Ȃ�Ȃ��Ƃ������̂ł͂Ȃ����A�t�@�C���̓��e�̕��ނ̂��߂ɂ͕t���Ă����ƕ֗��ł���B�g���q��t���Ȃ��ꍇ�ɂ̓s���I�h "." �͕t���Ȃ��B

�@�t�@�C�����̋�̓I�ȕ\�L���@�Ƃ��ẮA�t�@�C�����{�̂�8�����ȓ��A�g���q��3�����ȓ��ƂȂ��Ă���A�p����A�`Z�A0�`9�A�����$�A#�A@�A-(�n�C�t��)�A_(����)�̋L���ނ���Ȃ镶����ł���B���̂ق��ɂ��g����L�������邵�A�Ђ炩�ȁA�J�^�J�i�A�������g���邱�ƂɂȂ��Ă��邪�A���C���t���[���Ŏg�p����ꍇ�����邱�Ƃ��l����ƁA�g���u���̌����ɂȂ�̂ŁA���܂芩�߂��Ȃ��B���̈Ӗ��ł́A�t�@�C������1�����ڂ͉p���ɂ��Ă�������������ł��낤�B�܂��A�p���ɑ啶���A�������̋�ʂ͂Ȃ��AMS-DOS�ł́A���ׂđ啶���ɕϊ�����ď��������B

�@�V���Ƀt�@�C���������ꍇ�ɁA�����A���ɑ��݂��Ă���t�@�C���Ɠ����t�@�C������t���悤�Ƃ���ƁA�����炠��t�@�C���̓��e������ꂽ��A�G���[���o���肷�邱�ƂɂȂ�̂ŁA���ӂ��K�v�ł���B

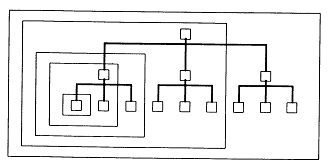

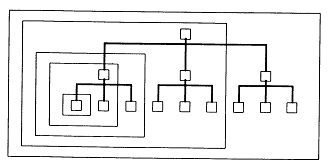

�@�Œ�f�B�X�N����ւ��\�ȃt���b�s�B�E�f�B�X�N�Ƃ������u1���v�̃f�B�X�N�̒��ɂ́A�����̃t�@�C�����i�[���邱�Ƃ��ł���B�����ŁAMS-DOS�ł̓f�B�X�N�̒��̂ǂ��ɂǂ�ȃt�@�C�����i�[����Ă��邩�A�f�B���N�g��(directory=�Z���^)������ĊǗ����Ă���B�������A�ڂ����u�Z���v��MS-DOS�̃V�X�e���ɂƂ��Ă͕K�v�ȏ���A���p�҂ɂƂ��Ă͕K�v�Ȃ��̂ŁA���p�҂ɂ͕\������Ȃ��B���̃f�B���N�g���̒��ɂ́A�t�@�C�������ł͂Ȃ��A�ʂ̃f�B���N�g��������邱�Ƃ��ł���B���̃f�B���N�g����e�Ƃ���A���̈ꗗ�\�̒��ɕ\�L����q�̊W�ɂ���f�B���N�g�����T�u�f�B���N�g���ƌĂԁB���̃T�u�f�B���N�g�������ꎩ�̂��e�f�B���N�g���ƂȂ��āA�T�u�f�B���N�g���������Ƃ��ł���B���̂悤�ɂ��āA���傤�ljƌn�}�̂悤�ɊK�w�f�B���N�g���\�����`�������̂ł���B�܂�A�����̃f�B���N�g�����A���ꂼ�ꑼ�̃f�B���N�g���Ƃ̐e�q�W�������1���̉ƌn�}�Ɏ��܂邱�ƂŁu1���́v�f�B�X�N��ɑ��݂�����킯�ł���B

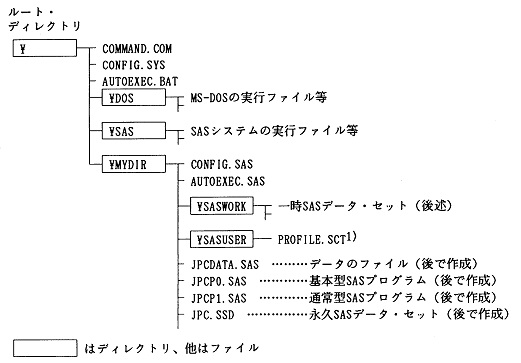

�@�Ⴆ�A�{���ł�SAS�́w�����y�щ^�p�ƕێ�̎�����x�ʂ�̃f�B���N�g���\����O��ɂ��Ă��邪�A���̍\���͐}2.1�̂悤�ɂȂ�B�Œ�f�B�X�N(�h���C�uA)�̓��e��SAS�̉ғ��ɕK�v�ȍŏ����̃t�@�C���\���ɂȂ��Ă���BSAS�́w�����y�щ^�p�ƕێ�̎�����x�ɂ��������āASAS�̎��s�t�@�C���Ȃǂ�[�߂�SAS�f�B���N�g�����烆�[�U�[�E�v���O�����A�f�[�^�Ȃǂ�[�߂��f�B���N�g������ʁA�������āA�u��MYDIR�v�Ƃ������p�f�B���N�g�����쐬���Ă���B����́ASAS�̃o�[�W�����A�b�v�̍ۂ̍�Ƃ��y�ɂ��A�����̐l�������Œ�f�B�X�N���g�p����ۂɓƗ������m�ۂ��邱�ƂȂǂ�ړI�ɂ��Ă���B

�}2.1 �Œ�f�B�X�N�̃f�B���N�g���̍\���}

1) �f�B�X�v���C�E�}�l�[�W��(��q)�̊e��ݒ�ۑ��t�@�C�������A�{���ł͏o���̐ݒ��O��ɂ��Ă���̂ŁA����ȏ�G��Ȃ��B

�@�������A���p�҂���x�Ɏg�p�ł���f�B���N�g���͈�ƌ��߂��Ă���B���ݎg�p���̃f�B���N�g�����J�����g�E�f�B���N�g���ƌĂԂ��A���݂ǂ̃f�B���N�g�����g�p���Ă���̂��A�J�����g�E�f�B���N�g�����m���߂�ɂ́Achdir�R�}���h���g���悢�B

�@�@�@A>ChDir

�Ɠ��͂���ƁA�J�����g�E�f�B���N�g�����\�������B�Ⴆ�A�\����

�@�@�@A:��

�Ȃ�A���[�g�E�f�B���N�g�����J�����g�E�f�B���N�g���ł���A�����\����

�@�@�@A:��MYDIR

�Ȃ�AMYDIR���J�����g�E�f�B���N�g���ł���B

�@�J�����g�E�f�B���N�g���͕ύX���邱�Ƃ��ł���B�J�����g�E�f�B���N�g������1�K�w��̐e�f�B���N�g���ɃJ�����g�E�f�B���N�g����ς���Ƃ��ɂ́A��͂�chdir�R�}���h���g���A���̂悤�ɓ��͂���B

�@�@�@A>ChDir ..

�t�ɁA�J�����g�E�f�B���N�g���̃T�u�f�B���N�g���̈�ɃJ�����g�E�f�B���N�g����ς���Ƃ��ɂ́A

�@�@�@A>ChDir �T�u�f�B���N�g����

�Ɠ��͂���悢�B�Ⴆ�A���܃��[�g�E�f�B���N�g�����g�p���Ă���Ƃ���ƁA

�@�@�@A>ChDir MYDIR

�Ɠ��͂���ƁA�T�u�f�B���N�g��MYDIR�Ɉڂ邱�Ƃ��ł���B

�@�J�����g�E�f�B���N�g���̒��ɁA�ǂ�ȃt�@�C����T�u�f�B���N�g�������݂��Ă��邩�A���̈ꗗ�\��\��������Ƃ��ɂ́A

�@�@�@A>DIR

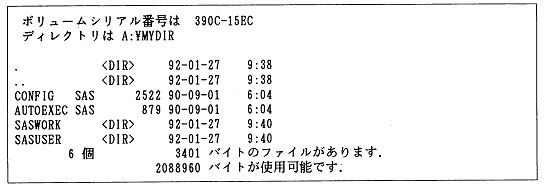

�Ɠ��͂���悢�B����ƃJ�����g�E�f�B���N�g����MYDIR�̂Ƃ��́ASAS�C���X�g�[������ł́A�{�͂̒��ł��ꂩ��쐬����SAS�v���O�������͂܂����݂��Ȃ��̂ŁA�Ⴆ�ΐ}2.2�̂悤�ɂȂ�B

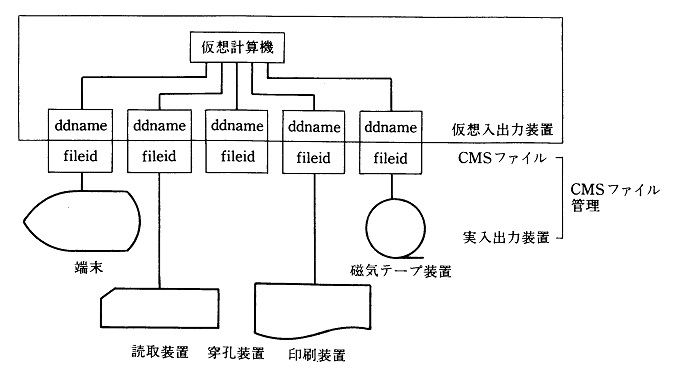

�}2.2 MYDIR�̃f�B���N�g����ʂ̗�(SAS�C���X�g�[������)

�@����(3)�ōs���Ă���悤�ȃL�[�{�[�h����̃R�}���h���͂̐����̍ۂɂ́A�{���ł͎��̂悤�ȕ\�L���@���Ƃ��Ă���B�����ǂ�ŁA������x(3)���������Ă݂�Ƃ悢�B

�@SAS�N���̎d���́APC��SAS��CMS��SAS����{�I�ɓ����ł���BMS-DOS���邢��CMS�̃R�}���h����͂ł��郂�[�h����ASAS �ƃR�}���h���͂̌`�œ��͂��Ă��悢�̂ł���B�������A����͕W���I�ɃC���X�g�[�������ꍇ�ł���ASAS�̃C���X�g�[���̎d��������Ă���A�������N���̎d�������R����Ă���B���Ƀ��C���t���[���ł́A�Ǘ����Ă���Z���^�[���Ƃɂ��Ȃ��������̂ŁA�z�X�g�v�Z�@�̊Ǘ��҂ɕK���m�F���邱�ƁB���́ASAS�̎g�p���@�̂����A�n�[�h�E�F�A�A�\�t�g�E�F�A�A�Ǘ��^�c�V�X�e���ō��ق��o��̂́A����SAS�N���̕��������ł���BSAS����U�N�����Ă��܂���������A��������������Ƃ͈�؊W�Ȃ��A�ǂ̓�����ł������g�p���@��SAS���g�����Ƃ��ł���B�����ł�PC��SAS��W���I�ɃC���X�g�[�������ꍇ�̋N���̕��@���\��Ƃ��Đ������Ă������B

�@����ł́A��������SAS���N�����Ă݂邱�Ƃɂ��悤�B�܂��p�[�\�i���E�R���s���[�^�̓d���X�C�b�`�ł���POWER�X�C�b�`�����āAMS-DOS���N��������B�n�[�h�E�f�B�X�N�E�h���C�u��A�ł���Ƃ��A�v�����v�g���uA>�v�ƂȂ��Ă��邱�ƁA�����āA���p�f�B���N�g��MYDIR���J�����g�E�f�B���N�g���ɂȂ��Ă��邱�Ƃ��m�F������ŁA

�@�@�@A>SAS

�@

�Ɠ��͂����SAS���N�������B

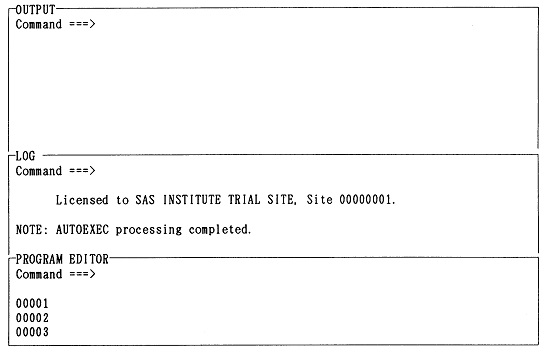

�@SAS�̋N���ɂ���āA�v���O�����쐬�A���s�̂��߂�SAS�f�B�X�v���C�E�}�l�[�W���E�V�X�e��(SAS Display Manager System)�̉�ʂ��\������邱�ƂɂȂ�B���̉�ʂ́APC��SAS�ł͐}2.3�̂悤�ɂȂ�B

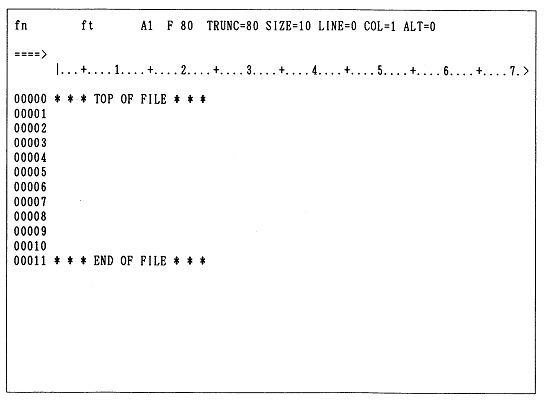

�}2.3 PC��SAS�̃f�B�X�v���C�E�}�l�[�W���E�V�X�e���̉��(SAS�N����)

�@PC��SAS�̃f�B�X�v���C�E�}�l�[�W���E�V�X�e���̉�ʂ͐}2.3�����Ă킩��悤��3�̃E�B���h�E�ɕ�������Ă���B�e�E�B���h�E�̖��̂Ɩ����́ASAS�v���O�����̕ҏW�A���s�̎菇�ɂ��������A�����珇���A

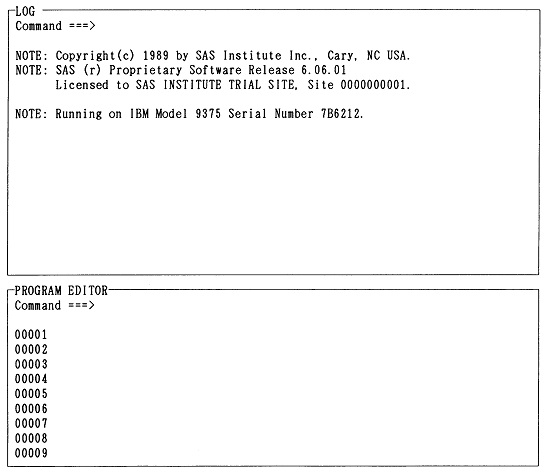

�@CMS��SAS�̃f�B�X�v���C�E�}�l�[�W���E�V�X�e���̉�ʂ͐}2.4�Ɏ�����Ă��邪�APC��SAS�ƈقȂ�A��̃E�B���h�E�ɕ�������Ă���BOUTPUT�E�B���h�E��SAS�N�����ɂ͕\������Ȃ��B�����Ƃ��ASAS�N�����ɂ�OUTPUT�E�B���h�E�͕\�����ׂ����e���Ȃ����A�g���p�����Ȃ��̂ŁA���̂��Ƃŕs�ւ͂Ȃ��B

�}2.4�@CMS��SAS�̃f�B�X�v���C�E�}�l�[�W���E�V�X�e���̉��(SAS�N����)

�@PC��SAS�ł���ACMS��SAS�ł���ASAS�̃f�B�X�v���C�E�}�l�[�W���E�V�X�e���̉�ʂ̃t�@���N�V�����E�L�[�ɂ́A���p�҂���r�I�悭�g�p����R�}���h���ݒ肳��Ă���B�t�@���N�V�����E�L�[�ɐݒ肳��Ă���R�}���h�́A�悭�g���R�}���h�Ȃ̂ŁA�R�}���h�Ƃ��Ă��A���̋@�\���悭�������Ă������B�t�@���N�V�����E�L�[�̐ݒ�͗��p�҂̎�ŕς��邱�Ƃ��ł��邪�A�\2.1��PC��SAS�ł̏o���̐ݒ�ł���B���̏͂ł́A�\2.1�̐ݒ��O��ɂ��Ęb��i�߂�B

�\2.1�@�f�B�X�v���C�E�}�l�[�W���E�V�X�e���̉�ʂ̃t�@���N�V�����E�L�[(PC��SAS�o��)

| �@�L�[�@ | �ݒ� �R�}���h | �@�\ |

|---|---|---|

| (f�1) | help | �R�}���h�A�@�\�ɂ��Đ�������HELP�E�B���h�E��\�����A���̃��C���E���j���[��\������B |

| (f�2) | keys | �t�@���N�V�����E�L�[�̐ݒ������KEYS�E�B���h�E��\������B |

| (f�3) | log | LOG�E�B���h�E��\������B���ɕ\������Ă���ꍇ�ɂ́A�J�[�\����LOG�E�B���h�E�Ɉړ�����B |

| (f�4) | output | OUTPUT�E�B���h�E��\������B���ɕ\������Ă���ꍇ�ɂ́A�J�[�\����OUTPUT�E�B���h�E�Ɉړ�����B |

| (f�5) | next | �E�B���h�E�����ԂɃJ�[�\�����ړ�����B |

| (f�6) | prg | PROGRAM EDITOR�E�B���h�E��\������B���ɕ\������Ă���ꍇ�ɂ́A�J�[�\����PROGRAM EDITOR�E�B���h�E�Ɉړ�����B |

| (f�7) | zoom | �J�[�\���̂���E�B���h�E��������ʈ�t�ɕ\������Y�[���E���[�h�ɂ��邩�A�ʏ�̃}���`�E�E�B���h�E�E���[�h�ɂ��邩���ւ���B |

| (f�8) | subtop | PROGRAM EDITOR�E�B���h�E�̑�P�s��SAS�����������s������B���̂��Ƃł��̑�1�s�͏����A��2�s�ȍ~��1�s���J��オ�邱�ƂɂȂ�B |

| (f�9) | recall | PROGRAM EDITOR�E�B���h�E�ɃJ�[�\��������Ƃ��ɗL���ŁA���O�Ɏ��s�����v���O������PROGRAM EDITOR�E�B���h�E��ɌĂяo���B����PROGRAM EDITOR�E�B���h�E�ɓ��e������Ƃ��ɂ́A���̓��e�̎n�߂ɑ}�������Brecall������Ɏ��s����ƁA�O�X��A�O�X�X��A�c�c�Ǝ��X�Ƒk���Ďn�߂ɑ}�������B |

| (f�10) | zoom off; submit | �}���`�E�E�B���h�E��Ԃɂ��Ă���APROGRAM EDITOR�E�B���h�E��̃v���O���������s����B |

�@�܂��A�e�E�B���h�E�ł́A�\2.2�̂悤�ȕҏW�L�[�����̂܂g����B

�\2.2�@�ҏW�L�[(PC��SAS)

| �L�[ | �@�\ |

|---|---|

| (INS) | �}�����[�h�Əd�������[�h���ւ���B�}�����[�h�̂Ƃ��́A��ʉE���[�� "I" �̕������\�������B |

| (DEL) | �J�[�\����̕������폜����B |

| (BS) | �J�[�\���̂P���O�̕������폜����B |

| (ROLL UP) | ��ʂ�����ɃX�N���[�����A����ʂ̓��e��\������B |

| (ROLL DOWN) | ��ʂ������ɃX�N���[�����A�O��ʂ̓��e��\������B |

| (CAPS) | �A���t�@�x�b�g�̑啶�����̓��[�h�Ə��������̓��[�h���ւ���B�啶�����̓��[�h�̂Ƃ��́A��ʉE���[��"C"�̕������\�������B |

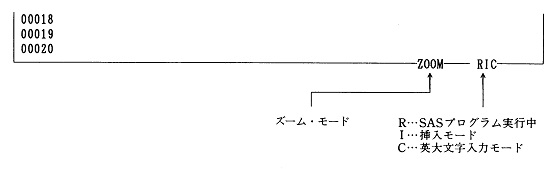

�@�Y�[���E���[�h�A�}�����[�h�A�p�啶�����̓��[�h�Ƃ������A���ꂼ��Ή�����L�[�ɂ���ăX�C�b�`�̂悤��on/off���J��Ԃ����̂ɂ��ẮA�f�B�X�v���C�E�}�l�[�W���E�V�X�e����ʂ̉E���[�̃E�B���h�E�̘g��ɁA�}2.5�̂悤�ɁA���݂̃��[�h�̏�Ԃ��\�������B�����\������Ă��Ȃ��Ƃ��ɂ́A������̏�Ԃł��Ȃ��Ƃ������Ƃ��Ӗ����邱�ƂɂȂ�B

�}2.5�@SAS�̏�ԕ\��(�f�B�X�v���C�E�}�l�[�W���E�V�X�e����ʂ̉E���[�ɕ\��)

�@�t�@���N�V�����E�L�[�̐ݒ�͒ʏ�͉�ʂɂ͕\������Ȃ��̂ŁA�悭�g�p������̂ɂ��Ă͊o���Ă����Ε֗��ł���B���R�͂悭�킩��Ȃ����ACMS��SAS�ł́A�����z�X�g�v�Z�@�ɐڑ����ꂽ�[���ł��A�Ⴆ�A��p�[���ƃp�\�R���[���̂悤�ɁA�[���̋@��ɂ���ďo���̐ݒ���قȂ��Ă���悤�Ȃ̂ŁACMS��SAS�̃t�@���N�V�����E�L�[�̐ݒ�́A�����ňꗗ�\�ɂ��邱�Ƃ͂��Ȃ��B�g�p����ۂɁA�����ł܂�Command�s��

�@�@�@Command ===> KEYS

�Ɠ��͂��āA�m�F���Ă݂邱�ƁB���Ȃ��Ƃ��A�\2.1�ɂ���R�}���h�ɑΉ�����t�@���N�V�����E�L�[�ɂ��ẮA�g���n�߂̂Ƃ��Ɏ����Ń`�F�b�N���Ă������B���ɏd�v�Ȃ̂́ACMS��SAS�ł́A�ҏW�L�[��(ROLL UP)�L�[�A(ROLL DOWN)�L�[���g���Ȃ��̂ŁA�����̕ҏW�L�[�Ɠ����@�\���ʂ���forward�R�}���h�Abackward�R�}���h�̐ݒ肳��Ă���t�@���N�V�����E�L�[��T���Ċm�F���Ă������Ƃł���B

�@PC��SAS�ł́A(f�2)�L�[��keys�R�}���h���ݒ肳��Ă���̂ŁA�킴�킴Command�s�ɓ��͂��Ȃ��Ă��A(f�2)�L�[(=keys)�������悢�B�����ɁA(f�2)�L�[�������Ă݂āAKEYS�E�B���h�E���\�������̂��m�F���Ă݂悤�BKEYS�E�B���h�E����邽�߂ɂ́AKEYS�E�B���h�E��Command�s��

�@�@�@Command ===> END

�Ɠ��͂���悢�BHELP�E�B���h�E�ɂ��Ă����l�ɁAend�R�}���h�ɂ���ăE�B���h�E����邱�Ƃ��ł���̂ŁA(f�1)�L�[(=help)�������Ă݂āAHELP�E�B���h�E��\�������Ă݂Ă��玎���Ă݂悤�B

�@�J�[�\���E�L�[�ł���(��)(��)(��)(��)�ɂ���āA�J�[�\���̓f�B�X�v���C�E�}�l�[�W���E�V�X�e���̉�ʏ���A�E�B���h�E�̋��E���ɊW�Ȃ����R�Ɉړ������邱�Ƃ��ł��邪�A(f�5)�L�[(=next)���������ƂŁA�E�B���h�E�Ԃ����ԂɃJ�[�\���ړ������邱�Ƃ��ł���B�܂��A(f�3)�L�[(=log)�A(f�4)�L�[(=output)�A(f�6)�L�[(=prg)�ɂ���āA�_�����E�B���h�E�ɁA�ꔭ�ŃJ�[�\�����ړ������邱�Ƃ��ł���̂ŁA�����Ă݂悤�B

�@�����Ƃ��A���ۂɂ́ASAS�v���O���������n�߂�Ƃ��́APROGRAM EDITOR�E�B���h�E�����g��Ȃ��̂ŁA(f�7)�L�[(=zoom)���g���āAPROGRAM EDITOR�E�B���h�E��������ʈ�t�ɕ\������Y�[�~���O���s���A�\���L���Ƃ���������Ƃ��₷���B����zoom�R�}���h�͕\2.1�ɂ�����悤�ɁAon/off���J��Ԃ��X�C�b�`�̂悤�ɋ@�\����̂ŁA�ʏ�̃}���`�E�E�B���h�E�E���[�h�̏�Ԃɖ߂��ɂ́A������x(f�7)�L�[(=zoom)�������悢�B

�@�e�E�B���h�E�̓��e�́ASAS�v���O�����ł��A�f�[�^�ł��A�o�͌��ʂł��A�����ă��O�ł��A����������l�ɁA��������炪���݂��Ă���e�E�B���h�E��Command�s��

�@�@�@Command ===> FILE '�t�@�C����'

�Ɠ��͂���A�t�@�C���ɕۑ����邱�Ƃ��ł���B����file�R�}���h���g�p����Ƃ��ɂ́A�t�@�C�����͕K���A'�@'�ň͂ނ悤�ɂ���B

�@PC��SAS�ł́AMS-DOS�̃t�@�C������

�@�@�@[�h���C�u��:][���p�X����]�t�@�C����[.�g���q]

�̂悤�Ɏw�肳���B�����Ńp�X���Ƃ́A���[�g�E�f�B���N�g������ړI�̃f�B���N�g���ɒB����܂ł̃f�B���N�g���̓���(�p�X)���������߂ɁA�e�f�B���N�g���������ŋ���ĕ��ׂĕ\�������̂ł���B�Ⴆ�A���̂悤�ɂł���B

�@�@�@Command ===> FILE '��MYDIR��JPCDATA.SAS'

�����Ƃ��A�J�����g�E�f�B���N�g����MYDIR�ł���A���̗�ɂ���悤�ȃp�X���͏ȗ����邱�Ƃ��ł��āA

�@�@�@Command ===> FILE 'JPCDATA.SAS'

�Ɠ��͂��������ł��A���l�Ƀf�B���N�g��MYDIR�̂��Ƃɕۑ������B����

�@�@�@Command ===> FILE 'B:JPCDATA.SAS'

�Ƃ���ƁA�����w�肷�邾���ŁA�h���C�uB�ɂȂ��Ă���t���b�s�B�E�f�B�X�N�ɂ��t�@�C�����ۑ��ł���̂ŁA�v���O������f�[�^�̕ۑ���ڐA�A�o�͂̕ۑ��Ȃǂɂ͔��ɕ֗��ł���B

�@MS-DOS�̃t�@�C�����̊g���q�͕K���t���Ȃ��Ă͂Ȃ�Ȃ��Ƃ������̂ł͂Ȃ����A�t�@�C���̓��e�̕��ނ̂��߂ɁA�M�҂�PROGRAM EDITOR�E�B���h�E����ۑ������v���O������f�[�^�ɂ�SAS�ALOG�E�B���h�E����ۑ��������O�ɂ�LOG�AOUTPUT�E�B���h�E����ۑ������o�͌��ʂɂ�LST�Ƃ����t�@�C�����g���q��t���邱�Ƃɂ��Ă���B�g���q���g�����Ƃ��A�Ⴆ��JPC�AJPC.SAS�AJPC.LOG�AJPC.LST�͂��ꂼ��܂������ʂ̃t�@�C�����Ӗ����邱�ƂɂȂ�B

�@CMS��SAS�ł��A�t�@�C�����̌`�����قȂ邾���ŁAPC��SAS�Ƃ܂��������l�ɁA�e�E�B���h�E�̓��e�́A����炪���݂��Ă���e�E�B���h�E��Command�s��file�R�}���h��CMS�̃t�@�C������

�@�@�@Command ===> FILE 'fn ft [fm]'

�Ɠ��͂���ACMS�t�@�C���ɕۑ����邱�Ƃ��ł���B�t�@�C���E���[�hfm�͏ȗ������A������l�ƂȂ��Ă���B

�@�������ɓ����t�@�C����fn ft��CMS�t�@�C�������݂��Ă���ꍇ�ɂ́A����file�R�}���h�̎��s�ɂƂ��Ȃ��A

�@�@�@WARNING: The file already exists. Enter R to replace it, enter A to append to it or enter C to cancel FILE command.

�ƕ����Ă���̂ŁACMS�t�@�C���̓��e���X�V����ꍇ�ɂ�R�A�t������ꍇ�ɂ�A�Afile�R�}���h�����~�߂�ꍇ�ɂ�C����͂��Ă���(���s)�L�[�������B

�@�Ƃ���ŁA���������v���O�����A���O�A�o�͓��e�́A�]���́u�펯�v���炷��ƁA�K�����̏�Ƀv�����g�E�A�E�g���A�n�[�h�E�R�s�[�Ƃ��ĂƂ��Ă������ƂɂȂ�B���ہAPC��SAS�ł́A�e�E�B���h�E��file�R�}���h��p���A���������t�@�C����'PRN'��MS-DOS�t�@�C���ɏo�͂���悤�ɁA

�@�@�@Command ===> FILE 'PRN'

�Ɠ��͂���ƃv�����^�ɏo�͂��A����ł��邱�ƂɂȂ��Ă���B(�������A����ɂ̓v�����^�̐ݒ肪�K�ɍs���Ă���K�v������̂ŁA���ӂ�v����B) �������A����̓��[�h�E�v���Z�b�T�[�̃p�\�R���E�\�t�g��[�v����p�@�����ꂾ�����y���������ɂ����ẮA�قƂ�Ǘp���̖��ʌ����ɂ����Ȃ��B���������o�͓��e�́A�����Ȃ莆�̏�Ɉ�������ɁAfile�R�}���h�ɂ���āAMS-DOS�t�@�C���Ƃ��ČŒ�f�B�X�N��t���b�s�B�E�f�B�X�N�ɏ����o���A���̏�ŁA����MS-DOS�t�@�C�����g�����ꂽ���[�h�E�v���Z�b�T�[�ɂ���ĕҏW���A�K�v�Ȃ��̂������������K��������ׂ��ł��낤�B

�@����MS-DOS�t�@�C����CMS�t�@�C���Ƃ��ĕۑ����Ă�����SAS�v���O������f�[�^�́APROGRAM EDITOR�E�B���h�E�Ɍ����Ă͓ǂݍ��ނ��Ƃ��ł���B���̏ꍇ�ɂ́AMS-DOS�t�@�C����CMS�t�@�C���ɕۑ����Ă�����SAS�v���O�����̃t�@�C������PROGRAM EDITOR�E�B���h�E��Command�s��

�@�@�@Command ===> INClude '�t�@�C����'

�Ɠ��͂��āA��ʏ�ɓǂݍ��߂悢�B�����Ƃ��A�ǂݍ�����Ƃ����Ă��A����MS-DOS�t�@�C����CMS�t�@�C����������킯�ł͂Ȃ��B����Ή�ʏ�ɃR�s�[���Ă���킯�ł���BSAS�v���O���������ł͂Ȃ��A������t�@�C�����ǂݍ��݉\�ł���B���������āASAS�v���O�����͂������f�[�^�̃t�@�C���̕ҏW�A�ύX��PROGRAM EDITOR�E�B���h�E���g����B����ɂ͑��̃t�@�C���̃G�f�B�^�[�Ƃ��Ďg�p���邱�Ƃ��\�ł���B������CMS��SAS�ł́A�f�[�^�̃t�@�C����ǂݍ��ނƂ��ɂ́A

�@�@�@WARNING: The file contains sequence numbers. Enter R to remove the sequence numbers or K to keep the sequence numbers.

�ƕ����Ă���̂ŁAK�Ɠ��͂��Ă���(���s)�L�[�������B

�@�Ƃ���ŁAPC��SAS�ł��ACMS��SAS�ł��A����PROGRAM EDITOR�E�B���h�E��ʂɃv���O�����A�f�[�^���̓��e���\������Ă���ꍇ�ɂ́A���̓��e�̍Ō㕔�ɑ����ăt�@�C����ǂݍ��ނ��ƂɂȂ�BPROGRAM EDITOR�E�B���h�E�ɕ\������Ă�����e���������ꂽ��ŁA�S�ʓI�ɐV���ȃt�@�C���ɒu���������čX�V����邱�Ƃɂ͂Ȃ�Ȃ��̂Œ��ӂ��K�v�ł���B�t�@�C�����e�̑S�ʓI�X�V���������Ƃ��ɂ́A��q����clear�R�}���h���g���āA��U�APROGRAM EDITOR�E�B���h�E�̓��e���������Ă����K�v������B

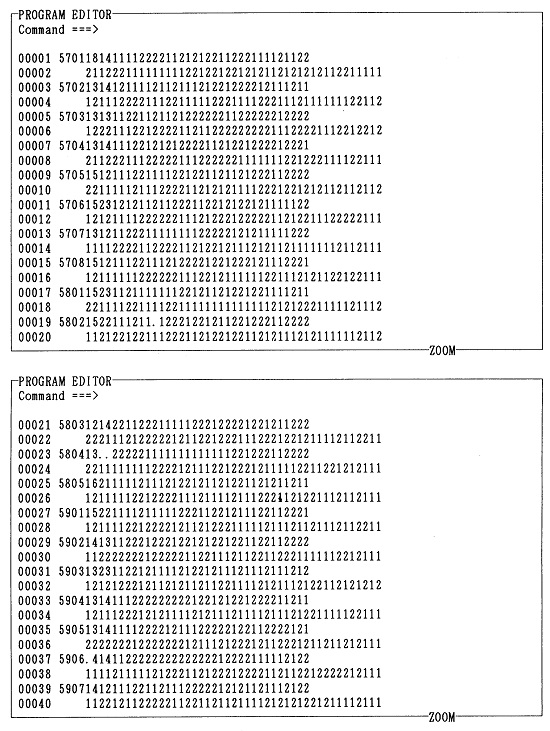

�@�V�K��SAS�v���O�������쐬����ꍇ�ɂ́APROGRAM EDITOR�E�B���h�E�̒��̍s�ԍ��̂��Ă���s�Ȃ�A�ǂ�����ł����R�ɕ�������������ł����悢�B�J�[�\���E�L�[���g��Ȃ��Ă��A���^�[���E�L�[(��)���g���A���s���邱�Ƃ��o����B�������A�s�ԍ��̎���1�����͕ی�t�B�[���h�ƌĂ�A��������͂��悤�Ƃ���Ɓu�s�b�v�ƌx���������āA���͎͂t�����Ȃ��̂Œ��ӂ�����B

�@PROGRAM EDITOR�E�B���h�E�ɕ\������Ă���ŏI�s�܂Ŏg�������ꍇ�ł��A���^�[���E�L�[(��)��������1�s��ɃX�N���[�����āA�V����1�s�\�������̂œ��͂���������B(ROLL DOWN)�L�[�������āA��C�Ɏ��̉�ʂɐi�ނ��Ƃ��ł���B�O�̍s�������蒼�����肵�����Ƃ��ɂ́A(ROLL UP)�L�[�������āA�O�̉�ʂɖ߂��悢�BCMS��SAS�ł́A (ROLL DOWN)�L�[�A(ROLL UP)�L�[���g���Ȃ��̂ŁA�����̃L�[�̑���ɁAforward�R�}���h�Abackward�R�}���h�̐ݒ肳��Ă���t�@���N�V�����E�L�[��p����B

�@SAS��PROGRAM EDITOR�E�B���h�E�̕ҏW�@�\���i��G�f�B�^�[�̓t���E�X�N���[���E�G�f�B�^�[�ƌĂ�A�������܂ꂽ��������ʂ̃C���[�W�ʂ��SAS�v���O�����Ƃ��Ĉ����邱�ƂɂȂ�B(���Ȃ݂ɁA���ꂪ���Ƀt���E�X�N���[���E�G�f�B�^�[�ł͂Ȃ��A���C���E�G�f�B�^�[�ł���A���͂��ύX���������s�́A�R�}���h���͂̂悤�ɁA�e�s�Ń��^�[���E�L�[(��)�������āA�v�Z�@�ɂ��̎|���m�F���Ȃ��Ƃ����Ȃ��B��ʏ�̕ύX�͂����܂ʼn�ʏ�ł݂̂̕ω����Ӗ����A�z�X�g�v�Z�@�̋L�����u��̕ω����Ӗ����Ȃ��̂ŁA�ҏW�͏�ɍs�P�ʂōs��Ȃ���Ȃ�Ȃ��̂ł���B���̓_�A�t���E�X�N���[���E�G�f�B�^�[�͔��ɕ֗��ł���B)

�@PROGRAM EDITOR�E�B���h�E�ł͎��̂悤��SAS�ҏW�R�}���h���g�p�ł���B

�@SAS�ҏW�R�}���h�̂����ł��A�X�N���[���E�R�}���h�̓R�}���h�s�ɓ��͂��Ďg�p����R�}���h�ł���B�����ŁA�X�N���[���E�R�}���h���g�p����ۂɂ̓J�[�\���E�L�[�Ȃǂ��g���āA�J�[�\�����R�}���h�s�Ɉړ������Ă���R�}���h�̓��͂��s���B���邢��PC��SAS�ł́A��̃L�[����

�@�@�@(SHIFT)+(HOME CLR)

�Ɖ����A�ꔭ�ŃJ�[�\�����R�}���h�s�Ɉړ������邱�Ƃ��ł���̂ŕ֗��ł���BCMS��SAS�ł́A����Ɠ����@�\������home�R�}���h��ݒ肵���t�@���N�V�����E�L�[�����ʂ͂���͂��Ȃ̂ŁA�����KEYS�E�B���h�E�ŒT���Ďg���悢�B

�@�t�@���N�V�����E�L�[�Őݒ肳��Ă���R�}���h�����Ƃ��Ƃ̓X�N���[���E�R�}���h�Ȃ̂ŁA�Ⴆ�AHELP�E�B���h�E��\��������ۂɂ́APC��SAS�ł�(f�1)�L�[�������Ă��������A�R�}���h�s��

�@�@�@Command ===> HELP

�Ɠ��͂��Ă������B�@�\�Ƃ��Ă͓������ƂɂȂ�B�t�@���N�V�����E�L�[�Őݒ肳��Ă��Ȃ��X�N���[���E�R�}���h�����邪�A�悭�g�����̂Ƃ��ẮA�Ⴆ�Ύ��̂悤�Ȃ��̂�����B

�@SAS�ҏW�R�}���h�̂����ł��s�R�}���h�ƌĂ��R�}���h�Q�́A����܂ł̃X�N���[���E�R�}���h�Ƃ͈قȂ����g����������B�s�R�}���h�́A�ҏW��ʍ��[�ɕ���ł���5���̍s�ԍ�����(�����=====�Ŏ������Ƃɂ��悤)�ɁA�s�ԍ��̏��(1���ڂ���̕K�v�͂Ȃ�)�d�ˏ�������`�œ��͂��āA���^�[���E�L�[(��)�������A�g�p����R�}���h�ł���B���̂悤�ȃR�}���h�����p�\�ł���B

�@SAS�v���O�������ł�����A(f�10)�L�[(=zoom off; submit)�������āAPROGRAM EDITOR�E�B���h�E��̃v���O������SAS�ɒ�o��(submit)�A���s�����Ă݂�B�������A�������ُ�I�����邱�Ƃ�����̂ŁAsubmit����O��SAS�v���O������MS-DOS�t�@�C���ɕۑ����Ă����Ȃ��ƁASAS�v���O�����͎����Ă��܂����Ƃ�����Bsubmit�̑O�ɂ��܂߂�file���Ă����������S�ł���B

�@���܂�SAS�v���O�����̎��s�ɐ�������ƁA�o�͂������OUTPUT�E�B���h�E�ɕ\������邱�ƂɂȂ�BCMS��SAS�ł́A���܂�SAS�v���O�����̎��s�ɐ������āA�o�͂�����A���̒i�K�ŁA�f�B�X�v���C��ʑS�ʂ�OUTPUT�E�B���h�E�ɐ�ւ��B

�@������ɂ���ASAS�v���O�����̎��s�����s���A���܂������Ȃ������ꍇ�ɂ́ALOG�E�B���h�E��ɓW�J���ꂽ���s���ʂ��������A���܂������Ȃ������������`�F�b�N����K�v������B���܂����s����Ȃ����������́A�قƂ�ǂ��v���O�����̕��@��̌���R�}���h�̒Ԃ蓙�̌��ŁA�����̓G���[�Ƃ��āALOG�E�B���h�E�ɕ\�������B���������v���O������̃G���[�̓o�O(bug����)�ƌĂ�A�G���[���炯�Œ��H����Ԃ̃v���O�����͓����Ȃ��BLOG�E�B���h�E�ɕ\������Ă��郁�b�Z�[�W�𒍈Ӑ[���������āA�G���[����菜���A�v���O�������C�����Ď��s�\�ȃv���O�����Ɏd�グ�邱�Ƃ𒎂���菜���Ƃ����Ӗ��Ńf�o�b�O(debug)�Ƃ����B

�@���S�҂��悭�����ŁA�������{�l���Ȃ��Ȃ��C�����Ȃ����́A���̂悤�Ȍ����ڂɂ͎��Ă��镶���A�L���̑ł��ԈႢ�ł���B

�@�f�o�b�O���邽�߂ɂ́A�܂����s�Ɏ��s����SAS�v���O�������Ăі߂��Ȃ���Ȃ�Ȃ��B�����ŁA(f�9)�L�[(��recall)�������āA���O�Ɏ��s�����v���O������PROGRAM EDITOR�E�B���h�E��ɌĂі߂��Ă���B�����ŁA���̌Ăі߂���Ă����v���O�����̏C�����s���A�ł�����܂����s�����Ă݂�B�����Z���v���O�����������āA�v���O��������x�Ő���Ɏ��s����邱�Ƃ͂߂����ɂȂ��B�ʏ�͉��x�����s�A�C���̃T�C�N�����J��Ԃ��āA�悤�₭�܂Ƃ��ɓ����v���O�������ł�����̂ł���B���ꂾ���ɁA�����őg�v���O���������ۂɓ������Ƃ��ɂ́A����Ȃ�̊�����������̂ł���B���̊����𖡂키���߂ɂ��A�����ł��������ɁA���܂߂Ƀf�o�b�O���邵���Ȃ��̂ł���B

�@PROGRAM EDITOR�E�B���h�E���SAS�v���O�����́A���̂܂�SAS���I�����Ă��܂��Ǝ����Ă��܂��B�����ŁA��������SAS�v���O�����́A�t�@�C���Ƃ��ĕۑ����Ă������B�l�Ԃ̎��ƂƂ͈Ⴂ�A�v���O�����ƃf�[�^�����ۑ����Ă����A�ǂ�Ȃɒ����o�͌��ʂł����Ă��A�R���s���[�^�̏����ɂ�100%�̍Č���������BSAS�v���O�������t�@�C���Ƃ��ĕۑ����邽�߂ɂ́A���ɁA(3)�ł��q�ׂ��悤�ɁA

�@�@�@Command ===> FILE '�t�@�C����'

�Ɠ��͂���B�������邱�ƂŁAPROGRAM EDITOR�E�B���h�E��ɂ���SAS�v���O�������APC��SAS�ł͎w��t�@�C������MS-DOS�t�@�C���ɁACMS��SAS�ł͎w��t�@�C������CMS�t�@�C���ɂ��ꂼ�ꏑ���o����A�ۑ������B�܂��ɁA�t�@�C�������̂ł���B

�@�ȏ�̂悤�ȍ�Ƃ��s���āASAS���I������ۂɂ́A

�@�@�@Command ===> BYE

�Ɠ��͂���悢�B�������A����SAS�I���ɂ���āAPROGRAM EDITOR�E�B���h�E��SAS�v���O�����������邾���ł͂Ȃ��ALOG�E�B���h�E�AOUTPUT�E�B���h�E�̓��e��������B���́ALOG�E�B���h�E�AOUTPUT�E�B���h�E�̓��e�́A�r��clear�R�}���h�����s���Ȃ�����ASAS���N�����Ă���I������܂�(������Z�b�V�����ƌĂ�)�̊ԁA�����邱�ƂȂ��~�ρA�ۑ�����Ă���̂ł���B���������āA��ʂ��X�N���[�������邱�ƂŁA���̃Z�b�V�����ł���܂łɎ��s����Ă��������ʂ��Q�Ƃ��邱�Ƃ��\�ł���B���̂��Ƃ����邽�߂ɁA�Z�b�V���������܂蒷�������āA�v���O�����𗬂������Ă���ƁA�L���A�~�ς����e�E�B���h�E�̓��e���c��ɂȂ肷���āA�v���O�������s�̍ۂُ̈�I���̌����Ƃ��Ȃ�̂ŁA�Ƃ��ǂ��̓E�B���h�E�̓��e��clear���邩�A���邢�͂������̂��Ǝ��XSAS�Z�b�V�������I�������������悢�B

�@���̂悤�ɁAbye�R�}���h�ɂ���āALOG�E�B���h�E�AOUTPUT�E�B���h�E�̓��e�������邪�A���ɏq�ׂ��悤�ɁA���ꂼ��̃E�B���h�E��file�R�}���h���g���AMS-DOS�t�@�C�����邢��CMS�t�@�C���Ƃ��ĕۑ����邱�Ƃ͉\�Ȃ̂ŁA�K�v�Ȃ��������Ƃ悢�B

�@SAS�v���O�����́ASAS���ƌĂ�镶�ɂ���č\���������̕��͂ł���BSAS����SAS�V�X�e���ɑ��Ă��鏈���������邽�߂̖��ߕ�������ASAS�V�X�e�����ǂ�ŗ����ł���悤�Ȍ`���A���@�ŏ����ꂽ���̂łȂ��Ă͈Ӗ����Ȃ��B�eSAS���͌`���I�ɂ� ";" (�Z�~�R����)�ŏI�����܂߂�������ł��邪�A

�@�������A"*" �Ŏn�܂�SAS���̓R�����g�Ƃ݂Ȃ���ASAS�V�X�e���͓ǂݔ�����ƂɂȂ��Ă���B�܂�A"*" �Ŏn�܂�R�����g���́ASAS�V�X�e���̂��߂ɂł͂Ȃ��A�v���O�����쐬�Ҏ��g���܂߂��l�Ԃ̂��߂ɏ��������̂ł���B���ہA�N�����l�̂��߂Ƃ��������A�����̎������v���O�����̓��e�𗝉��ł���悤�ɂ��邽�߂ɁA�v���O�����̉�����R�����g�̌`�œ���Ă����������悢�B

�@SAS�́A���p�҂��쐬�����f�[�^�E�Z�b�g�ɑ��āA���p�҂��w�肵�A�Ăяo�����e�퓝�v�p�v���O����(SAS�ł͂��̂悤�ɂ��炩���ߗp�ӂ��ꂽ���ꂼ��̃v���O�������v���V�W��(procedure)�ƌĂ�ł���)���@�\�I�Ɍ��ѕt���邽�߂̃V�X�e���ł���B���p�҂�SAS�ɑ��āA�f�[�^�E�Z�b�g�̍쐬�Ɗ�]����v���V�W���̎w�肳���s���悭�A���Ƃ�SAS�����v�������s���Ă����̂ł���B���������āASAS�v���O�����́A��{�I�ɂ͎��̂Q��ނ̃X�e�b�v�̌J��Ԃ��Ƃ��č\�������B

�@DATA�X�e�b�v�ō쐬�E���H�̑ΏۂƂȂ�APROC�X�e�b�v�œ��v�����̑ΏۂƂȂ�SAS�f�[�^�E�Z�b�g�́A����Ȍ`���̃t�@�C���ł���B����̓I�ɁA����[�����������ꍇ��z�肷��Ƃ킩��₷�����A�����Ώۂł���e�l�A�����SAS�ł̓I�u�U�[�x�[�V���� (observation)�ƌĂ�ł��邪�A���̃I�u�U�[�ׁ[�V�������ƂɁA�e����ɑ����\�`���ɂ܂Ƃ߂Đ����������̂ƂȂ��Ă���BSAS���ɂ����ASAS�f�[�^�E�Z�b�g�̓I�u�U�[�x�[�V�����ԍ�1, 2, 3,...���ƂɁA�������̕ϐ�(variable)�A�Ⴆ��X1, X2, X3,...�ɑ���f�[�^�l���������\2.3�̂悤�ȕ\�`���̃t�@�C���Ƃ������ƂɂȂ�B����Ε\�`���̃f�[�^�E�x�[�X�ł���B

�\2.3�@SAS�f�[�^�E�Z�b�g�̍\��

| �I�u�U�[�x�[ �V�����ԍ� | �ϐ� | |||

|---|---|---|---|---|

| X1 | X2 | X3 | �@�������@ | |

| 1 | ||||

| 2 | ||||

| 3 | ||||

| : : | ||||

�@SAS�f�[�^�E�Z�b�g�ɂ́A

�@SAS�f�[�^�E�Z�b�g�͌��̃f�[�^�E�t�@�C���ɔ�ׂ�Ƃ��Ȃ�傫�ȗe�ʂ�K�v�Ƃ���BPC��SAS�ł́A���̏͂Ō�q�����{�^�v���O�����ł�82.5KB���x�̃f�[�^�E�t�@�C������607.5KB���x��SAS�f�[�^�E�Z�b�g����������A7.4�{�ɂ��Ȃ�B�ʏ�͂����Ƒ��푽�l�ȕϐ����쐬�����̂ŁA�Ⴆ�A���̏͂̒ʏ�^�v���O�����ł́A�����f�[�^�E�t�@�C������1.2MB���x��SAS�f�[�^�E�Z�b�g�����������B����14.5�{�ł���B�ꎞSAS�f�[�^�E�Z�b�g�ł��ASAS�I�����܂ŏ�������Ȃ��̂ŁA1���SAS�Z�b�V�����̊ԂɁA�قȂ閼�O�̈ꎞSAS�f�[�^�E�Z�b�g������������ƁA��e�ʂ̌Œ�f�B�X�N�ł��A�����Ƃ����Ԃɋ̈���g���s�������ƂɂȂ�̂ŁA���ɁA�p�[�\�i���E�R���s���[�^��SAS���g���ꍇ�ɂ́A�ł��邾���������O��SAS�f�[�^�E�Z�b�g���J��Ԃ��J��Ԃ��g�p���������A�f�B�X�N�e�ʂ̐ߖ�ɂȂ�B�܂��ASAS�f�[�^�E�Z�b�g�̐����ɂ́A���̓s�x���Ԃ�������̂ŁA���C���t���[���Ȃ�Ƃ������A�p�[�\�i���E�R���s���[�^�ł͓����ꎞSAS�f�[�^�E�Z�b�g�����x����������͎̂��Ԃ̖��ʂł���B���̂��߁A�{���ł́A��x�A�i�vSAS�f�[�^�E�Z�b�g�����Ă����A��̃v���O�����͂�����J��Ԃ��ė��p���邱�Ƃ������Ƃ��Ă���B

�@SAS�ł͕ϐ����͉p���Ŏn�܂�8�����ȓ��̉p�����Ƃ��邱�ƂɂȂ��Ă���B�ő�4,000�܂ŕϐ����`���邱�Ƃ��\�ł���B�܂��A�ϐ��ɂ͐��l�f�[�^�������f�[�^���^���邱�Ƃ��ł���B�������A�ϐ��ɕ����f�[�^��^����ۂɂ́A���ꂪ�����f�[�^�ł��邱�Ƃ�����K�v������B��̓I�ɂ́A�����f�[�^�� '�@' �ň͂ނ��ƂŁA�Ⴆ��

�@�@�@'123'�@'ABC'�@'ASA100'

�̂悤�ɁA���ꂪ�����f�[�^�ł��邱�Ƃ�����B���������āA123�͕S��\�O�Ƃ����u���l�v�ł��邪�A'123' ��123�Ƃ����u�����v�܂蕶����ł��邱�Ƃ��Ӗ����Ă���B�ϐ��̂Ƃ肤��l�́A���l�f�[�^�̏ꍇ�ɂ� �}10-73�`1073 �͈̔́A�����f�[�^�̏ꍇ�ɂ� 1�`200����(�o�C�g)�ł���B

�@����[�����̏ꍇ���l����Ƃ킩��悤�ɁA���������ۂɍs���ƁA�ꕔ���̎���[�Ƃ����̂��A������x�̊����ŏo�Ă��邱�ƂɂȂ�B�܂�A�I�u�U�[�ׁ[�V�����ɂ���ẮA���ۂɂ͒l�̑��݂��Ȃ��ϐ������������݂��邱�ƂɂȂ�B���������ꍇ�ɂ́ASAS�V�X�e���ɕϐ��̒l���u�������Ă���v�Ƃ������ƒm�点�邽�߂ɁA�f�[�^�E�G���g���[���s���ۂɁA���炩�́u�l�v��^���Ȃ��Ă͂Ȃ�Ȃ��B���́u�l�v�̂��Ƃ������l�ƌĂсASAS�ł͕ϐ��ɕ\2.4�̌����l��^���Ă����ƁASAS�����v�������s�Ȃ��ۂɁA�����Ώۂ̕ϐ��������l�ł���I�u�U�[�ׁ[�V�����ɂ��ẮA���炩���߂������������Ŋe�폈�����s���邱�ƂɂȂ��Ă���B

�\2.4�@�����l

| ���l�ϐ� | �����ϐ� | |

|---|---|---|

| �����l�������f�[�^ |

|

|

| ���Ɍ����l�Ƃ��Ĉ�������̓f�[�^ |

|

|

�@�܂��ASAS�v���O�����̒��ł͕ϐ��������X�g��ɕ��ׂėp������A�����悤�ȕϐ��������������肷��悤�ȃP�[�X���N����B���́A���̕����v���O�����������ۂɂ͊y�Ȃ̂ł���B�Ȃ��Ȃ�A�Ⴆ�A�܂̕ϐ�����ׂ�

�@�@�@X1 X2 X3 X4 X5

�̂悤�ȏꍇ�ɂ́A

�@�@�@X1-X5

�Ƃ����ȗ��`���g���邩��ŁA����͂ƂĂ��֗��ł���B��ʓI�ɂ́AXm-Xn �ƋL���ƁAXm����Xn�܂ł̂��ׂĂ̕ϐ�(m<n)��\�����ƂɂȂ�B���l�ɁAX--Z �ƋL���ƁASAS�v���O��������X����Z�܂ł̊Ԃɒ�`���ꂽ���ׂĂ̕ϐ���\�����ƂɂȂ�B���̂ق��ɂ��A

�@�@�@_ALL_ �c�c���ׂĂ̕ϐ�

�@�@�@_NUMERIC_ �c�c���ׂĂ̐��l�ϐ�

�@�@�@_CHARACTER_�c�c���ׂĂ̕����ϐ�

�̂悤�ȏȗ��`���p�ӂ���Ă���B

�@�Ƃ���ŁA�ϐ������l���o���Ƃ����̂́A�ӊO�Ƒ�ςȍ�Ƃł���B�ϐ��̐���������قǂ��̑�ς��͐g�ɐ��݂Ă���B���ہA�ϐ������l�����{�l�ł���A�ϐ��������������ł́A���̕ϐ����ǂ̎��⍀�ڂɑΉ����Ă����̂����킩��Ȃ��Ȃ��Ă��܂��B�������A�ϐ��������G�ō������Ă������قǁA�����قǂ̂悤�ȕϐ����̏ȗ��`���g���ɂ����Ȃ��Ă���̂ł���B�����ŁA�����߂Ȃ̂́A�M�҂����s���Ă��邿����Ƃ����H�v�ł���B��6���ł��G��邪�A�܂��A�ϐ������X�g�̏ȗ��`���g���₷���悤�ɁA�ϐ����̖����͐���������̏��ɕt�������̂��悢�B�܂��ϐ����͉p������n�߂Ȃ��Ă͂����Ȃ��B���������āA����[�̐v�i�K�ŁA���O�Ɏ���ԍ���

�@�@�@�A���t�@�x�b�g�܂��̓��[�}�����ɂ��啪�ށm�{�����ށn�{�����ɂ�鏬����

�Ƃ����\���ɂ��Ă����̂ł���B�Ⴆ�A

�@�@�@����ԍ��@�@II.3�@�@IV.4�@�@A.III.5�@�@D.IX.9

�@�@�@�ϐ����@�@�@II3 �@�@IV4 �@�@AIII5 �@�@DIX9

�Ƃ����悤�ɂ���ƁA�ȒP�ɕϐ������t�����邵�A�t�ɕϐ���������A���̎���ԍ��������ɂ킩��̂ł���BSAS�v���O�����ŕϐ������`����Ƃ��Ɏ���[�̎���ԍ������̂܂ܕϐ����ɂ��邱�Ƃ��ł��āA�֗��ŊԈႢ�����Ȃ��B�������A�ϐ�����8�����ȓ��Ȃ̂ŁA����ԍ������߂�Ƃ��ɂ͂Ȃ�ׂ��V���v���ɂ��������悢���Ƃɕς��͂Ȃ����c�c�B�ϐ��̋�̓I�ȈӖ����e�ɂ��ẮA�ϐ����ɔ��f������̂ł͂Ȃ��A��q����悤�ȕϐ����x����p���������悢�B����ŏo�͎��ɕ\�����邱�Ƃ��ł��A���̍ۂɂ͎���������40�����ȓ��Ƒ啝�Ɋɂ��Ȃ��Ă���A���{��A�����Ȃǂ��g���A�͂邩�Ɏ��p�I�ł���B

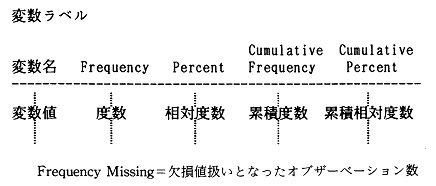

�@���̐߂ł́A���ۂɊȒP��SAS�v���O�������쐬���A�f�[�^�E�G���g���[�ƒP���W�v�y�щi�vSAS�f�[�^�E�Z�b�g�̐������s���Ă݂悤�B���̈�A�̃v���Z�X��SAS�v���O�����̊�{�𗝉����Ă��炤���߂ɁA���̐߂ł́A�����Ƃ��V���v���Ȋ�{�^SAS�v���O���������グ��B���̊�{�^�v���O������i��������`�ŁA���̐߂ŁA�M�҂����ۂɒ����̂Ƃ��Ɏg�p����ʏ�^SAS�v���O�����ւƔ��W������B�����Ƃ��A��{�^�v���O�����ł��~���o���˂A�\�����p�ɂȂ�B

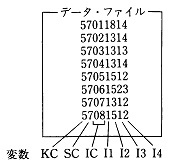

�@�Ⴆ�A��6���Œ����̎���Ƃ��Ă�����u�g�D�������̂��߂̏]�ƈ��ӎ������v�œ���ꂽ�́A�����[�̂܂܂ł́A�l�Ԃɂ͓ǂ߂Ă��A�R���s���[�^��SAS�͓ǂݎ�邱�Ƃ��ł��Ȃ��B�����ł܂��ŏ��ɁA�R���s���[�^��SAS���ǂݎ��\�Ȍ`�̃f�[�^�ɏ��������Ă��K�v������B��̓I�ɂ́A���f�[�^�l�Ƃ��āA����K���ɑ����ăf�B�X�v���C��ʏ��t�@�C����ɏ������ׂĂ��̂ł���B������f�[�^�E�G���g���[�Ƃ����B�悭�p�������\�I�ȃf�[�^�l�̏������ו��ɂ͎��̓�̌`��������B

���ꂼ��ɑΉ�����`�ŁA��q����INPUT���̕ϐ����̕��т̌`��������B�����̌`�����悭�g������͂̎d���ɂ��āA���ꂼ���̓I�ɐ������Ă������B

�@�����SAS�v���O���������ɒ��ڃf�[�^���������ޕ��@�ł���B���X�g�`���ł́A���X�g���͂��s���A�ϐ����̕��тɑΉ������Ȃ���f�[�^�l��ǂݍ��ށB��ʓI�ɂ́A�ϐ����̕��т́AINPUT����

�@�@�@INPUT �ϐ���1 �ϐ���2�@�c�c;

�Ƃ��̂܂ܕϐ������������ׂ�`�����Ƃ�B���X�g���͂̏ꍇ�A�f�[�^�l�͋ɂ���ċ����Ƃ������Ƃ̑��ɁA

�Ȃǂɒ��ӂ��Ȃ��Ă͂Ȃ�Ȃ��B

�@���܁A���̕����Ńf�[�^����͂��A�i�vSAS�f�[�^�E�Z�b�g�����邱�Ƃ��l���悤�BPC��SAS�ł́A���̂悤�ɂ���B

| PC��SAS |

|---|

|

LIBNAME libname '���p�X��'; DATA libname.�i�vSAS�f�[�^�E�Z�b�g���{��; INPUT �ϐ����̕���; CARDS; �@�@�@�@�@�@�@�@�f�[�^�s ; |

| ��) |

|---|

|

LIBNAME SAVE '��MYDIR'; DATA SAVE.JPC; INPUT KC SC IC I1-I4; CARDS; 5 7 01 1 8 1 4 5 7 02 1 3 1 4 5 7 03 1 3 1 3 5 7 04 1 3 1 4 5 7 05 1 5 1 2 5 7 06 1 5 2 3 5 7 07 1 3 1 2 5 7 08 1 5 1 2 ; |

�@PC��SAS�ł́A�i�vSAS�f�[�^�E�Z�b�g�̃t�@�C�����̊g���q�͕K�� "SSD" �Ƃ��Đ��������B���̃v���O������̏ꍇ�ɂ́A"JPC.SSD" �Ƃ����t�@�C�����̉i�vSAS�f�[�^�E�Z�b�g��MS-DOS�t�@�C���Ƃ��Đ�������邱�ƂɂȂ�BLIBNAME���ł́A���̉i�vSAS�f�[�^�E�Z�b�g���ǂ��̃f�B���N�g���̉��ɐ��������̂����������߂̃p�X�����w�肳���BLIBNAME���ł��̃p�X���ƑΉ��Â���ꂽlibname (���C�u�����Q�Ɩ�)���A�p�X���̑���ɁA����SAS�Z�b�V�����̊ԁA�p�����邱�ƂɂȂ�B

�@���̃v���O������̏ꍇ�ł́AMYDIR �Ƃ����p�X���� "SAVE" �Ƃ���libname�Ɍ��ѕt���Ē�`���Ă���B���̎w��ɂ��A�i�vSAS�f�[�^�E�Z�b�gJPC.SSD�̓f�B���N�g��MYDIR�̉��ɐ�������邱�ƂɂȂ�ƂƂ��ɁA"SAVE.JPC" �� "��MYDIR��JPC.SSD" ���Ӗ����邱�ƂɂȂ�B

�@CMS��SAS�ł́APC��SAS�̂悤��libname�̎w�肪����Ȃ��B���ɁA��4��(2)(b)�ŏq�ׂ��悤�ɁACMS��SAS�ł́A�i�vSAS�f�[�^�E�Z�b�g����ft.fn ��ft����ɂ��邪�A����2���x�����̎w�肾���Ŏ����I�ɉi�vSAS�f�[�^�E�Z�b�g����������Alibname�͕K�v���Ȃ��B���������āACMS��SAS�ł�PC��SAS�ł͕K�v������1�s�ڂ�LIBNAME���͂����A2�s�ڂ�DATA������n�߂�B���̍ہA�`�̏�ł�PC��SAS��DATA������libname���w�肵�Ă����Ƃ���ŁACMS��SAS�ł͉i�vSAS�f�[�^�E�Z�b�g����ft���w�肷�邱�ƂɂȂ�(ft��WORK�ɂ���ƁA�ꎞSAS�f�[�^�E�Z�b�g�Ƃ��ĔF������Ă��܂��̂ŁA����ȊO�̂��̂ɂ��邱��)�BCMS��SAS�ł́A���̂悤�Ɏw�肷�邾���ŁCSAS�f�[�^�E�Z�b�g�͉i�vSAS�f�[�^�E�Z�b�g�ƂȂ�ADATA�X�e�b�v�ōs�������H�����́A���̂܂�CMS�t�@�C���Ƃ��ĕۊǂ���邱�ƂɂȂ�B���������āA�`���I�ɂ́APC��SAS�̃v���O������̂P�s�ڂ��폜�������̂��A���̂܂�CMS��SAS�̃v���O������ƂȂ�B���Ȃ킿�A

| CMS��SAS |